近年、AR(拡張現実)や自動運転、ロボティクスといった分野の発展に伴い、「SLAM」という技術が注目を集めています。スマートフォンでARゲームをプレイする際にキャラクターが床や机の上に正しく表示されたり、お掃除ロボットが部屋の隅々まで効率的に掃除できたりする背景には、このSLAM技術が活用されています。

しかし、「SLAM」という言葉自体は聞いたことがあっても、その具体的な仕組みや種類、なぜそれほど重要なのかを正確に理解している方はまだ多くないかもしれません。

この記事では、SLAM技術の基本から、その核心である仕組み、主な種類、そしてARをはじめとする多様な分野での活用事例までを網羅的に解説します。さらに、導入のメリットや現時点での課題、開発に利用できるツールにも触れ、SLAM技術の全体像を深く理解できるよう構成しています。

本記事を通じて、SLAMが単なる専門用語ではなく、私たちの生活やビジネスを支え、未来のデジタル社会を形作る上で不可欠なコア技術であることを実感いただけるはずです。

目次

SLAM技術とは

まず、SLAM技術の基本的な概念とその重要性について解説します。SLAMは、センサーを使って周囲の環境を認識し、「自分が今どこにいるのか」を把握しながら、「周辺の地図を作る」という2つの処理を同時に、かつリアルタイムに行う技術の総称です。この技術があるからこそ、GPSが利用できない環境でも、機械が自律的に移動したり、現実空間とデジタル情報を正確に連携させたりできます。

自己位置の推定と地図作成を同時に行う技術

SLAM技術の核心は、その名称に集約されています。SLAMとは「Simultaneous Localization and Mapping」の頭文字を取った略語であり、日本語では「自己位置推定と環境地図作成の同時実行」と訳されます。

この2つの要素を分解して考えてみましょう。

- Localization(自己位置推定): センサーから得られる情報をもとに、デバイス(ロボット、スマートフォン、自動車など)が環境内のどこに、どのような向きで存在しているのか(位置と姿勢)を特定するプロセスです。自分がどこにいるか分からなければ、目的地に向かったり、元の場所に戻ったりすることはできません。

- Mapping(環境地図作成): センサーで周辺の環境を観測し、壁、床、障害物などの位置関係をデータ化して、地図(マップ)を生成・更新していくプロセスです。地図がなければ、自分が今いる場所がどのような環境なのかを理解できません。

ここで重要なのが「Simultaneous(同時に)」という点です。自己位置推定と地図作成は、実は互いに深く依存し合う「鶏が先か、卵が先か」のような関係にあります。

- 正確な地図がなければ、正確な自己位置は分からない:初めて訪れる街で地図がなければ、自分がどこにいるのかを特定するのは困難です。

- 正確な自己位置が分からなければ、正確な地図は作れない:自分がどこから景色を眺めているのかが分からなければ、見たものを正確に地図に描き込むことはできません。

SLAM技術は、この相互依存の問題を解決するために生まれました。未知の環境に置かれたデバイスが、不確かな情報から出発し、自己位置の推定と地図作成を少しずつ繰り返し実行することで、両方の精度を相互に高め合っていくという、高度なアプローチを取ります。動き始めは不正確な地図と自己位置からスタートしますが、移動を続けることで観測データが増え、徐々に信頼性の高い地図と正確な自己位置を得られるようになります。このプロセスこそが、SLAM技術の最も独創的で強力な点です。

SLAMの読み方と正式名称

前述の通り、SLAMの正式名称は「Simultaneous Localization and Mapping」です。読み方は、そのままアルファベットを読んで「エスエルエーエム」ではなく、「スラム」と読むのが一般的です。

この技術の概念は、1980年代後半からロボット工学の分野で研究が始まりました。当初は、移動ロボットが未知の環境を探査し、自律的にナビゲーションするための基盤技術として開発が進められました。初期のSLAMは計算コストが非常に高く、特殊なセンサーと強力なコンピュータを必要とする、研究室レベルの技術でした。

しかし、その後の数十年間でコンピュータの処理能力は飛躍的に向上し、カメラやセンサーは小型化・低価格化が進みました。この技術革新の波に乗り、SLAMは研究室を飛び出し、私たちの身の回りにある様々な製品に応用されるようになったのです。特に、スマートフォンに高性能なカメラとプロセッサが搭載されるようになったことで、Visual SLAM(後述)が爆発的に普及し、ARアプリケーションなどを通じて一般の消費者にもその恩恵が届くようになりました。

GPSが使えない環境で活躍するSLAMの重要性

私たちは日常的にスマートフォンの地図アプリなどでGPS(Global Positioning System)を利用しています。GPSは、人工衛星からの電波を受信して現在位置を特定する非常に便利な技術ですが、万能ではありません。GPSには明確な弱点が存在します。それは、衛星からの電波が届かない場所では機能しないということです。

具体的には、以下のような環境でGPSは利用できません。

- 屋内:建物の中(ショッピングモール、オフィス、工場、自宅など)

- 地下:地下鉄の駅、地下街、駐車場

- 水中:海や川の中

- 都市部のビル街:高層ビルに電波が遮られたり、反射したりして精度が著しく低下する(マルチパス問題)

- トンネル内

一方で、現代のテクノロジーが応用される現場は、こうしたGPSの苦手な環境が非常に多く含まれています。例えば、以下のようなケースを考えてみましょう。

- AR(拡張現実): 部屋の中に仮想の家具を配置したい場合、スマートフォンのカメラが部屋の中での正確な位置と向きを把握する必要があります。GPSは室内では機能しないため、SLAMが不可欠です。

- お掃除ロボット: 家の中を効率的に掃除するには、部屋の間取りを記憶し、自分が今どこにいるかを常に把握しなければなりません。これもSLAMの役割です。

- 自動運転: GPSは車両の大まかな位置を把握するのには役立ちますが、車線を維持したり、前方の車両との距離を正確に保ったりするには、より高精度な自己位置推定が必要です。特にトンネル内やビル街ではGPSの信頼性が落ちるため、SLAMなどの他のセンサー技術で補完することが絶対条件となります。

- ドローン: 橋梁の下や工場内など、GPSが使えない場所での点検・監視飛行には、SLAMによる自律的なナビゲーションが求められます。

このように、SLAMはGPSを補完し、あるいはGPSが全く利用できない環境で「機械の眼」として機能することで、テクノロジーの応用範囲を屋内や複雑な環境へと劇的に押し広げました。もしSLAM技術がなければ、今日私たちが当たり前のように利用している多くのARアプリや自律型ロボットは実現不可能だったでしょう。この点が、現代社会におけるSLAM技術の極めて高い重要性を示しています。

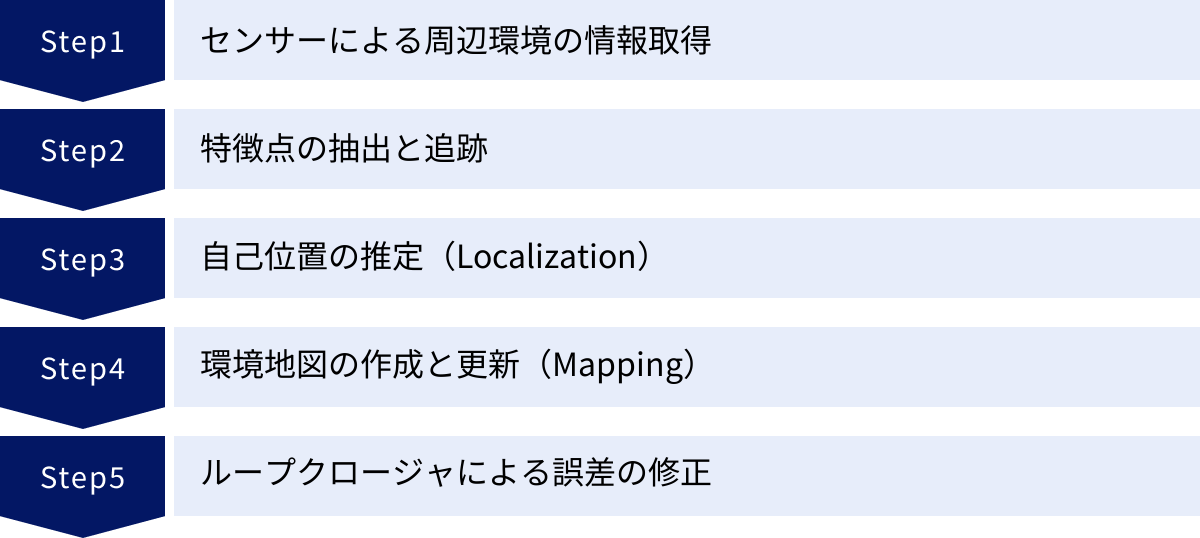

SLAM技術の基本的な仕組みと処理の流れ

SLAM技術が「自己位置推定」と「地図作成」を同時に行うことは理解できましたが、具体的にどのようなプロセスを経てそれを実現しているのでしょうか。ここでは、SLAMの内部で実行されている一連の処理の流れを、5つのステップに分けて分かりやすく解説します。これらのステップは連続的かつ高速に繰り返され、リアルタイムでの動作を可能にしています。

センサーによる周辺環境の情報取得

SLAMのすべてのプロセスは、センサーを使って外界の情報を取得することから始まります。どのようなセンサーを使うかによってSLAMの種類や特性が大きく変わりますが、主に以下のようなセンサーが用いられます。

- カメラ(単眼、ステレオ、RGB-D): 周囲の映像を撮影します。カメラは、色やテクスチャといった豊富な視覚情報を取得できるため、特徴点の識別に優れています。また、非常に安価で小型なため、スマートフォンなどの民生機器に広く搭載されています。これはVisual SLAMの根幹をなすセンサーです。

- LiDAR(Light Detection and Ranging): レーザー光を照射し、その光が物体に当たって跳ね返ってくるまでの時間を計測することで、物体までの正確な距離を測定します。これにより、周囲の環境を3次元の「点群(Point Cloud)」データとして直接的に取得できます。暗い場所でも高精度な測定が可能ですが、比較的高価で大型になる傾向があります。

- IMU(Inertial Measurement Unit / 慣性計測装置): 加速度センサーとジャイロセンサーを組み合わせたものです。デバイスの加速度(どの方向にどれだけ加速したか)と角速度(どの軸周りにどれだけ回転したか)を検出します。IMUはカメラのように外部環境を見るのではなく、自身の動きそのものを計測します。

これらのセンサーから取得された生データ(映像、点群、加速度など)が、後続の処理の入力となります。例えば、カメラは1秒間に30回(30fps)や60回(60fps)といった頻度で新しい画像フレームを捉え、SLAMシステムに送り続けます。

特徴点の抽出と追跡

センサーが環境情報を取得したら、次はそのデータから「特徴点(Feature Point)」を見つけ出します。特徴点とは、画像や点群データの中で、他と区別しやすく、追跡に適した目印となる点のことです。

例えば、カメラで撮影された映像の場合、以下のような箇所が特徴点として選ばれやすいです。

- コーナー(角): 明るさの変化が複数の方向で大きい部分。

- ブロブ(塊): 周囲とはっきり区別できる模様や色の塊。

- エッジ: 明暗の境界線。

なぜ特徴点が必要かというと、画像全体のピクセルをすべて比較するのは計算量が膨大になりすぎるためです。そこで、環境を代表する少数の「ランドマーク」として特徴点を抽出し、それらの動きを追跡することで、効率的に自己位置の変化を計算します。ORB、SIFT、SURFといった様々な特徴点記述子(アルゴリズム)が、特徴点を効率的に見つけ出し、その点周辺の情報を数値化(ベクトル化)するために用いられます。

特徴点が抽出されると、システムは連続する画像フレーム間でこれらの特徴点を「追跡(トラッキング)」します。前のフレームの画像Aで見つかった特徴点Pが、現在のフレームの画像Bではどの位置に移動したかを探し出す処理です。この対応付け(マッチング)が成功することで、カメラがその間にどれだけ移動・回転したかを推定する手がかりが得られます。

自己位置の推定(Localization)

特徴点の追跡ができたら、いよいよ自己位置(Localization)を推定します。これは、連続するフレーム間での特徴点の見え方の変化を基に、センサー(=デバイス)自身の動きを逆算するプロセスです。

例えば、Visual SLAMでは、主に三角測量の原理が応用されます。

- カメラが位置Aからある特徴点Pを見ます。

- 次にカメラが少し移動して位置Bから同じ特徴点Pを見ます。

- このとき、位置Aと位置Bの間の移動量(基線長)と、それぞれの位置から特徴点Pを見たときの角度が分かれば、三角形の幾何学的な関係から特徴点Pまでの距離を計算できます。

実際には、多数の特徴点の動きを同時に考慮し、統計的な最適化計算(バンドル調整など)を行うことで、最も確からしいカメラの移動量(並進と回転)を算出します。この計算により、「前のフレームから現在のフレームまでに、カメラはX方向に何cm、Y方向に何cm移動し、Z軸周りに何°回転した」といった情報が得られます。これを連続的に行うことで、スタート地点からの累積的な位置と姿勢を追跡し続けることができます。

環境地図の作成と更新(Mapping)

自己位置が推定できると、次はその情報を利用して環境地図(Mapping)を作成・更新します。推定された自己位置(カメラがどこから見ているか)と、その位置から観測された特徴点の情報(どの方向に見えるか)を組み合わせることで、各特徴点の3次元空間における座標を決定し、地図上に配置していきます。

SLAMで作成される地図には、主に2つの種類があります。

- スパースマップ(疎な地図): 自己位置推定に必要最低限な特徴点の3次元座標のみで構成される、点群のまばらな地図です。計算コストが低く、高速な自己位置推定に適しています。多くのリアルタイムSLAMシステムでは、まずこのスパースマップが構築されます。

- デンスマップ(密な地図): スパースマップを基に、画像全体のピクセル情報を活用して、壁や床などの表面形状を密な点群やメッシュで復元した地図です。ARでのオクルージョン(後述)表現や、詳細な3Dモデルの作成、ロボットの障害物回避などに利用されます。計算コストは非常に高くなります。

デバイスが動き回り、新しい領域を観測するたびに、新しい特徴点が地図に追加され、既存の特徴点の位置はより正確な値に更新されていきます。このようにして、自己位置推定と地図作成は、互いの結果を利用しながら精度を高め合うループを形成します。

ループクロージャによる誤差の修正

SLAMには、「ドリフト」という根本的な課題が存在します。自己位置推定はフレーム間の相対的な動きを計算し、それを積み重ねていくため、各ステップで発生するごくわずかな測定誤差や計算誤差が時間と共に蓄積していきます。その結果、長時間動作させると、推定された自己位置と実際の自己位置が徐々に乖離していってしまいます。例えば、まっすぐ進んだはずなのに、地図上では少しずつカーブしてしまったり、出発点に戻ってきたはずなのに、地図上では出発点からずれた位置にいる、といった現象が起こります。

このドリフト問題を解決するための重要なプロセスが「ループクロージャ(Loop Closure / ループ検出・閉鎖)」です。これは、デバイスが以前に通過した場所に戻ってきたことを検出し、蓄積された誤差を全体的に補正する仕組みです。

ループクロージャの処理は以下のように行われます。

- ループ検出: 現在観測している風景が、過去に作成した地図のどこかの部分と似ているかを常にチェックします。

- 誤差の計算: ループが検出されると(例:「今見ている場所は、1分前に通った場所だ」と認識されると)、地図上での現在の推定位置と、過去のその場所の位置との間に生じているズレ(誤差)の量が明らかになります。

- グラフ最適化: この誤差情報を制約条件として、ループ全体(移動の軌跡と地図上の特徴点)にわたって矛盾が最も少なくなるように、全体の形状をグローバルに最適化します。これにより、蓄積されていたドリフトが一気に解消され、地図全体の整合性が劇的に向上します。

ループクロージャは、SLAMの精度とロバスト性(安定性)を長期にわたって維持するための鍵となる技術です。これがあるおかげで、大規模な環境でも破綻することなく、一貫性のある地図を作成し続けることができます。

SLAM技術の主な種類

SLAM技術は、使用するセンサーやアルゴリズムの違いによって、いくつかの種類に分類されます。それぞれに得意なこと・苦手なことがあり、用途や環境に応じて最適な方式が選択されます。ここでは、まず主要なセンサーによる分類を紹介し、その後、最も普及しているVisual SLAMをさらに詳しく分類して解説します。

センサーによる分類

SLAMの性能や特性を最も大きく左右するのが、どのセンサーを主軸に据えるかです。ここでは代表的な3つの種類、Visual SLAM、LiDAR SLAM、Visual-Inertial SLAMを比較します。

| 種類 | 主要センサー | メリット | デメリット | 主な用途 |

|---|---|---|---|---|

| Visual SLAM | カメラ | 低コスト、豊富な情報量(色・テクスチャ)を取得可能、センサーが小型・軽量 | 明るさの変化や暗所に弱い、特徴の少ない場所に弱い、処理負荷が高い | AR/VR、コンシューマ向けロボット、スマートフォンアプリ |

| LiDAR SLAM | LiDAR(レーザースキャナ) | 高精度な距離測定、暗所でも安定して動作、環境の形状を直接的に把握可能 | 高コスト、センサーが比較的大型・高消費電力、色・テクスチャ情報が得られない | 自動運転車、産業用ロボット、高精度3Dマッピング |

| Visual-Inertial SLAM | カメラ + IMU | 高いロバスト性(速い動きや一時的な遮蔽に強い)、カメラの弱点を補完 | システムの複雑性が増す、IMUのドリフト誤差を適切に処理する必要がある | スマートフォンAR(ARKit/ARCore)、ドローン、VRヘッドセット |

Visual SLAM(カメラを使用)

Visual SLAM (vSLAM) は、その名の通り、カメラで撮影した映像(Visual)を主たる情報源として利用するSLAMです。最大のメリットは、カメラが非常に安価で、すでにスマートフォンやノートPC、Webカメラなど、あらゆるデバイスに標準搭載されている点です。これにより、特別なハードウェアを追加することなく、ソフトウェアだけでSLAM機能を実現できます。

また、カメラは色や模様(テクスチャ)といった豊富な情報を取得できるため、特徴点の識別や再認識(ループクロージャ)に有利です。しかし、その反面、環境の明るさに大きく依存するという弱点があります。暗すぎて何も見えない場所や、逆に太陽光がレンズに直接入るような状況では、特徴点の抽出が困難になり、トラッキングが失敗しやすくなります。また、真っ白な壁のような、特徴が何もない(テクスチャレスな)場所でも同様に機能しづらくなります。

LiDAR SLAM(レーザーセンサーを使用)

LiDAR SLAM は、LiDAR(Light Detection and Ranging)センサーを主軸に用いるSLAMです。LiDARは、レーザー光を周囲に照射し、物体からの反射光を検出することで、対象物までの距離を極めて高精度に測定します。これにより、環境の3次元的な形状を「点群データ」として直接的に取得できます。

LiDAR SLAMの最大の強みは、その精度の高さと安定性です。自ら光を発するため、カメラのように周囲の明るさに左右されることがなく、完全な暗闇でも問題なく動作します。そのため、自動運転車が夜間やトンネル内を走行する際の自己位置推定や、工場のAGV(無人搬送車)のナビゲーションなど、高い信頼性が求められる用途で広く採用されています。一方で、LiDARセンサー自体が高価であり、大型で消費電力も大きい傾向にあるため、スマートフォンなどの小型民生機器への搭載は限定的です。また、色やテクスチャの情報を得られないため、見た目が全く同じ形状の廊下が続くような場所では、ループクロージャが困難になる場合があります。

Visual-Inertial SLAM(カメラと慣性センサーを併用)

Visual-Inertial SLAM (VI-SLAM) は、カメラ(Visual)とIMU(Inertial Measurement Unit)を組み合わせた、ハイブリッドなSLAMです。これは、カメラとIMUが互いの長所で短所を補い合う、非常に強力な組み合わせです。

- カメラの弱点をIMUが補う: カメラは、速すぎる動きによるモーションブラーや、一時的にレンズが手で覆われるなどして視覚情報が途絶えると、トラッキングが失敗します。しかし、IMUは自身の動きを常に計測しているため、そうした状況でも短時間であれば自己位置の推定を継続できます。

- IMUの弱点をカメラが補う: IMUは加速度や角速度を積分して位置や姿勢を計算するため、時間と共に誤差がどんどん蓄積(ドリフト)していきます。カメラからの視覚情報を使うことで、このIMUのドリフトを定期的にリセットし、正確な位置を維持できます。

この高いロバスト性(頑健性)から、VI-SLAMは現在のスマートフォンAR(AppleのARKitやGoogleのARCore)や、VRヘッドセットのインサイドアウト方式トラッキング、ドローンの自律飛行などで標準的な技術となっています。複雑な現実世界で安定して動作させる上で、非常に効果的なアプローチです。

Visual SLAMのさらに詳しい分類

Visual SLAMは、使用するカメラの種類によって、さらに細かく分類されます。ここでは代表的な3つの方式、Monocular SLAM、Stereo SLAM、RGB-D SLAMについて解説します。

| 種類 | カメラ構成 | 特徴 | メリット | デメリット |

|---|---|---|---|---|

| Monocular SLAM | 単眼カメラ(1台) | 3D空間のスケール(絶対的な大きさ)が不定。初期化に動きが必要。 | 最も低コストでシンプル。あらゆるデバイスに適用可能。 | 奥行きの絶対値が不明。ドリフトが大きい傾向がある。 |

| Stereo SLAM | ステレオカメラ(2眼) | 人間の両目と同じ原理(三角測量)で深度を直接計測できる。 | スケールが確定するため、現実世界の大きさと一致した地図が作れる。 | カメラ間のキャリブレーション(位置合わせ)が必須。計算コストが増加する。 |

| RGB-D SLAM | RGBカメラ + 深度センサー | ピクセル単位で正確な深度情報を直接取得できる。 | 高精度で密な(デンスな)3D地図作成が容易。 | 専用の深度センサー(ToF方式や構造化光方式)が必要。計測範囲や屋外利用に制約がある場合も。 |

Monocular SLAM(単眼カメラ)

Monocular SLAMは、カメラ1台のみを使用するVisual SLAMです。スマートフォンやノートPCに搭載されている標準的なカメラで実現できるため、最も手軽で広く応用可能な方式と言えます。

しかし、Monocular SLAMには「スケール不定性(Scale Ambiguity)」という根本的な課題があります。単眼カメラで撮影した2D画像から3D構造を復元する場合、そのシーンの絶対的な大きさ(スケール)を決定できません。例えば、小さなミニチュアの部屋を見ているのか、実物大の部屋を遠くから見ているのかを、1枚の写真から判断できないのと同じ原理です。そのため、作成される地図や移動の軌跡は、現実のメートル単位とは異なる、ある相対的なスケールを持つことになります。また、奥行きを推定するために、カメラをある程度動かして視差を生み出す「初期化」というプロセスが必要です。

Stereo SLAM(ステレオカメラ)

Stereo SLAMは、人間の両目と同じように、少し離れた位置に固定された2台のカメラを使用するVisual SLAMです。2台のカメラで同時に撮影した左右の画像を用いることで、三角測量の原理に基づいて、特徴点までの奥行き(距離)を直接計算できます。

これにより、Monocular SLAMの課題であったスケール不定性の問題が解決されます。初めから現実世界のメートル単位と一致した、スケールが確定した地図を作成できるため、ロボットのナビゲーションや実寸でのAR表現において大きな利点となります。ただし、2台のカメラの相対的な位置関係を精密に調整(キャリブレーション)しておく必要があり、計算コストもMonocular SLAMより増加します。

RGB-D SLAM(深度センサー付きカメラ)

RGB-D SLAMは、通常のカラー情報(RGB)を取得するカメラと、各ピクセルの深度(Depth)情報を取得する深度センサーを組み合わせた「RGB-Dカメラ」を使用するSLAMです。深度センサーには、光が物体に反射して戻るまでの時間を計測するToF(Time of Flight)方式や、特定のパターン光を照射してその歪みから形状を読み取る構造化光(Structured Light)方式などがあります。

RGB-Dカメラを使うと、画像の全ピクセルに対して、直接的かつ正確な距離情報を得られるため、非常に高精度で密な(デンスな)3次元地図をリアルタイムに構築できます。これにより、物体の詳細な形状復元や、よりリアルなAR表現が可能になります。一方で、専用の深度センサーが必要になる点や、センサーの種類によっては計測可能距離が短かったり、太陽光の下など屋外での利用が苦手だったりする制約があります。近年のハイエンドスマートフォンやAR/VRデバイスには、この深度センサーが搭載されるケースが増えています。

AR(拡張現実)でSLAM技術が使われる理由

SLAM技術の応用分野の中でも、特に私たちの生活に身近なのがAR(Augmented Reality / 拡張現実)です。スマートフォンをかざすと現実の風景にキャラクターや情報が重なって表示されるAR体験は、SLAM技術なくしては成り立ちません。なぜARにSLAMが不可欠なのか、その2つの主要な理由を解説します。

仮想オブジェクトを現実空間に正しく配置するため

ARの最も基本的な要件は、「仮想のオブジェクトを、あたかもそこに実在するかのように、現実空間の特定の位置に固定して表示する」ことです。例えば、ARゲームで床の上に出現したキャラクターは、プレイヤーがスマートフォンを持って歩き回ったり、角度を変えたりしても、ずっと同じ床の上の位置に留まり続けなければなりません。

もしSLAM技術がなければ、スマートフォンは自身が空間内でどのように動いているかを全く把握できません。そのため、単にカメラ映像の上にCGを重ねるだけでは、少し動いただけでCGが背景からズレてしまい、全く現実感が得られないでしょう。

ここでSLAM技術が決定的な役割を果たします。

- ワールドトラッキング: SLAMは、スマートフォンのカメラから入ってくる映像をリアルタイムで解析し、周囲の環境の特徴点(壁の模様、家具の角など)を捉え続けます。そして、それらの特徴点の見え方がフレームごとにどう変化するかを基に、スマートフォン自身の3次元空間における位置と姿勢(向き)を常に追跡します。これを「ワールドトラッキング」と呼びます。

- 仮想オブジェクトの固定: ワールドトラッキングによってデバイスの正確な位置と姿勢が分かるため、仮想オブジェクトを空間内のある一点(例:X=1.5m, Y=0.2m, Z=2.0m)に固定できます。デバイスがどの位置からそのオブジェクトを見ても、常に正しいパースペクティブ(遠近感)で描画し直すことで、オブジェクトがその場に「張り付いている」かのような体験が生まれます。

さらに、多くのARプラットフォーム(ARKitやARCoreなど)は、SLAMの地図作成機能を発展させ、床や机、壁といった「平面」を自動的に検出する機能を提供しています。これにより、ユーザーは仮想オブジェクトを置きたい平面を直感的にタップするだけで、オブジェクトを水平・垂直面にぴったりと配置できます。これも、SLAMによって構築された環境の3Dマップ情報があって初めて可能になる機能です。

現実の物体との前後関係(オクルージョン)を表現するため

AR体験のリアリティをもう一段階引き上げるために重要な要素が「オクルージョン(Occlusion)」です。オクルージョンとは、「遮蔽」を意味し、ARにおいては、仮想のオブジェクトが現実の物体の後ろに隠れる表現を指します。

例えば、床に置いた仮想の猫が、歩いてきてテーブルの脚の後ろに回り込んだとします。このとき、猫の体の一部がテーブルの脚によって隠されれば、私たちはその猫が本当にその空間にいるかのような強い没入感を得られます。逆に、オクルージョンがなければ、テーブルの脚が透けて猫が手前に表示されてしまい、ARオブジェクトが単なる「貼り付けた絵」のように見えてしまいます。

このリアルなオクルージョンを実現するためには、SLAM技術が作成する環境地図が不可欠です。

- 環境の3Dメッシュ生成: 高度なSLAMシステム、特にRGB-D SLAMや最新のLiDARを搭載したデバイスのSLAMでは、特徴点だけのスパースマップだけでなく、現実空間の物体の形状を詳細な3Dメッシュ(ポリゴンの集合体)としてリアルタイムに再構築します。これにより、カメラは「目の前の空間のどこに物体の表面が存在するか」という深度情報を持つことができます。

- 前後関係の判定: ARシステムは、描画を行う際に、仮想オブジェクトの各ピクセルと、それに対応する現実空間の3Dメッシュの深度値を比較します。もし、仮想オブジェクトよりも手前に現実の物体(3Dメッシュ)が存在する場合、その部分の仮想オブジェクトは描画しません。

この処理により、仮想オブジェクトが現実の物体の後ろに正しく隠れる、自然な前後関係が表現されます。SLAMによる詳細な環境マッピングがなければ、このような高度なインタラクションは不可能であり、ARのリアリティを大きく損なうことになります。SLAMは、単にオブジェクトを置くだけでなく、それが現実世界と深く相互作用するための基盤を提供しているのです。

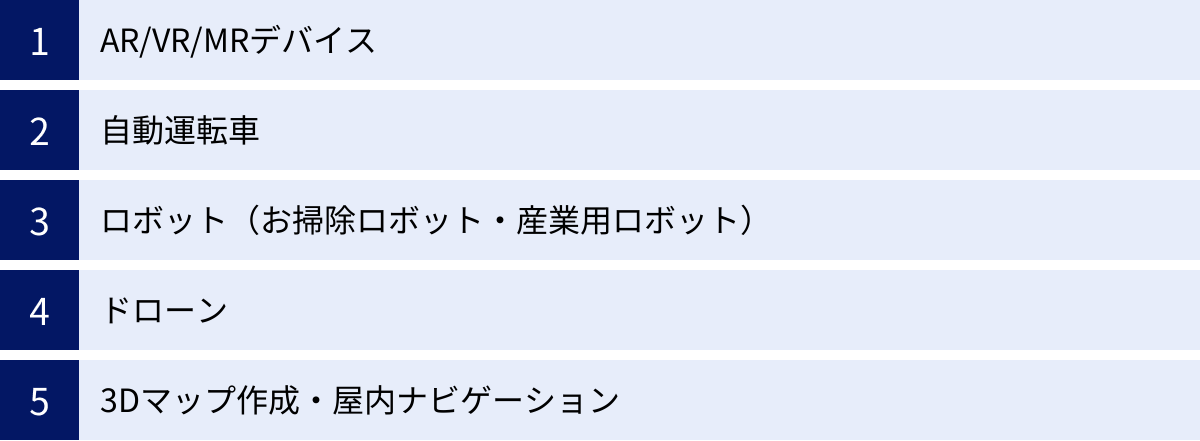

SLAM技術の具体的な活用分野

SLAMはARだけでなく、自律的に移動したり、環境を認識したりする必要がある、あらゆる「動く機械」にとってのコア技術です。その応用範囲は多岐にわたり、すでに私たちの社会の様々な場面で活用が始まっています。ここでは、SLAM技術が活躍する具体的な分野をいくつか紹介します。

AR/VR/MRデバイス

SLAMの活用が最も分かりやすい分野の一つが、AR(拡張現実)、VR(仮想現実)、MR(複合現実)といったXR(クロスリアリティ)技術です。

- スマートフォンAR: 前述の通り、Appleの「ARKit」やGoogleの「ARCore」は、VI-SLAMをベースにしています。これにより、特別なマーカーなしで現実空間を認識し、ゲームキャラクターを出現させたり、購入前に家具を実物大で試し置きしたりするアプリが数多く登場しています。

- ARグラス/MRデバイス: Microsoftの「HoloLens」や「Magic Leap」といったデバイスは、ユーザーが見ている現実世界にデジタル情報を重ね合わせて表示します。これらのデバイスが、ユーザーの頭の動きに合わせて仮想オブジェクトを空間に固定表示できるのは、搭載された複数のカメラとセンサーによる高度なSLAM機能のおかげです。

- VRヘッドセット: 近年のスタンドアロン型VRヘッドセット(例: Meta Questシリーズ)では、「インサイドアウト方式」のトラッキングが主流です。これは、ヘッドセットに搭載されたカメラで外部の環境をSLAM処理し、VR空間内でのユーザーの頭や体の動きをトラッキングする方式です。外部にセンサーを設置する必要がなく、手軽にVR体験を始められるのは、このSLAM技術の進化によるものです。

自動運転車

自動運転の実現において、SLAMは極めて重要な役割を担っています。自動運転車は、常に「自分が地球上のどこにいて、車線内のどの位置にいるか」をセンチメートル単位の精度で把握し続ける必要があります。

- 自己位置推定の冗長化: GPSは基本的な位置情報を提供しますが、トンネル内や高層ビル街では精度が落ちたり、受信できなくなったりします。こうした状況でも安全な走行を続けるため、LiDAR SLAMやVisual SLAMを使って周囲の環境と事前に作成した高精度3Dマップ(HDマップ)を照合し、自己位置を補正・維持します。複数の方法で自己位置を推定することで、システムの冗長性と安全性を高めています。

- HDマップの生成と更新: 自動運転に不可欠なHDマップ自体も、SLAM技術を搭載した計測車両が走行することで作成されます。また、道路工事や新しい建物の出現など、変化し続ける現実世界の状況に合わせてマップを最新の状態に保つためにも、一般車両に搭載されたカメラやLiDARが収集したデータをSLAM処理し、マップの差分を更新していくアプローチが研究されています。

ロボット(お掃除ロボット・産業用ロボット)

SLAM技術は、もともとロボット工学の分野で生まれた技術であり、今では様々なロボットの「知能」を支えています。

- 家庭用お掃除ロボット: 高機能なお掃除ロボットは、レーザーセンサー(LiDAR)やカメラを搭載しており、SLAMを使って家の中をマッピングします。これにより、「どの部屋を掃除したか」「どこに障害物があったか」「充電ステーションはどこか」を記憶し、効率的な清掃ルートを計画したり、前回中断した場所から掃除を再開したりできます。ユーザーはスマートフォンアプリで作成されたマップを確認し、進入禁止エリアを設定することも可能です。

- 産業用ロボット・AGV: 工場や倉庫内で部品や製品を運ぶAGV(無人搬送車)やAMR(自律走行ロボット)は、従来、床に貼られた磁気テープなどのガイドに沿って走行するものが主流でした。しかし、SLAMを搭載したAGV/AMRは、ガイドなしで工場内の環境を認識し、人や障害物を避けながら自律的に目的地まで走行できます。これにより、生産ラインのレイアウト変更にも柔軟に対応でき、導入コストやメンテナンスの手間を大幅に削減できます。

ドローン

ドローンはGPSを利用して屋外を飛行するのが一般的ですが、SLAMを搭載することで、その活動領域を大きく広げることができます。

- 屋内・非GPS環境での飛行: 工場や倉庫内の在庫管理、トンネルや橋梁の下といったインフラ点検、災害発生時の建物内部の状況調査など、GPSの電波が届かない場所での自律飛行が可能になります。ドローンはカメラやLiDARで周囲の環境をマッピングしながら、障害物を回避して安全に飛行ルートを生成します。

- 精密農業(スマート農業): 広大な農地で、作物の生育状況をカメラで撮影しながら飛行する際に、SLAMはGPSを補完してより正確な位置情報を取得し、どの場所で撮影されたデータかを精密にマッピングするのに役立ちます。これにより、特定のエリアにだけ肥料や農薬を散布するといった、きめ細やかな管理が実現します。

3Dマップ作成・屋内ナビゲーション

SLAMは、それ自体が3Dマップを作成する技術であるため、様々な空間のデジタル化に応用されています。

- 建設・土木: 建設現場の現状をSLAM搭載デバイスでスキャンすることで、3Dモデルを素早く作成できます。この3Dモデルを設計図(BIM/CIMデータ)と比較することで、施工の進捗状況を正確に把握したり、設計とのズレを確認したりできます。

- 不動産: 物件の室内をSLAMでスキャンし、バーチャル内覧用の3Dコンテンツを作成するサービスが登場しています。ユーザーはウェブブラウザ上で、実際に室内を歩き回るかのような体験ができます。

- 屋内ナビゲーション: 空港、大規模なショッピングモール、地下街といった複雑な施設内で、利用者を目的地まで案内するナビゲーションシステムにもSLAMが活用され始めています。利用者のスマートフォンがSLAMで現在位置を特定し、ARで進むべき方向を現実の風景に重ねて表示するといった応用が考えられます。これは、GPSが使えない屋内での「Googleマップ」のような体験を提供するものです。

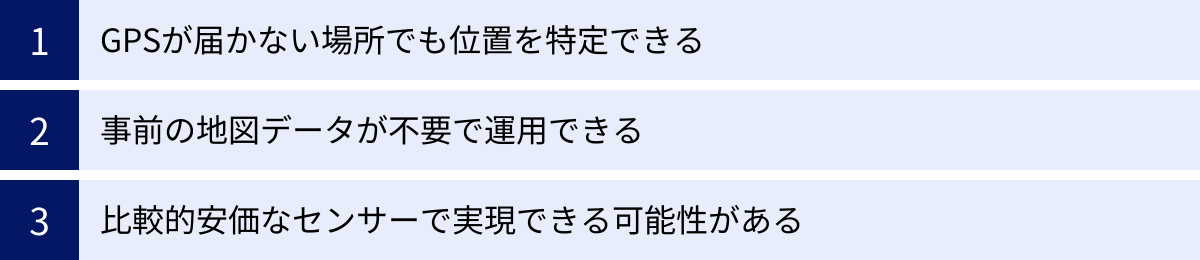

SLAM技術を導入するメリット

SLAM技術は、単に新しい機能を実現するだけでなく、コストや運用面でも多くのメリットをもたらします。なぜ多くの企業や開発者がSLAM技術の導入に注目するのか、その主な利点を3つの観点から解説します。

GPSが届かない場所でも位置を特定できる

これはSLAM技術がもたらす最も根本的かつ最大のメリットです。前述の通り、GPSは人工衛星からの電波に依存するため、屋内、地下、水中、高層ビル群などでは利用に大きな制約があります。これまでは、こうした環境で機械に自律的な移動や正確な位置認識をさせることは非常に困難でした。

SLAM技術は、カメラやLiDARといった自身のセンサーで周囲の環境を直接観測することで自己位置を推定するため、GPS電波の有無に全く依存しません。これにより、これまでテクノロジーの活用が難しかった以下のような領域で、新たなアプリケーションやサービスを生み出すことが可能になります。

- 屋内空間のフル活用: お掃除ロボットや倉庫の自動搬送車はもちろん、商業施設でのAR広告、美術館でのインタラクティブなガイド、オフィスビルでの警備ロボットなど、屋内での活動を高度化するあらゆるソリューションの基盤となります。

- インフラの維持管理: GPSが届きにくい橋梁の下、トンネルの内部、下水道管の中などを、ドローンやロボットが自律的に点検・調査できるようになり、インフラの老朽化対策の効率化と作業員の安全性向上に貢献します。

- 新たな探査領域: 鍾乳洞の3Dマッピングや、水中遺跡の調査など、これまで人間が直接行かなければならなかった危険な場所の探査も、SLAMを搭載したロボットによって代替できる可能性が広がります。

GPSの制約から解放されることで、デジタル技術と物理世界の連携が、屋内外を問わずシームレスに行えるようになる。これがSLAM導入の最もインパクトの大きいメリットです。

事前の地図データが不要で運用できる

従来のナビゲーションシステムの多くは、あらかじめ精密に作成された地図データを必要としました。例えば、初期のAGV(無人搬送車)は、床に貼られた磁気テープの「地図」がなければ動けませんでしたし、自動運転車もHDマップという「地図」がなければ高度な自律走行はできません。

もちろん、SLAMでも事前に地図を用意しておくことで精度を高めるアプローチ(マップベースの自己位置推定)はありますが、SLAMの大きな強みの一つは、地図が全くない未知の環境でも、その場で地図を作成しながら(Mapping)、自己位置を推定(Localization)できる点にあります。

この「オンザフライ(On-the-fly)」な特性は、特に以下のようなシナリオで絶大な効果を発揮します。

- 動的に変化する環境: 人や物が頻繁に移動する倉庫や店舗、レイアウトが日々変わる可能性があるイベント会場など、事前に完璧な地図を用意することが難しい、あるいは意味がない環境でも、SLAM搭載ロボットは柔軟に対応できます。

- 緊急時の対応: 地震や火災などの災害現場は、まさに「未知の環境」です。救助ロボットがそのような場所に投入された際、事前に地図がなくても、SLAMによって現場の状況をリアルタイムでマッピングし、安全なルートを探索しながら要救助者の捜索活動を行えます。

- 導入の手軽さ: 事前に大規模な測量を行って地図を作成する手間やコストが不要なため、システム導入のハードルが下がります。例えば、中小企業の工場や店舗でも、SLAMベースのロボットを比較的容易に導入できます。

このように、事前の準備や環境への作り込みを最小限に抑え、未知の状況にも即座に対応できる運用上の柔軟性は、SLAM技術ならではの大きなメリットです。

比較的安価なセンサーで実現できる可能性がある

SLAMを実現するためのセンサーには、高価なLiDARから安価なカメラまで様々な選択肢がありますが、特にVisual SLAMは、非常に低コストで実現できるポテンシャルを秘めています。

現在、世界中で数十億台が普及しているスマートフォンのほとんどには、カメラと、ある程度の処理能力を持つプロセッサが標準搭載されています。Visual SLAMやVI-SLAM(カメラとIMUを使用)のアルゴリズムは、こうした既存のハードウェア上でソフトウェアとして実装できます。つまり、開発者は新たなハードウェアを追加コストなしで、多くのユーザーがすでに手にしているデバイス上で、高度なSLAM機能を提供できるのです。

この低コスト化がもたらす影響は計り知れません。

- 技術の民主化: かつては研究室レベルの高価な機材でしか実現できなかったSLAMが、一般消費者向けのARアプリやゲームとして手軽に楽しめるようになりました。これにより、SLAM技術の認知度が向上し、新たなアイデアやアプリケーションが生まれる土壌が育まれています。

- コスト競争力の向上: ロボットやドローンなどの製品開発において、高価なセンサーの代わりに安価なカメラを用いることで、製品全体のコストを大幅に抑えることが可能です。これにより、これまで価格がネックとなっていた市場にも参入しやすくなります。

- 広範な応用: カメラは小型・軽量であるため、メガネ型のARデバイスや小型ドローン、さらには衣類に装着するウェアラブルデバイスなど、サイズや重量の制約が厳しい製品にもSLAM機能を組み込む道が開かれます。

もちろん、用途によってはLiDARのような高精度センサーが不可欠な場合もありますが、「安価なカメラでここまでできる」という選択肢があること自体が、SLAM技術の普及と応用範囲の拡大を強力に後押ししているのです。

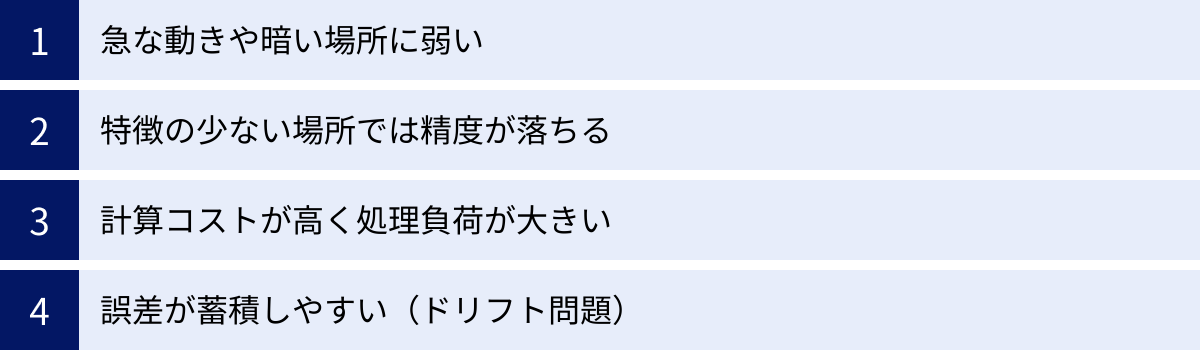

SLAM技術の課題とデメリット

SLAMは非常に強力な技術ですが、万能ではなく、まだ解決すべき課題や苦手な状況が存在します。これらの限界を理解することは、SLAMを適切に応用し、安定したシステムを構築する上で非常に重要です。ここでは、SLAM技術が直面する主な課題とデメリットについて解説します。

急な動きや暗い場所に弱い

この課題は、特にカメラを主要なセンサーとして使用するVisual SLAM(vSLAM)において顕著です。vSLAMは、連続する画像フレーム間で特徴点を追跡することで自己位置を推定しますが、特定の状況下ではこの追跡が困難になります。

- 急な動き(モーションブラー): カメラを非常に速く動かしたり、急に回転させたりすると、撮影される画像がブレてしまいます(モーションブラー)。ブレた画像では、特徴点の輪郭がぼやけてしまい、前のフレームの特徴点との対応付け(マッチング)が失敗しやすくなります。その結果、SLAMシステムは自己位置を見失い、「トラッキングがロストしました」という状態に陥ります。

- 暗い場所(低照度環境): カメラは光を取り込んで映像を生成するため、周囲が暗すぎると、そもそも特徴点として認識できるような模様や角が画像に映らなくなります。真っ暗な部屋では、vSLAMは全く機能しません。照明が不十分な環境でも、ノイズの多い不鮮明な画像しか得られず、精度が大幅に低下します。

これらの問題に対する解決策として、IMU(慣性計測装置)を併用するVI-SLAMが有効です。IMUはカメラのように外界を見るのではなく、自身の加速度や角速度を計測するため、モーションブラーや暗闇の影響を受けません。カメラからの情報が一時的に途絶えても、IMUのデータで短時間の自己位置推定を補間することで、システムの安定性(ロバスト性)を高めることができます。しかし、IMUも完璧ではなく、長時間の補間は誤差の蓄積につながるため、根本的な解決には限界があります。

特徴の少ない場所では精度が落ちる

SLAM、特にvSLAMは、環境内から安定的で識別可能な特徴点を多数見つけ出すことに依存しています。そのため、視覚的な特徴に乏しい環境は、SLAMにとって非常に苦手なシナリオとなります。

- テクスチャレスな環境: 真っ白な壁、磨き上げられた無地の床、曇り空など、模様やテクスチャが全くない、のっぺりとした表面が広がる場所では、特徴点を抽出すること自体が困難です。ランドマークとなる目印が見つからないため、自己位置を特定する手がかりを失ってしまいます。

- 繰り返しパターン: 同じ模様が延々と続く長い廊下や、同じ形の窓が並んでいる壁なども問題を引き起こします。システムが「今見ている特徴点」と「以前に見た特徴点」を正しく区別できず、誤ったマッチングをしてしまう(Perceptual Aliasing)可能性があります。これにより、自己位置が突然ジャンプしたり、ループクロージャが誤作動したりする原因となります。

- 動的な環境: 人混みや、多数の車両が行き交う道路など、背景の大部分が静止しておらず、常に動いている環境もSLAMにとって挑戦的です。SLAMは通常、背景は静的であるという仮定のもとに成り立っているため、動く物体を特徴点として誤認識すると、自己位置推定に大きなエラーが生じます。近年の研究では、AI(深層学習)を用いて動く物体(人、車など)を検出し、SLAMの計算から除外するアプローチも進められています。

計算コストが高く処理負荷が大きい

SLAMは、リアルタイムで非常に多くの計算をこなす、計算集約型(Computationally Intensive)のタスクです。その処理フローには、以下のような負荷の高い計算が連続的に含まれています。

- 特徴点の検出と記述: 画像全体から特徴点を探し出し、その特徴を数値(記述子)に変換します。

- 特徴点のマッチング: 現在のフレームの特徴点と、過去のフレームや地図上の特徴点との対応関係を見つけ出します。

- 位置と姿勢の最適化: 多数の特徴点の観測情報をもとに、最も確からしい自己位置を求めるための、複雑な非線形最適化計算(バンドル調整など)を行います。

- マッピングとループクロージャ: 地図の更新や、ループ検出時の大規模なグラフ最適化も、大きな計算リソースを必要とします。

これらの処理を1秒間に30回や60回といった高いフレームレートで実行し続けるため、特に高精度な地図作成(デンスマッピング)や大規模な環境でのループクロージャを行う場合、CPUやGPUに大きな負荷がかかります。

この高い計算コストは、特にリソースが限られているモバイルデバイスや組み込みシステムにおいて、以下のようなデメリットにつながります。

- バッテリー消費: スマートフォンでARアプリを長時間使用すると、バッテリーが急速に消耗するのは、SLAM処理がプロセッサを常にフル稼働させているためです。

- 発熱: 高負荷な処理はデバイスの発熱を引き起こし、パフォーマンスの低下(サーマルスロットリング)や、ユーザーの不快感につながる可能性があります。

- 他の処理への影響: SLAMが多くのリソースを消費するため、アプリケーション本体のグラフィックス描画や他のロジックに使える計算能力が制限されることがあります。

この課題を解決するため、アルゴリズムの効率化や、計算の一部をクラウドサーバーにオフロードする「クラウドSLAM」といったアプローチが研究されています。

誤差が蓄積しやすい(ドリフト問題)

これはSLAMに内在する最も根源的な課題であり、「ドリフト(Drift)」として知られています。SLAMは、フレーム間のごくわずかな動きをセンサーで計測し、それを積分(足し算)していくことで全体の軌跡を推定します。しかし、どのようなセンサーにも測定誤差は避けられず、また計算過程でも丸め誤差などが生じます。

この微小な誤差が、移動を続けるたびに雪だるま式に積み重なっていき、時間と共に推定位置と真の位置との間に無視できないほどのズレを生じさせる。これがドリフト問題です。

ドリフトは、以下のような形で現れます。

- まっすぐ進んだはずが、推定された軌跡は緩やかにカーブしてしまう。

- 同じ場所を周回して出発点に戻ってきても、地図上では出発点と終点が一致しない。

- 長時間動作させた後、作成された地図全体が歪んでしまう。

このドリフトを抑制するために、前述のループクロージャという仕組みが非常に重要になります。過去に訪れた場所を再認識し、その時点での誤差を検出して地図全体を補正することで、ドリフトを劇的に低減できます。

しかし、ループクロージャが常に機能するとは限りません。一本道をひたすら進むだけで、二度と同じ場所を通らないようなシナリオでは、ループは発生しません。そのような場合、ドリフトは補正されることなく蓄積し続けることになります。したがって、SLAMシステムの設計においては、いかにドリフトの発生を抑えるか(高精度なセンサーやアルゴリズムを用いる)、そしていかに効果的にループクロージャを実行するか、という両面からのアプローチが不可欠です。

SLAM開発に使える主なツール・ライブラリ

SLAM技術をゼロから実装するのは非常に高度な専門知識を要しますが、幸いなことに、開発を支援してくれる優れたツールやライブラリが数多く存在します。これらを活用することで、開発者はSLAMの複雑なアルゴリズムに深く立ち入ることなく、アプリケーションに位置認識機能やAR機能を組み込めます。ここでは、スマートフォン向け、オープンソース、商用の3つのカテゴリに分けて、主要なツールやライブラリを紹介します。

スマートフォン向け開発キット

スマートフォンARアプリケーションの開発において、デファクトスタンダードとなっているのが、AppleとGoogleがそれぞれ提供する開発キットです。これらはOSレベルで深く統合されており、安定した高性能なSLAM機能を手軽に利用できます。

| ツール/ライブラリ名 | 提供元 | ライセンス | 主な特徴 | 対応プラットフォーム |

|---|---|---|---|---|

| ARKit | Apple | 商用利用可(OS付属) | 高い統合性、豊富なAR機能、LiDARスキャナ活用、RealityKitとの連携 | iOS, iPadOS |

| ARCore | 商用利用可(無料提供) | 広範なAndroidデバイス対応、Geospatial API、Cloud Anchors | Android, iOS |

ARKit (Apple)

ARKitは、Appleが提供するiOS/iPadOS向けのARフレームワークです。iPhoneやiPadに搭載されたカメラ、IMU、そして一部のモデルではLiDARスキャナを駆使して、非常に堅牢で高精度なVI-SLAM(LiDAR搭載機ではさらに高精度)を実現します。

主な特徴:

- ワールドトラッキング: デバイスの位置と姿勢を現実空間内でリアルタイムに追跡します。

- 平面検出: 床、壁、テーブルなどの水平・垂直な平面を自動で検出します。

- シーン理解: 人物のオクルージョン(People Occlusion)や、3Dメッシュによる環境のジオメトリ再構築(Scene Geometry)など、高度な環境認識機能を提供します。

- LiDARスキャナの活用: ProモデルのiPhone/iPadでは、LiDARスキャナを用いて、より高速かつ正確な平面検出や、詳細なシーンジオメトリの生成、瞬時のオブジェクト配置が可能です。

- RealityKit/SceneKitとの連携: 3Dコンテンツのレンダリングを容易にするRealityKitやSceneKitとシームレスに連携し、リッチなAR体験を効率的に開発できます。

参照:Apple Developer 公式サイト

ARCore (Google)

ARCoreは、Googleが提供するARプラットフォームで、主にAndroidデバイス向けですが、iOSにも対応しています。多くのメーカーから発売されている多様なAndroidスマートフォンで、統一されたAR体験を提供することを目指しています。

主な特徴:

- モーショントラッキング: ARKitと同様に、VI-SLAMを用いてデバイスの位置と姿勢を追跡します。

- 環境理解: 平面検出に加え、光の強さや色温度を推定する「光推定(Light Estimation)」機能があり、仮想オブジェクトをより自然に現実世界に溶け込ませることができます。

- Cloud Anchors: クラウドを利用して、複数のユーザーが同じAR空間を共有し、同じ場所に仮想オブジェクトを配置・表示できる機能です。クロスプラットフォーム(Android/iOS間)での共有も可能です。

- Geospatial API: GPS情報とvSLAMを組み合わせたGoogleのVPS(Visual Positioning System)技術を活用し、屋外の特定の場所(ランドマークなど)に対して、高精度な位置と向きでARコンテンツを配置できます。

参照:Google for Developers 公式サイト

オープンソースライブラリ

研究者や開発者コミュニティによって開発・公開されているオープンソースのSLAMライブラリも数多く存在します。これらは最新のアルゴリズムを試したり、特定のニーズに合わせてカスタマイズしたりするのに適しています。

ORB-SLAM3

ORB-SLAM3は、学術界で最も広く知られ、ベンチマークとして頻繁に利用されるVisual SLAMライブラリの一つです。単眼、ステレオ、RGB-D、そしてVisual-Inertialのすべてのセンサー構成に対応しており、非常に高い精度とロバスト性を誇ります。特に、短期・中期・長期のデータ関連付けを組み合わせたマップの再利用システムが強力で、一度トラッキングが失われても、すぐに復帰する能力に長けています。商用利用にはライセンスの確認が必要ですが、研究目的や学習用途には最適な選択肢です。

参照:ORB-SLAM3 GitHubリポジトリ

OpenVSLAM

OpenVSLAMは、日本発のオープンソースVisual SLAMフレームワークです。高い拡張性を特徴としており、様々な種類のカメラモデル(魚眼カメラなど)に柔軟に対応できます。また、作成した地図データを保存し、後から再利用して位置推定を行う「ローカライゼーションモード」もサポートしています。ドキュメントやコミュニティも活発で、比較的導入しやすいオープンソースSLAMとして知られています。

参照:OpenVSLAM GitHubリポジトリ

商用SDK

より高度な機能、手厚いサポート、そして商用利用の明確なライセンスを求める場合は、商用のSLAM SDK(Software Development Kit)が選択肢となります。

Kudan SLAM

Kudan SLAMは、日本のKudan社が開発する商用のSLAMソフトウェアです。高速・軽量・高精度を特徴としており、特に組み込みシステムやリソースの限られたデバイスでの性能に定評があります。カメラを用いるVisual SLAMだけでなく、LiDAR SLAMのソリューションも提供しており、低消費電力でありながら高いパフォーマンスを発揮します。自動車、ロボティクス、AR/MRなど、幅広い産業分野での採用実績があります。

参照:Kudan株式会社 公式サイト

Wikitude SLAM

Wikitude SLAMは、Qualcomm社が提供するAR開発プラットフォーム「Wikitude SDK」の中核をなす技術です。長年の実績があり、マーカーベース、マーカーレス(SLAM)、オブジェクト認識など、包括的なAR機能を提供しています。クロスプラットフォーム対応に強く、iOS, Android, Windowsなど、幅広い環境で動作するアプリケーションを開発できます。現在はQualcommのSnapdragon Spaces XR Developer Platformに統合され、XRデバイス向けの開発にも注力しています。

参照:Qualcomm Developer Network (Wikitude)

PTC Vuforia Engine

PTC Vuforia Engineは、AR開発プラットフォームの草分け的存在であり、世界中の多くの開発者に利用されています。その中核技術である「Vuforia Fusion」は、デバイスのセンサー(カメラ、IMUなど)の能力を最大限に引き出し、可能な限り最高のAR体験を提供することを目指したものです。ARKitやARCoreが利用できるデバイスではそれらを活用し、非対応デバイスでも独自のvSLAM技術でトラッキングを行うなど、幅広いデバイスで安定したパフォーマンスを発揮します。画像ターゲット認識やモデルターゲット(3Dオブジェクト認識)など、SLAM以外の機能も非常に強力です。

参照:PTC Vuforia 公式サイト

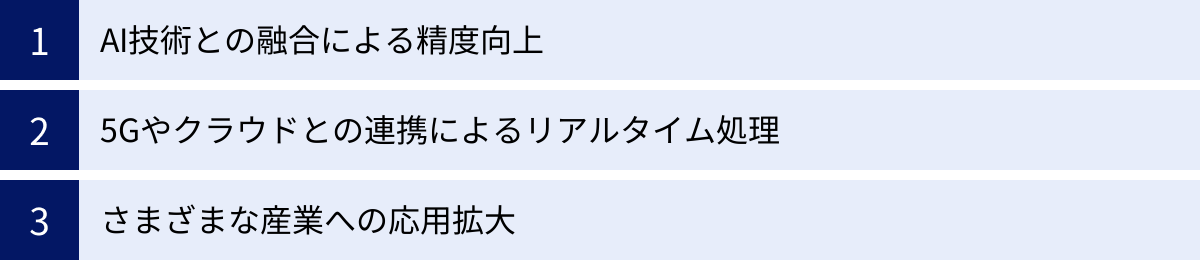

SLAM技術の今後の展望と将来性

SLAM技術はすでに多くの分野で実用化されていますが、その進化はまだ止まっていません。AI、5G、クラウドといった最先端技術との融合により、SLAMは今後さらに高精度化・高機能化し、私たちの社会に、より大きなインパクトを与えていくと予想されます。

AI技術との融合による精度向上

SLAMの性能を飛躍的に向上させる鍵として、AI、特に深層学習(ディープラーニング)との融合が大きな注目を集めています。

- セマンティックSLAM (Semantic SLAM): 従来のSLAMが環境を単なる点や線の集まりとして幾何学的に捉えていたのに対し、セマンティックSLAMは、AIの物体認識技術を組み合わせることで、地図上のオブジェクトが「何であるか」(例:これは椅子、あれは机、向こうはドア)を意味的に理解します。これにより、ロボットは「ドアのところまで行って」といった、より人間らしい抽象的な指示を理解できるようになります。また、「椅子」のような動く可能性のあるオブジェクトと、「壁」のような静的なオブジェクトを区別することで、よりロバストな自己位置推定が可能になります。

- AIによる特徴点抽出・マッチング: 深層学習を用いて、従来のアルゴリズムよりも環境の変化(明るさの変化など)に強い特徴点を学習させたり、より正確なマッチングを行ったりする研究が進んでいます。これにより、これまでSLAMが苦手としてきたテクスチャレスな場所や、照明が大きく変わる環境でも、安定して動作する可能性が高まります。

- シーンの補完: カメラに映っていない部分や、ノイズで欠損した部分を、AIが周囲の状況から推測して補完する技術も研究されています。これにより、より完全で精度の高い3Dマップを生成できるようになります。

AIとの融合は、SLAMを単なる「位置測定器」から、環境を「理解」する「認識エンジン」へと進化させます。

5Gやクラウドとの連携によるリアルタイム処理

SLAMの課題である「高い計算コスト」を解決するアプローチとして、5G(第5世代移動通信システム)とクラウドコンピューティングの連携が期待されています。

- クラウドSLAM / VPS (Visual Positioning System): デバイス側で行っていたSLAMの重い計算処理(地図作成や最適化など)を、5Gの超高速・低遅延な通信を使ってクラウド上の強力なサーバーにオフロードする仕組みです。デバイス側はセンサーデータの送信と、サーバーから送られてくる自己位置情報の受信に専念すればよいため、スマートフォンのようなリソースの限られたデバイスでも、バッテリー消費を抑えながら高精度なSLAMを実行できます。

- ARクラウド (AR Cloud): クラウド上に、現実世界を1対1でマッピングした、永続的で共有可能な3Dマップ(デジタルツイン)を構築する構想です。ユーザーは自分のデバイスをかざすだけで、VPSによって瞬時に高精度な自己位置を特定し、他のユーザーと共有されたAR体験(マルチプレイヤーARゲーム、共有ARノートなど)に参加できます。このARクラウドの実現には、膨大なデータを処理・共有するためのクラウド基盤と、それをリアルタイムに繋ぐ5Gが不可欠です。

5Gとクラウドの力によって、SLAMは個々のデバイス内で完結する技術から、多数のユーザーとデバイスが協調し、巨大なデジタルツインをリアルタイムで構築・利用するためのネットワーク技術へと進化していくでしょう。

さまざまな産業への応用拡大

SLAM技術がより高精度かつ低コストになるにつれて、その応用範囲は今後さらに多様な産業へと拡大していきます。

- 医療: 手術中に、SLAMで内視鏡や手術器具の位置を正確にトラッキングし、事前に撮影したCT/MRI画像と重ねて表示することで、執刀医を支援する「手術ナビゲーションシステム」の精度向上が期待されます。

- 小売・Eコマース: バーチャル試着や家具の試し置きといった既存のAR活用に加え、店舗内での顧客の動線をSLAMで分析し、商品陳列の最適化に役立てたり、ARを活用したインタラクティブな商品棚を作ったりといった応用が進むでしょう。

- エンターテインメント: 施設全体を舞台にした大規模なロケーションベースARゲームや、現実のライブ会場とバーチャルな演出が完全に同期するMRライブなど、現実とデジタルの境界を曖昧にする新たなエンターテインメント体験が生まれます。

- デジタルツインとメタバース: 工場、都市、インフラといった物理的な対象を、センサーデータを用いてそっくりそのままデジタル空間に再現する「デジタルツイン」の構築において、SLAMはリアルタイムに現実世界の形状や変化をデータ化するための必須技術となります。そして、このデジタルツインは、将来的な「メタバース」の基盤となる、現実世界と連動した仮想空間の構築に直結していきます。

SLAMは、物理世界とデジタル情報を繋ぐインターフェースとして、あらゆる産業のDX(デジタルトランスフォーメーション)を加速させる基盤技術としての重要性を増していくことは間違いありません。

まとめ:SLAMは現実世界とデジタルを繋ぐコア技術

本記事では、SLAM(Simultaneous Localization and Mapping)技術について、その基本的な概念から、仕組み、種類、具体的な活用事例、メリットと課題、そして将来の展望までを包括的に解説してきました。

最後に、この記事の要点を振り返ります。

- SLAMの核心: 「自分がどこにいるか(自己位置推定)」と「周りはどうなっているか(地図作成)」を、GPSの助けなしに、センサー情報だけを頼りに同時に行う技術です。

- 基本的な仕組み: 「センサーでの情報取得」→「特徴点の抽出・追跡」→「自己位置の推定」→「地図作成・更新」→「ループクロージャによる誤差修正」という一連のプロセスを高速に繰り返します。

- 主な種類: 使用するセンサーによって、低コストなVisual SLAM、高精度なLiDAR SLAM、両者の長所を組み合わせたVisual-Inertial SLAMなどに分類され、用途に応じて使い分けられます。

- ARにおける重要性: 仮想オブジェクトを現実空間に固定表示する「ワールドトラッキング」や、現実の物体との前後関係を表現する「オクルージョン」を実現するために、SLAMは不可欠です。

- 広範な活用分野: AR/VR/MRだけでなく、自動運転車、お掃除ロボット、ドローン、3Dマップ作成など、自律的に移動・認識する必要があるあらゆる分野で活用が広がっています。

- メリットと課題: 「GPS不要」「事前地図が不要」「低コストで実現可能」といったメリットがある一方で、「急な動きや暗所への弱さ」「高い計算コスト」「誤差の蓄積(ドリフト)」といった課題も存在します。

- 将来性: AIとの融合による意味理解(セマンティックSLAM)や、5G/クラウドとの連携によるARクラウドの実現など、SLAMはさらなる進化の途上にあり、その可能性は広がり続けています。

SLAMは、もはや単なるロボット工学の一分野の技術ではありません。それは、スマートフォンを通じて誰もが日常的にその恩恵に触れ、あらゆる産業のデジタル化を支える基盤技術へと成長しました。

SLAMは、私たちが生きるこの物理的な現実世界と、無限の可能性を秘めたデジタル世界とをシームレスに繋ぐ、まさに架け橋となるコア技術です。この技術の進化を理解することは、未来のテクノロジーと社会がどのように変わっていくかを読み解く上で、非常に重要な鍵となるでしょう。