AR(Augmented Reality:拡張現実)は、現実の世界にデジタルの情報を重ね合わせることで、私たちの視覚体験を拡張する技術です。スマートフォンやタブレットを通して、目の前の風景にキャラクターを登場させたり、部屋にバーチャルな家具を配置したりと、その活用範囲はエンターテインメントからビジネスまで多岐にわたります。

このAR体験を、多くの人が日常的に使用するiPhoneやiPadで実現可能にするのが、Appleが提供する開発フレームワーク「ARKit」です。ARKitの登場により、開発者は特別なハードウェアや深い専門知識がなくとも、高品質で没入感のあるARアプリケーションを開発できるようになりました。

この記事では、ARKitがどのような技術であり、何ができるのかという基本的な知識から、その仕組みを支えるコア技術、開発を始めるための具体的な手順、さらには最新動向や将来性に至るまで、網羅的に解説します。ARKitについて知りたい方、ARアプリ開発に興味がある方は、ぜひ最後までご覧ください。

目次

ARKitとは?Appleが提供するARアプリ開発ツール

ARKitとは、AppleがiOSおよびiPadOS向けに提供している、AR(拡張現実)アプリケーションを開発するためのフレームワークです。フレームワークとは、アプリケーション開発における土台となる機能群や規約をまとめたものであり、開発者はARKitを利用することで、ARアプリの根幹となる複雑な処理を自身で一から実装することなく、効率的に開発を進められます。

ARKitが登場する以前のAR技術は、「マーカー型AR」が主流でした。これは、特定の画像やQRコードのような「マーカー」をカメラで認識し、それを基準にデジタルコンテンツを表示する方式です。この方式は特定の場所で決まった体験を提供するのには有効ですが、マーカーがない場所では機能せず、利用シーンが限定されるという課題がありました。

この課題を解決したのが、ARKitが採用する「マーカーレス型AR」です。マーカーレス型ARは、特定のマーカーを必要としません。代わりに、デバイスのカメラとモーションセンサーを駆使して、現実空間そのものの特徴(床、壁、テーブルなどの平面や、空間の凹凸)をリアルタイムで認識・追跡します。これにより、ユーザーは場所を選ばず、あらゆる現実空間を舞台としてAR体験を楽しめるようになりました。

このマーカーレス型ARを実現している中核技術がSLAM (Simultaneous Localization and Mapping) と呼ばれるものです。SLAMは、「自己位置推定」と「環境地図作成」を同時に行う技術であり、デバイスが「今、自分が空間のどこにいるのか」を把握しながら、「周囲はどのような環境なのか」というマップをリアルタイムで生成し続けます。ARKitはこのSLAM技術を、VIO(後述)という形で高度に実装しており、iPhoneやiPadといった汎用的なデバイス上で、驚くほど安定したAR体験を提供します。

開発者にとってのARKitの最大の魅力は、この高度な空間認識技術を、比較的容易に扱えるAPI(Application Programming Interface)として利用できる点にあります。センサーフュージョンやコンピュータビジョンに関する複雑なアルゴリズムを直接扱う必要はなく、ARKitが提供するシンプルな命令を呼び出すだけで、平面の検出やデバイスの位置追跡といった機能を実現できます。

さらに、ARKitはAppleのハードウェアとソフトウェアに深く統合されています。iPhoneやiPadに搭載されている高性能なCPU、GPU、カメラ、各種センサーの性能を最大限に引き出すように設計されており、常に最適化されたパフォーマンスを発揮します。また、iOS/iPadOSのバージョンアップと共にARKit自体も進化を続け、新しいハードウェア(例えばLiDARスキャナ)の登場に合わせて新機能が追加されるなど、継続的な発展が約束されています。

このように、ARKitは単なる開発ツールではなく、Appleのエコシステム全体でAR体験を普及させるための戦略的な基盤と言えます。開発者はこの強力な基盤の上に、教育、エンターテインメント、ショッピング、医療、製造業など、さまざまな分野で革新的なアプリケーションを創造することが可能です。

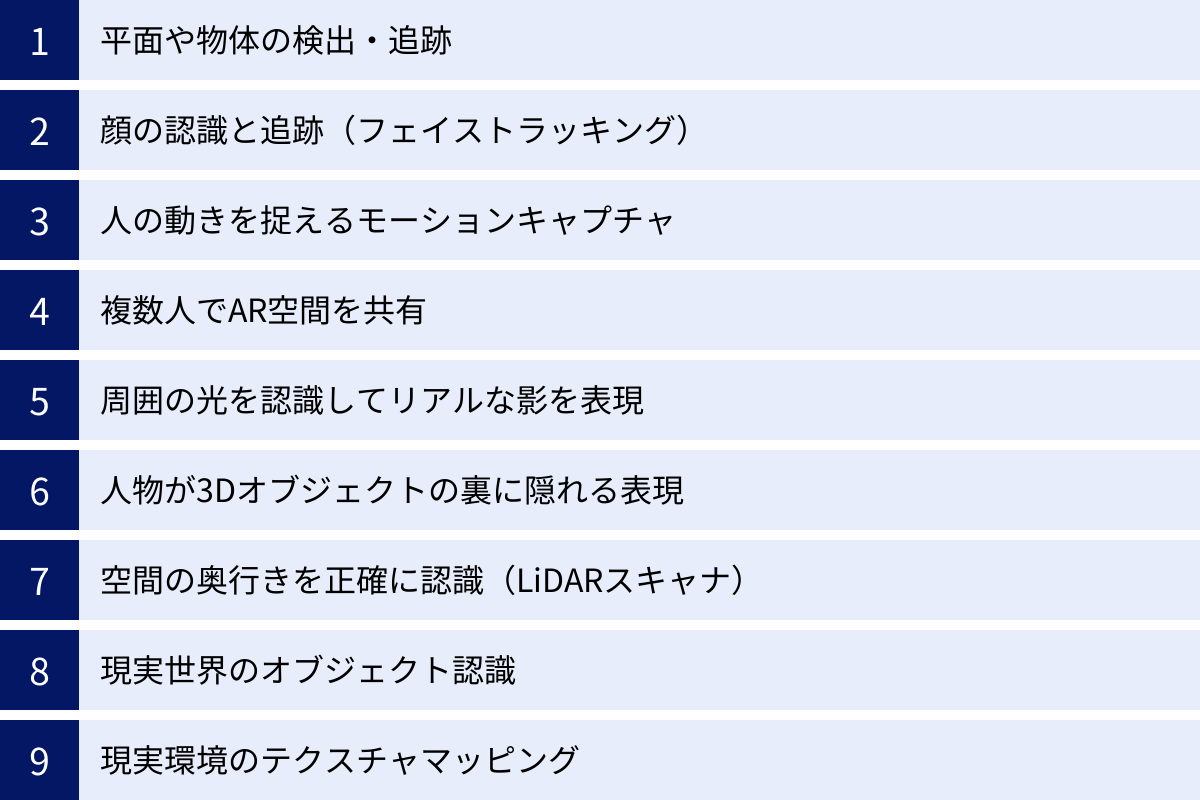

ARKitで実現できる9つの主な機能

ARKitはバージョンアップを重ねるごとに、多彩で強力な機能を実装してきました。ここでは、ARKitで実現できる主な9つの機能について、具体的な応用例を交えながら詳しく解説します。これらの機能を組み合わせることで、非常にリッチで没入感の高いAR体験を構築できます。

① 平面や物体の検出・追跡

ARKitの最も基本的ながら非常に重要な機能が、現実空間の平面や特定の物体を認識し、追跡する能力です。

平面検出(Plane Detection)は、床や地面といった「水平な平面」だけでなく、壁やドアなどの「垂直な平面」も自動で認識します。カメラをかざして周囲を見渡すと、ARKitは空間内の平面をメッシュ(網目状のデータ)として捉え、その位置、大きさ、向きを正確に把握します。この機能は、多くのARアプリの基盤となります。

- 具体例:

- 家具の試し置きアプリ: ユーザーの部屋の床を検出し、その上に実物大のソファやテーブルの3Dモデルを配置する。ユーザーは部屋の中を歩き回り、さまざまな角度から家具のサイズ感やデザインを確認できます。

- ARメジャーアプリ: 検出した平面上の2点間をタップすることで、その間の距離を計測する。

- ARゲーム: 部屋の床やテーブルをゲームのステージとして利用し、キャラクターがその上を走り回ったり、障害物を設置したりする。

物体検出・追跡(Object Detection/Tracking)は、事前にスキャンして登録しておいた特定の3Dオブジェクトを、現実世界で認識し追跡する機能です。例えば、特定の商品、おもちゃ、美術品などをスキャンしておくことで、カメラがその物体を捉えた際に、関連情報を表示したり、アニメーションを再生したりできます。

- 具体例:

- インタラクティブな博物館ガイド: 展示されている彫刻をカメラで認識すると、その彫刻の歴史や作者に関する情報がARで表示される。

- 製品マニュアル: 特定の機械部品を認識させると、その部品の組み立て方やメンテナンス方法がARアニメーションで示される。

これらの機能により、ARコンテンツを現実空間の適切な場所に、安定して固定させることが可能になります。

② 顔の認識と追跡(フェイストラッキング)

iPhone X以降に搭載されているTrueDepthカメラ(前面カメラシステム)を利用することで、ARKitは非常に高精度な顔の認識と追跡(フェイストラッキング)を実現します。

この機能は、顔の形状を立体的に捉えるだけでなく、眉、目、鼻、口、顎など、50以上の特定の筋肉の動きをリアルタイムでトラッキングできます。これにより、ユーザーの表情の変化を驚くほど正確に読み取ることが可能です。

- 具体例:

- アニ文字・ミー文字: ユーザーの表情をリアルタイムで読み取り、動物や自身のアバターの表情に反映させるAppleの標準機能。

- バーチャルメイクアプリ: ユーザーの顔のパーツを正確に認識し、口紅、アイシャドウ、チークなどを仮想的に試すことができる。顔を動かしてもメイクがずれることなく追従します。

- 表情で操作するゲーム: 笑顔になったらポイント獲得、驚いた顔でジャンプするなど、ユーザーの表情をゲームのコントローラーとして利用する。

- バーチャルYouTuber (VTuber) アプリ: 演者の表情をリアルタイムで3Dキャラクターに反映させ、生き生きとした配信を可能にする。

TrueDepthカメラによるフェイストラッキングは、コミュニケーションやエンターテインメントの分野で、新しい表現の可能性を大きく広げています。

③ 人の動きを捉えるモーションキャプチャ

ARKitは顔だけでなく、人体の骨格全体を認識し、その動きをリアルタイムで追跡するモーションキャプチャ機能も備えています。

この機能は、特別なマーカーやスーツを着用することなく、デバイスのカメラだけで人の関節(頭、肩、肘、手首、腰、膝、足首など)の位置を3D空間内で推定します。これにより、人のポーズや動きをデータとして取得し、さまざまな用途に活用できます。

- 具体例:

- フィットネス・トレーニングアプリ: ユーザーのヨガのポーズやスクワットのフォームを認識し、正しいフォームと比較してリアルタイムでフィードバックを提供する。

- ARダンスアプリ: 画面に表示されるお手本のキャラクターと同じ動きをすることでスコアを競うゲーム。

- 簡易的なVTuberシステム: 全身の動きを3Dアバターに反映させ、よりダイナミックな表現を可能にする。

- スポーツ分析: アスリートの動きを撮影し、フォームの改善点などを分析するツールとしての活用も考えられます。

このモーションキャプチャ機能により、ARは単にオブジェクトを配置するだけでなく、人間そのものの動きとインタラクションする、より動的な体験へと進化しています。

④ 複数人でAR空間を共有

ARKitには、複数のユーザーが同じAR空間を同時に体験できる「共有AR体験(Shared AR Experiences)」を構築するための機能があります。

これは、あるデバイスが作成した空間情報(ワールドマップ)を、近くにいる他のデバイスと共有することで実現されます。共有されたデバイスは、自身も周囲をスキャンして空間情報を照合し、全員が同じ座標系を持つ一つのAR空間に参加します。これにより、全員が同じ仮想オブジェクトを、それぞれの視点から見ることが可能になります。

- 具体例:

- マルチプレイヤーARゲーム: 複数のプレイヤーが同じフィールドで、ARのキャラクターと戦ったり、協力してパズルを解いたりする。例えば、AR空間に現れたモンスターを、一人は正面から、もう一人は背後から攻撃するといった連携プレイが可能です。

- 共同デザイン・設計レビュー: 建築家やデザイナーが、ARで表示された建物の3Dモデルを囲み、複数人で同時に確認しながら意見交換を行う。

- 教育現場での活用: 教室で生徒たちが同じARの太陽系モデルを囲み、教師が特定の惑星を指し示しながら説明するなど、インタラクティブな学習体験を提供する。

共有AR体験は、ARを個人的な体験から、他者とのコミュニケーションやコラボレーションを促進するソーシャルな体験へと進化させる重要な機能です。

⑤ 周囲の光を認識してリアルな影を表現

ARコンテンツのリアリティを大きく左右する要素の一つが「光と影」です。ARKitには環境光推定(Light Estimation)という機能が搭載されており、仮想オブジェクトを現実世界に自然に溶け込ませることができます。

この機能は、カメラの映像から現実世界の照明の明るさ(強度)や色(色温度)を分析します。そして、その分析結果を仮想オブジェクトのレンダリング(描画)に反映させます。例えば、暖色系の照明が使われている部屋に仮想オブジェクトを置くと、そのオブジェクトも暖色系の光を浴びているように見えます。また、周囲の明るさに応じて、オブジェクトが落とす影の濃さも自動で調整されます。

- 具体例:

- リアリティの向上: 晴れた屋外に置いた仮想の車は、強い日光を反射してキラキラと輝き、濃い影を地面に落とします。一方、曇りの日の室内では、全体的に柔らかい光が当たり、影もぼんやりとします。このような表現により、仮想オブジェクトがあたかも本当にその場に存在するかのような錯覚を生み出します。

この光と影のリアルな表現は、ユーザーの没入感を深める上で欠かせない要素であり、ARKitの大きな強みの一つです。

⑥ 人物が3Dオブジェクトの裏に隠れる表現(ピープルオクルージョン)

ピープルオクルージョン(People Occlusion)は、AR体験の没入感を劇的に向上させる画期的な機能です。オクルージョンとは「遮蔽(しゃへい)」を意味し、この機能は現実世界の「人」と仮想の「3Dオブジェクト」の前後関係を正しく認識し、描画します。

通常、ARオブジェクトはカメラ映像の最前面に表示されるため、人がオブジェクトの前を横切っても、人がオブジェクトに隠れてしまう不自然な表示になりがちでした。しかし、ピープルオクルージョンを有効にすると、ARKitはリアルタイムで映像内の人物をセグメンテーション(領域分割)し、その深度情報(カメラからの距離)を把握します。

これにより、仮想オブジェクトより手前に人がいれば人を手前に、奥にいれば人を奥に(つまり、人がオブジェクトの裏に隠れるように)描画することができます。

- 具体例:

- ARキャラクターとの共演: 部屋に現れたARのキャラクターの後ろに回り込んだり、かくれんぼをしたりすることができる。キャラクターが本当にその空間に「存在」しているかのような感覚が得られます。

- AR家具配置: 部屋に配置した仮想のソファの前を家族が歩くと、ソファがその人の後ろに正しく隠れるため、より自然なサイズ感や配置の確認ができます。

この機能は、A12 Bionicチップ以降を搭載したデバイスで利用可能であり、仮想と現実の境界線を曖昧にする、非常に強力な表現を可能にします。

⑦ 空間の奥行きを正確に認識(LiDARスキャナ)

一部のハイエンドなiPhone ProやiPad Proモデルには、LiDAR(Light Detection and Ranging)スキャナが搭載されています。LiDARは、レーザー光を対象物に照射し、その光が跳ね返ってくるまでの時間を計測することで、対象物までの距離を極めて正確に測定する技術です。

ARKitは、このLiDARスキャナを活用することで、空間認識能力を飛躍的に向上させます。

- 高速かつ正確な平面検出: カメラ映像だけに頼る場合に比べ、瞬時に部屋の床、壁、天井、家具などの表面形状を詳細なメッシュデータとして取得できます。暗い場所でも正確に認識可能です。

- インスタントなAR配置: アプリを起動してすぐに、周囲をスキャンする動作なしでARオブジェクトを正確に配置できます。

- よりリアルなオクルージョン: 人だけでなく、テーブルや椅子といった現実のあらゆる物体とARオブジェクトの前後関係を正確に描画できます。仮想のボールを投げると、現実の椅子の後ろに転がっていくといった表現が可能です。

- RoomPlan API: LiDARを使って部屋全体をスキャンし、壁、窓、ドア、家具などを含むパラメトリックな3Dモデルを自動生成する強力なAPI(後述)も利用できます。

LiDARスキャナは、ARKitの能力を最大限に引き出し、プロフェッショナルな用途にも耐えうる高次元のAR体験を実現するための鍵となります。

⑧ 現実世界のオブジェクト認識

ARKitは、平面や登録済みの特定の物体だけでなく、機械学習モデルを利用して、より一般的なカテゴリのオブジェクトを認識することも可能です。これは「オブジェクト認識(Object Recognition)」と呼ばれます。

例えば、「椅子」「テーブル」「ランプ」といったカテゴリのオブジェクトを認識するようトレーニングされたモデルをアプリに組み込むことで、ARKitはカメラに映ったものがどのカテゴリに属するかを識別できます。

- 具体例:

- スマートホームアプリ: 部屋にある照明器具を認識し、タップすることでその照明をオン/オフするARインターフェース。

- 教育アプリ: カメラに映ったさまざまな物を認識し、その名前を多言語で表示する。

- コンテキストに応じた情報表示: レストランでテーブルを認識すると、その上にARのメニューを表示するなど、状況に応じたインタラクションを可能にする。

この機能は、ARを単なる視覚効果から、現実世界とより深く結びついた「コンテキストアウェア(文脈を理解する)」な技術へと進化させます。

⑨ 現実環境のテクスチャマッピング

ARKit 4から導入されたScene Geometry APIは、LiDARスキャナと連携して、空間の物理的な形状(ジオメトリ)を詳細な3Dメッシュとして取得する機能を提供します。これに加えて、ARKitは取得したメッシュの各表面に、現実世界の見た目、つまりテクスチャをマッピングすることも可能です。

これにより、開発者は床の木目、壁の模様、家具の布地の質感といった、現実環境の視覚情報をデータとして取得できます。このテクスチャ情報を利用することで、仮想オブジェクトの表現をさらにリッチにすることができます。

- 具体例:

- リアルな反射・屈折表現: 仮想の金属球を床に置いたとき、その表面に床の木目が映り込むといった、リアルな反射を表現する。

- 環境に合わせたエフェクト: 現実の壁の色に合わせて、仮想の照明の色を変えたり、壁に仮想のペンキを塗るシミュレーションを行ったりする。

- 物理ベースレンダリング(PBR)の向上: 現実のライティング情報と表面テクスチャを組み合わせることで、仮想オブジェクトの質感を極めてフォトリアルに描画する。

この機能は、特にリアリティが求められる建築ビジュアライゼーションや製品デザインの分野で、その真価を発揮します。

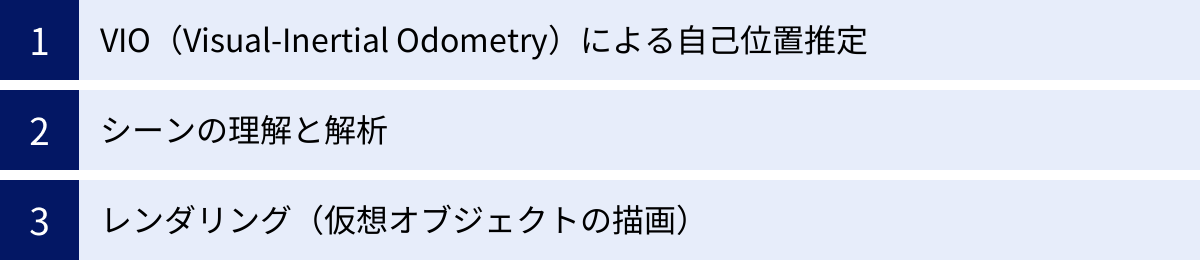

ARKitを支える3つのコア技術

ARKitが提供する多彩な機能は、いくつかの洗練されたコア技術の組み合わせによって実現されています。ここでは、その中でも特に重要な3つの技術、「VIO」「シーンの理解と解析」「レンダリング」について、その仕組みを掘り下げて解説します。これらの技術を理解することで、ARKitがなぜ高精度なAR体験を提供できるのかがより明確になります。

① VIO(Visual-Inertial Odometry)による自己位置推定

ARKitの根幹をなす最も重要な技術がVIO (Visual-Inertial Odometry) です。これは、デバイスが現実空間の中で自身の位置と向きをリアルタイムで、かつ高精度に追跡するための技術であり、「マーカーレスAR」の心臓部と言えます。

VIOは、その名の通り「Visual(視覚情報)」と「Inertial(慣性情報)」という2種類の異なるセンサーからの情報を融合(センサーフュージョン)させることで機能します。

- Visual(視覚情報): デバイスのカメラから入力される映像データです。ARKitは、映像の中から「特徴点(Feature Point)」と呼ばれる、際立った見た目の点(例えば、物の角や模様の交点など)を多数検出します。そして、連続する映像フレーム間でこれらの特徴点がどのように移動したかを追跡します。この動きを分析することで、カメラ(つまりデバイス)がどのように移動し、回転したかを推定できます。これは、私たちが電車に乗っているときに、窓の外の景色が流れるのを見て自分の移動を感じるのと似た原理です。しかし、カメラ映像だけでは、動きが速すぎると映像がブレて特徴点の追跡に失敗したり、特徴点の少ない真っ白な壁のような場所では移動を検知できなかったりする弱点があります。

- Inertial(慣性情報): iPhoneやiPadに内蔵されているIMU(Inertial Measurement Unit:慣性計測装置)から得られるデータです。IMUは主に以下の2つのセンサーで構成されています。

- 加速度センサー: デバイスの直線的な動き(加速度)を検出します。

- ジャイロスコープ: デバイスの回転(角速度)を検出します。

IMUは、1秒間に数百回から数千回という非常に高い頻度でデータを更新できるため、カメラが捉えきれないような素早い動きにも追従できます。しかし、IMUは時間経過とともにわずかな誤差が蓄積していき、徐々に実際の位置からズレてしまう「ドリフト」という問題を起こしやすい性質があります。

VIOは、これら2つのセンサーの長所を組み合わせ、短所を補い合うことで、高精度な自己位置推定を実現します。具体的には、更新頻度は低いが絶対的な位置関係の把握に強いカメラ映像を基準とし、IMUの高頻度なデータでその間の動きを細かく補間し続けます。また、カメラ映像から得られる情報を使って、IMUの蓄積誤差を定期的にリセット・補正します。

このVIOによる継続的な自己位置推定と、前述のSLAM技術による環境地図作成が組み合わさることで、ARKitは「デバイスが今どこにいて、どちらを向いているか」という情報を、数ミリ単位の精度で把握し続けることができるのです。これが、ARオブジェクトが空間にピタッと固定され、回り込んでもズレない安定したAR体験の基盤となっています。

② シーンの理解と解析

VIOによってデバイスの自己位置が正確に把握できても、それだけでは意味のあるAR体験は作れません。次に重要になるのが、デバイスの周囲にある現実世界の環境(シーン)がどのような構造になっているかを理解し、解析する技術です。ARKitは、カメラ映像やLiDARスキャナからの情報を用いて、リアルタイムにシーンを解析します。

このシーン解析には、これまで説明してきた多くの機能が含まれます。

- 平面検出: VIOによって追跡されている特徴点の中から、同一平面上にあると推定される点の集合を見つけ出し、それらを床、壁、テーブルといった「平面」として認識します。これにより、ARオブジェクトを置くための「地面」が生まれます。

- 境界の推定: 検出した平面の境界線(エッジ)を推定し、より正確な形状を把握します。

- 光源の推定: カメラ映像全体の明るさや色合いを分析し、現実空間の照明環境(方向、強度、色温度)をモデル化します。これは、仮想オブジェクトをリアルに照らすために使われます。

- シーンジオメトリ(LiDAR利用時): LiDARスキャナを搭載したデバイスでは、光を使って周囲の物体までの距離を直接計測します。これにより、平面だけでなく、椅子やソファの曲面、壁の凹凸といった、より複雑で詳細な3Dジオメトリ(形状情報)をメッシュとして再構築できます。この詳細なマップがあることで、物理シミュレーション(ボールが坂を転がるなど)や、よりリアルなオクルージョン(物体とARオブジェクトの遮蔽)が可能になります。

- 人物のセグメンテーション: 機械学習モデルを用いて、カメラ映像の中から人物の領域を特定し、背景から分離します。これがピープルオクルージョンの基礎技術となります。

これらの解析結果を総合することで、ARKitは単なる点の集まりだった現実空間を、意味のある構造(床、壁、物体、人、光)を持つデジタルツイン(デジタルの双子)として内部に構築します。開発者は、このデジタル化されたシーン情報にアクセスし、ARコンテンツを適切に配置したり、現実環境とインタラクションさせたりすることができます。

③ レンダリング(仮想オブジェクトの描画)

VIOによる自己位置推定と、シーン解析による環境理解が完了したら、最後のステップとして、仮想の3Dオブジェクト(キャラクター、家具など)をそのシーンの中に描画(レンダリング)します。このレンダリングの品質が、AR体験の最終的なリアリティを決定づけます。

ARKit自身は直接的なレンダリングエンジンではありませんが、Appleが提供する高性能なグラフィックスフレームワークと密接に連携し、レンダリングに必要な情報を提供します。

- RealityKit: ARKit 3と共に登場した、ARコンテンツのレンダリングに特化した高レベルなフレームワークです。フォトリアルなレンダリングを比較的容易に実現できるように設計されています。RealityKitは、ARKitから受け取ったシーン解析情報(特に光源推定や環境テクスチャ)を自動で活用し、物理ベースレンダリング(PBR)と呼ばれる手法で、非常にリアルな見た目のオブジェクトを描画します。例えば、現実の照明環境に合わせてオブジェクトの表面の光沢や影を自動調整したり、ピープルオクルージョンを有効にしたりといった処理を、数行のコードで実装できます。初心者からプロまで、高品質なARアプリを効率的に開発する上で強力な選択肢となります。

- SceneKit: 3Dグラフィックス全般を扱うためのフレームワークで、ARKit登場以前から存在します。RealityKitよりも低レベルな操作が可能で、より細かいカスタマイズを行いたい場合に適しています。ARKitと組み合わせて、ARシーンのレンダリングにも使用できます。

- Metal: Appleプラットフォームにおける最も低レベルなグラフィックスAPIです。GPUの性能を最大限に引き出し、独自のレンダリングエンジンを構築する場合などに使用されます。最高のパフォーマンスと完全な制御を求める上級者向けの選択肢です。

ARKitは、これらのレンダリングエンジンに対して、「カメラの位置と画角」「仮想オブジェクトを配置すべき座標」「シーンの光源情報」「影を落とすための平面情報」といった、描画に必要なすべてのパラメータをフレームごとに提供します。レンダリングエンジンはこれらの情報を受け取り、最終的な映像(現実のカメラ映像+仮想オブジェクト)を合成して画面に表示します。この一連のプロセスが1秒間に30回または60回という高速で繰り返されることで、滑らかでリアルなAR体験が生まれるのです。

ARKitを利用するメリット

ARアプリケーションの開発プラットフォームは複数存在しますが、その中でARKitを選ぶことには、開発者にとって多くのメリットがあります。ここでは、ARKitが持つ主な3つの利点を詳しく解説します。

高精度なトラッキング性能

ARKitを利用する最大のメリットの一つは、その卓越したトラッキング性能にあります。AR体験の質は、仮想オブジェクトがどれだけ現実空間に安定して固定されるかに大きく依存します。オブジェクトが頻繁にズレたり、振動したりすると、ユーザーの没入感は著しく損なわれます。

ARKitは、前述のコア技術であるVIO(Visual-Inertial Odometry)によって、非常に堅牢で安定したワールドトラッキングを実現しています。カメラの映像(Visual)とIMUの慣性情報(Inertial)を高度に統合するセンサーフュージョン技術は、Appleが長年にわたり培ってきたハードウェアとソフトウェアの知見の結晶です。これにより、特別なマーカーや外部センサーを一切必要とせずに、iPhoneやiPad単体で、ユーザーが歩き回ったり、デバイスを素早く動かしたりしても、ARオブジェクトの位置がズレにくいという優れたパフォーマンスを発揮します。

特に、LiDARスキャナを搭載したモデルでは、そのトラッキング精度と速度がさらに向上します。LiDARは空間の奥行き情報を瞬時に、かつ正確に捉えることができるため、ARKitはより詳細な3Dマップを迅速に構築できます。これにより、以下のような恩恵がもたらされます。

- AR体験の即時開始: アプリを起動後、カメラを左右に振って平面を認識させるという「初期化」のステップがほぼ不要になり、すぐにARオブジェクトを配置できます。

- 暗所での安定性: カメラ映像に頼る割合が減るため、照明が不十分な暗い環境でも安定したトラッキングを維持しやすくなります。

- 高度なオクルージョン: 人だけでなく、現実のあらゆる物体とARオブジェクトの前後関係を正確に処理できるため、リアリティが格段に向上します。

このように、標準的なデバイスでも高水準のトラッキングを提供し、ハイエンドデバイスではさらにその能力を拡張できるという点は、開発者が質の高いARアプリを構築する上で非常に大きなアドバンテージとなります。

豊富な公式ドキュメント

新しい技術を学ぶ上で、学習リソースの質と量は極めて重要です。その点で、ARKitはAppleによる公式ドキュメントやサンプルコードが非常に充実しており、開発者が学習を始めやすい環境が整っています。

AppleのDeveloperサイトには、ARKitの各機能に関する詳細なAPIリファレンスやプログラミングガイドが網羅的に用意されています。これらのドキュメントは、各クラスやメソッドの役割が明確に説明されているだけでなく、具体的な使い方を示すコードスニペットも豊富に含まれています。

- APIリファレンス: ARKitフレームワークに含まれる全てのクラス、プロトコル、関数について、その目的、パラメータ、戻り値などが詳細に解説されています。

- プログラミングガイド: 平面検出、画像追跡、フェイストラッキングといった主要な機能を実装するためのステップバイステップのガイドが提供されています。

- サンプルプロジェクト: Appleは、ARKitのさまざまな機能を実装したサンプルコードのプロジェクトを多数公開しています。これらのプロジェクトをダウンロードしてXcodeで実行し、コードを実際に動かしながら学ぶことは、理論を実践に結びつける上で非常に効果的です。単純なオブジェクト配置から、共有AR、ピープルオクルージョンといった高度な機能まで、幅広いサンプルが揃っています。

さらに、Appleが毎年開催する開発者向けカンファレンス「WWDC (Worldwide Developers Conference)」では、ARKitに関する数多くのセッション動画が公開されます。これらの動画では、新機能の紹介はもちろん、ベストプラクティス、パフォーマンス最適化のテクニック、開発のヒントなどが、実際にARKitを開発しているAppleのエンジニア自身によって詳しく解説されます。過去のセッション動画も全て無料で視聴可能であり、これらは非常に価値の高い学習資料となります。

このように、公式から提供される信頼性の高い情報源が豊富にあるため、開発者は問題に直面した際に解決策を見つけやすく、効率的にスキルを習得していくことができます。

Apple製品に最適化されている

ARKitはAppleが自社のプラットフォームのために開発したフレームワークであるため、iPhoneやiPadといったApple製品のハードウェアとソフトウェアに深く最適化されています。この垂直統合モデルは、パフォーマンスと安定性の面で大きなメリットをもたらします。

- ハードウェアの性能を最大限に活用: ARKitは、AシリーズやMシリーズといったAppleシリコンのCPU、GPU、そしてNeural Engineのアーキテクチャを熟知した上で設計されています。これにより、複雑なコンピュータビジョン処理やレンダリングを、デバイスの能力を最大限に引き出しながら、電力効率良く実行できます。カメラセンサーの特性やIMUの応答速度なども考慮されており、ハードウェアとソフトウェアが一体となって最高のパフォーマンスを発揮します。

- OSレベルでの統合: ARKitはiOS/iPadOSに深く統合されており、OSのアップデートと共にARKit自体も進化します。新しいOSバージョンで導入される最新のグラフィックス技術(Metalのアップデートなど)や機械学習フレームワーク(Core ML)の恩恵をいち早く受けることができます。これにより、開発者は常に最先端の技術を活用したARアプリを開発できます。

- 一貫した開発体験: 開発はAppleの公式統合開発環境(IDE)であるXcodeで行います。Xcodeは、コーディング、デバッグ、パフォーマンス分析、実機への転送といった開発プロセス全体をシームレスにサポートします。特にAR開発においては、CPUやGPUの使用率、メモリ消費量などをリアルタイムでモニタリングするプロファイリングツールが強力であり、アプリケーションのパフォーマンスチューニングに役立ちます。

このAppleエコシステム内での緊密な連携は、開発者に安定した開発環境と、ユーザーに滑らかで高品質なAR体験を提供するための強固な基盤となります。

ARKitを利用する際の注意点

ARKitは非常に強力な開発フレームワークですが、万能ではありません。採用を検討する際には、その制約やデメリットもしっかりと理解しておく必要があります。ここでは、ARKitを利用する上で特に注意すべき2つの点について解説します。

対応デバイスがApple製品に限定される

ARKitを利用する上での最大の注意点であり、最も根本的な制約は、その動作環境がiPhoneやiPadといったApple製品に限定されることです。ARKitはiOSおよびiPadOS専用のフレームワークであるため、Androidスマートフォンやタブレット、あるいはWindows PCなど、他のプラットフォームでは動作しません。

この制約は、開発するアプリケーションのターゲットユーザー層やビジネス戦略に大きな影響を与えます。

- 市場リーチの制限: アプリケーションをARKitのみで開発した場合、その恩恵を受けられるのはAppleユーザーに限られます。世界のスマートフォン市場ではAndroidが大きなシェアを占めており(地域によってシェアは異なります)、Androidユーザーを完全に切り捨てることになります。もし、できるだけ多くのユーザーにアプリを届けたいのであれば、ARKitのみでの開発は最適な選択とは言えない可能性があります。

- プラットフォームごとの開発コスト: Androidユーザーにもリーチするためには、Googleが提供するARフレームワーク「ARCore」を使ったAndroid版のアプリを別途開発する必要があります。これは、iOS版とAndroid版で、それぞれ異なる言語(Swift/Objective-CとJava/Kotlin)、異なる開発環境(XcodeとAndroid Studio)、異なるAPIセットを使って開発することを意味し、開発工数、期間、コストが単純に2倍近くかかってしまう可能性があります。

- クロスプラットフォーム開発の検討: この問題を解決するための一つのアプローチが、UnityやUnreal Engineといったゲームエンジンと、それに対応するAR開発用プラグイン(例えばUnityのAR Foundation)を利用する「クロスプラットフォーム開発」です。これにより、一つのコードベースからiOS(ARKit)とAndroid(ARCore)の両方に対応したアプリをビルドできます。しかし、このアプローチにも、ネイティブ開発に比べて若干のパフォーマンスオーバーヘッドがあったり、各プラットフォームの最新機能への対応が遅れたりする可能性があるといったトレードオフが存在します。

したがって、ARアプリの企画段階で、ターゲットとする顧客層は誰なのか、どのプラットフォームを優先すべきなのか、開発リソースはどの程度確保できるのか、といった点を慎重に検討し、ARKitのみで進めるのか、ARCoreとの併用やクロスプラットフォーム開発を選択するのかを決定する必要があります。

開発には専門的な知識が必要

ARKitは、AR開発の敷居を大幅に下げたとはいえ、高品質なアプリケーションを開発するためには、依然として専門的な知識とスキルが求められます。特に、プログラミング初心者や、これまで2DのUI開発しか経験してこなかった開発者にとっては、学習すべき領域が広範にわたる可能性があります。

- 3Dグラフィックスの基礎知識: ARは本質的に3D空間を扱う技術です。したがって、座標系(ワールド座標、ローカル座標)、ベクトル、行列(マトリクス)といった3D数学の基本的な概念の理解は不可欠です。また、3Dモデルのデータ形式(USDZ, glTFなど)、テクスチャ、マテリアル、ライティング、シェーダーといった3D CGに関する知識もある程度必要になります。これらの知識がないと、オブジェクトを意図した通りに配置したり、リアルな見た目を表現したりすることが難しくなります。

- プログラミング言語とフレームワークの習熟: ARKitをネイティブで開発する場合、Appleプラットフォームの標準言語であるSwiftまたはObjective-Cに習熟している必要があります。また、ARKitだけでなく、UIを構築するためのSwiftUIやUIKit、3DコンテンツをレンダリングするためのRealityKitやSceneKitといった、関連するフレームワークについての知識も求められます。これらは相互に連携して動作するため、それぞれの役割と使い方を理解する必要があります。

- 空間コンピューティング特有のUI/UX: ARアプリのユーザーインターフェース(UI)やユーザー体験(UX)は、従来の2D画面のアプリとは大きく異なります。ユーザーはスマートフォンをかざして物理空間を動き回りながらアプリを操作します。そのため、3D空間内での直感的なオブジェクトの操作方法、ユーザーを安全に誘導するためのガイダンス、デバイスの動きや環境の変化に対応するロバストな設計など、ARならではのUI/UXデザインの原則を考慮する必要があります。例えば、「オブジェクトをどこに配置できるか」を視覚的に示したり、「もっと周りを見渡してください」といった指示を出したりする工夫が求められます。

- パフォーマンスの最適化: ARアプリは、カメラのリアルタイム処理、センサーデータの解析、3Dレンダリングといった負荷の高い処理を同時に行います。そのため、何も考えずに実装すると、すぐにデバイスが熱を持ったり、バッテリーを著しく消耗したり、フレームレートが低下してカクカクした動きになったりします。メモリ管理、CPU・GPU負荷の分散、3Dモデルのポリゴン数やテクスチャサイズの最適化など、パフォーマンスを常に意識した開発が重要になります。

これらの学習曲線は決して緩やかではないため、本格的なARアプリ開発に着手する際には、十分な学習期間と試行錯誤の時間を確保することが賢明です。

ARKitとGoogleのARCoreの違いを比較

ARKitがAppleのARプラットフォームであるのに対し、GoogleはAndroid向けに「ARCore」というAR開発プラットフォームを提供しています。この二つは、モバイルARにおける二大巨頭であり、どちらを選択するかは開発プロジェクトの成否を左右する重要な決定です。ここでは、ARKitとARCoreの主な違いを「対応OS」「開発環境・言語」「機能面」の3つの観点から比較します。

| 比較項目 | Apple ARKit | Google ARCore |

|---|---|---|

| 対応OS | iOS, iPadOS | Android, iOS |

| 主な開発環境 | Xcode | Android Studio |

| 主な開発言語 | Swift, Objective-C | Java, Kotlin |

| クロスプラットフォーム | Unity, Unreal Engine, React Native, etc. | Unity, Unreal Engine, React Native, etc. |

| LiDARスキャナ対応 | 対応 (iPhone Pro/iPad Proの一部モデル) | 対応 (一部のハイエンドAndroidデバイス) |

| フェイストラッキング | TrueDepthカメラによる高精度なトラッキング | Augmented Faces API (前面カメラ、TrueDepthほどの精度はない) |

| クラウド連携 | Shared AR Experiences (P2Pでの空間共有) | Cloud Anchors (クラウド経由での空間共有/永続化) |

| 地理空間連携 | なし (サードパーティ製ライブラリで対応) | Geospatial API (Google Mapsと連携した屋外AR) |

対応OS

最も根本的かつ重要な違いは、対応するオペレーティングシステム(OS)です。

- ARKit: Appleが開発しているため、iOSおよびiPadOSでのみ動作します。Androidデバイスでは利用できません。

- ARCore: Googleが開発しており、主に対応するのはAndroidデバイスです。しかし、ARCoreはiOSにも対応しており、ARKitのラッパーとして機能することで、ARCoreのAPIを使ってiOS向けのARアプリを開発することも可能です。ただし、iOS上でARCoreを使う場合、内部的にはARKitの機能が呼び出されるため、ARKit独自の高度な機能(LiDAR連携など)を最大限に活用することは難しい場合があります。

この違いにより、ターゲットとする市場が大きく変わります。Appleのエコシステムに特化した高品質な体験を提供したい場合はARKitが、幅広いAndroidユーザーにリーチしたい場合はARCoreが第一の選択肢となります。

開発環境・言語

ネイティブアプリとして開発する場合、使用する開発環境とプログラミング言語が異なります。

- ARKit: 開発はMac上のXcodeという統合開発環境で行い、言語は主にSwift(またはObjective-C)を使用します。Appleプラットフォームでの開発経験があるエンジニアにとっては馴染み深い環境です。

- ARCore: Androidアプリとして開発する場合、開発環境はAndroid Studioを使い、言語はJavaまたはKotlinを使用します。

一方で、前述の通りUnityやUnreal Engineのようなゲームエンジンを使用すれば、この違いを吸収できます。UnityのAR Foundationのようなミドルウェアは、ARKitとARCoreの両方の機能を抽象化した共通のAPIを提供します。これにより、開発者は一度コーディングすれば、iOSとAndroidの両方のプラットフォーム向けにアプリをビルドできます。これは開発効率を大幅に向上させますが、プラットフォーム固有の最新機能への対応が遅れる可能性があるというトレードオフも存在します。

機能面

ARKitとARCoreは、基本的なAR機能(モーショントラッキング、平面検出、環境光推定)においては、非常に似たレベルの性能を提供します。しかし、それぞれの出自やエコシステムの違いを反映した、特徴的な機能も存在します。

- ハードウェア依存の機能:

- LiDARスキャナ: ARKitは、iPhone Pro/iPad Proに搭載されたLiDARスキャナを積極的に活用し、高速で正確なシーン認識やリアルなオクルージョンを実現します。ARCoreも一部のAndroidデバイスでDepth APIを介して同様の深度センサー(ToFセンサーなど)を利用できますが、ハードウェアとソフトウェアの統合度ではARKitに分があります。

- フェイストラッキング: ARKitはTrueDepthカメラを利用した非常に高精度な3Dフェイストラッキングを提供します。一方、ARCoreのAugmented Faces APIは、一般的な前面カメラで動作するため対応機種は多いですが、メッシュの精度や追従性ではTrueDepthカメラを利用するARKitに及びません。

- クラウド・地理空間連携機能:

- 空間共有(アンカー共有): ARKitのShared AR Experiencesは、主にP2P(Peer-to-Peer)通信を利用して、近くにいるデバイス間でリアルタイムに空間情報を共有するのに適しています。一方、ARCoreのCloud Anchorsは、空間情報(アンカー)をGoogleのクラウドに保存できます。これにより、異なる時間や場所で同じAR体験を共有したり、ARコンテンツを特定の場所に永続的に配置したりすることが可能です。

- 地理空間AR: ARCoreの大きな強みの一つがGeospatial APIです。これはGoogle MapsのVisual Positioning System (VPS) とストリートビューの膨大な画像データを活用し、GPSが苦手な都市部などでも、デバイスの位置と向きを数センチ、数度単位の精度で特定する技術です。これにより、特定のランドマークにARコンテンツを配置したり、ARナビゲーションを実現したりといった、大規模な屋外AR体験を構築できます。ARKitには現時点で同等の公式機能はありません。

結論として、どちらのプラットフォームが優れているかという問いに単純な答えはありません。Appleデバイスの性能を最大限に引き出した、高品質でインタラクティブな体験や、フェイストラッキングを活用したアプリであればARKitが有利です。一方で、Androidを含む幅広いユーザーへのリーチや、Googleの強力なクラウド・地理空間データを活用した大規模なAR体験を構築したい場合はARCoreが有力な選択肢となるでしょう。

ARKitの対応機種一覧(iPhone/iPad)

ARKitを利用したアプリケーションを体験、または開発するためには、特定の性能要件を満たしたiPhoneまたはiPadが必要です。基本的には、A9以降のプロセッサを搭載したデバイスがARKitに対応しています。

しかし、ARKitの全ての機能を利用できるわけではなく、特にピープルオクルージョンやLiDARスキャナを活用した高度な機能は、より新しい世代のプロセッサや特定のハードウェアを搭載したモデルでのみ利用可能です。

以下に、ARKitに対応する主なiPhoneおよびiPadのモデルを一覧で示します。最新の情報については、Appleの公式Developerサイトなどを参照することをおすすめします。(このリストは2024年初頭時点の情報を基にしています)

参照:Apple Developer Documentation

【基本的なARKit機能に対応するデバイス(A9プロセッサ以降)】

これらのデバイスでは、平面検出、モーショントラッキング、環境光推定などの基本的なAR体験が可能です。

- iPhone

- iPhone 15, iPhone 15 Plus, iPhone 15 Pro, iPhone 15 Pro Max

- iPhone 14, iPhone 14 Plus, iPhone 14 Pro, iPhone 14 Pro Max

- iPhone 13, iPhone 13 mini, iPhone 13 Pro, iPhone 13 Pro Max

- iPhone 12, iPhone 12 mini, iPhone 12 Pro, iPhone 12 Pro Max

- iPhone 11, iPhone 11 Pro, iPhone 11 Pro Max

- iPhone XS, iPhone XS Max

- iPhone XR

- iPhone X

- iPhone 8, iPhone 8 Plus

- iPhone 7, iPhone 7 Plus

- iPhone 6s, iPhone 6s Plus

- iPhone SE (第1世代, 第2世代, 第3世代)

- iPad

- iPad Pro (全モデル)

- iPad (第5世代以降)

- iPad Air (第3世代以降)

- iPad mini (第5世代以降)

【高度なARKit機能に対応するデバイス】

1. ピープルオクルージョン、モーションキャプチャなど(A12 Bionicチップ以降)

これらの機能は、強力な機械学習処理能力を持つNeural Engineを搭載したA12 Bionic以降のチップを必要とします。

- iPhone

- iPhone XS, iPhone XS Max, iPhone XR 以降の全てのモデル

- iPad

- iPad Pro (2018年モデル以降)

- iPad Air (第3世代以降)

- iPad mini (第5世代以降)

- iPad (第8世代以降)

2. LiDARスキャナ搭載モデル

LiDARスキャナを搭載したデバイスでは、高速なシーン認識、インスタントAR、よりリアルなオクルージョン、RoomPlan APIなどの最先端機能が利用できます。

- iPhone

- iPhone 15 Pro, iPhone 15 Pro Max

- iPhone 14 Pro, iPhone 14 Pro Max

- iPhone 13 Pro, iPhone 13 Pro Max

- iPhone 12 Pro, iPhone 12 Pro Max

- iPad

- iPad Pro 11インチ (第2世代以降)

- iPad Pro 12.9インチ (第4世代以降)

開発を行う際には、アプリで利用したい機能がどのレベルのデバイスを要求するかを事前に確認し、テスト用の実機を準備することが非常に重要です。特にLiDARを活用するアプリを開発する場合は、対応モデルの実機がなければ開発とデバッグが困難になるため、注意が必要です。

ARKitを使ったARアプリ開発の始め方

ARKitを使ったARアプリケーション開発に挑戦してみたい、と考える方も多いでしょう。ここでは、開発をスタートするために必要な準備と、主な開発アプローチについて解説します。

開発に必要なもの

ARKitでの開発を始めるためには、いくつかのハードウェアとソフトウェアを揃える必要があります。

Mac

ARKitアプリの開発には、AppleのMacが必須です。これは、開発に使用する統合開発環境(IDE)であるXcodeがmacOS上でしか動作しないためです。WindowsやLinuxのPCでは、ネイティブのARKitアプリを開発することはできません。MacBook Air、MacBook Pro、iMac、Mac miniなど、現行のmacOSが動作するモデルであれば、どれでも開発を始めることができます。プロセッサはIntel製でもAppleシリコン(M1, M2など)でも問題ありませんが、パフォーマンスの高いAppleシリコン搭載モデルの方が、ビルド時間の短縮やシミュレータの動作が快適になるためおすすめです。

Xcode

Xcodeは、Appleが提供する公式の統合開発環境(IDE)です。SwiftやObjective-Cのコードを書くためのエディタ、アプリの見た目をデザインするインターフェースビルダー、プログラムのバグを見つけるためのデバッガ、パフォーマンスを分析するプロファイラなど、アプリ開発に必要なツールがすべて含まれています。ARKitフレームワークもXcodeに統合されています。XcodeはMacのApp Storeから無料でダウンロードしてインストールできます。常に最新バージョンを使用することが推奨されます。

ARKit対応のiPhoneまたはiPad

ARKitアプリの開発において、対応する実機(iPhoneまたはiPad)は不可欠です。XcodeにはiOSシミュレータが含まれており、Mac上で仮想的にiPhoneやiPadを動かしてアプリの基本的な動作を確認できますが、AR機能そのものはシミュレータでは動作しません。ARKitはデバイスのカメラやモーションセンサーを実際に使用するため、これらのハードウェアを持たないシミュレータではAR体験をテストできないのです。

平面検出が正しく機能するか、オブジェクトが空間に安定して表示されるか、パフォーマンスに問題はないか、といったことを確認するためには、開発中のアプリをUSBケーブル経由で実機に転送し、実際に動かしてみる必要があります。開発したいアプリの機能要件に合わせて、適切なモデル(例えばLiDAR機能を使いたいならLiDAR搭載モデル)を準備しましょう。

2つの開発アプローチ

ARKitを使ったアプリ開発には、大きく分けて2つのアプローチがあります。「ネイティブ開発」と「クロスプラットフォーム開発」です。どちらを選ぶかは、プロジェクトの要件や開発者のスキルセットによって決まります。

Swiftを使ったネイティブ開発

これは、Appleの標準的な開発手法です。プログラミング言語としてSwift(またはObjective-C)を、レンダリングフレームワークとしてRealityKitやSceneKitを、UIフレームワークとしてSwiftUIやUIKitを使用し、Xcodeで開発を進めます。

- メリット:

- 最高のパフォーマンス: ハードウェアとOSに直接アクセスするため、デバイスの性能を最大限に引き出すことができます。

- 最新機能への即時アクセス: AppleがWWDCでARKitの新機能を発表すると、その日のうちにベータ版のXcodeで試すことができます。OSの最新機能をいち早く取り入れたい場合に最適です。

- Appleエコシステムとの親和性: Core ML(機械学習)やVision(画像解析)など、他のApple製フレームワークとの連携がスムーズです。

- デメリット:

- iOS/iPadOS専用: 開発したアプリはAppleデバイスでしか動作しません。Androidにも展開したい場合は、別途ARCoreで開発する必要があります。

- 学習コスト: SwiftやApple独自のフレームワーク群(RealityKit, SwiftUIなど)の知識が必要になります。3Dグラフィックスの扱いは、Unityなどに比べるとコードベースでの記述が多くなる傾向があります。

Appleプラットフォームに特化した、高品質で最先端のAR体験を目指す場合に最適なアプローチです。

Unityを使ったクロスプラットフォーム開発

これは、世界で最も広く使われているゲームエンジンの一つであるUnityを利用するアプローチです。UnityはAR Foundationというパッケージを提供しており、これを使うことでARKitとARCoreの両方の機能を共通のAPIで操作できます。

- メリット:

- クロスプラットフォーム対応: 「Write once, deploy anywhere(一度書けば、どこにでも展開できる)」が大きな魅力です。一つのUnityプロジェクトとC#で書かれたコードから、iOS向けとAndroid向けの両方のアプリをビルドできます。開発効率を大幅に高め、より広い市場にリーチできます。

- 豊富なアセットと強力なエディタ: Unityには、3Dモデル、テクスチャ、エフェクト、ツールなどを購入・ダウンロードできる「Asset Store」があります。また、Unityのビジュアルエディタは、3Dシーンの構築やアニメーションの設定などを直感的に行えるため、3Dコンテンツを多用するアプリやゲームの開発に非常に強力です。

- 広範なコミュニティ: Unityは世界中に膨大な数の開発者コミュニティがあり、フォーラムやブログ、チュートリアルなどの情報が豊富です。問題解決のヒントを見つけやすいという利点があります。

- デメリット:

- パフォーマンスのオーバーヘッド: ネイティブ開発に比べると、Unityエンジンが介在する分、若干のパフォーマンス低下やアプリのファイルサイズ増加が見られる場合があります。

- 最新機能への対応の遅れ: ARKitやARCoreに新機能が追加されても、AR Foundationがその機能に対応するまでには少し時間がかかることがあります。

開発効率を重視し、iOSとAndroidの両方にアプリを展開したい場合や、複雑な3Dインタラクションを持つゲームのようなアプリを開発したい場合に非常に有力な選択肢となります。

UnityとAR Foundationを使った開発手順 4ステップ

ここでは、初心者にも比較的取り組みやすい「UnityとAR Foundation」を使ったARアプリ開発の基本的な流れを、4つのステップに分けて解説します。この手順で、現実空間の平面を検出して表示するという、最も基本的なARアプリを作成できます。

① 開発環境を準備する

まず、開発に必要なソフトウェアをPC(Mac)にインストールします。

Unity Hubのインストール

Unity Hubは、複数のバージョンのUnity Editorやプロジェクトを一元管理するための便利なランチャーアプリです。Unityの公式サイトからダウンロードしてインストールします。今後、異なるバージョンのUnityを使い分ける際に必須となるため、必ずUnity Hub経由で管理するようにしましょう。

Unity Editorのインストール

次に、Unity Hubを起動し、[Installs] タブからUnity Editor本体をインストールします。このとき、バージョン選択が重要です。特に理由がなければ、「LTS (Long-Term Support)」と記載されている安定版を選ぶことをお勧めします。

インストール時に「Modules」を追加する画面が表示されます。ここで、必ず「iOS Build Support」にチェックを入れてください。これを入れ忘れると、iOS向けのアプリをビルドできません。(後から追加することも可能です)

Xcodeのインストール

Unityで作成したプロジェクトを、最終的にiPhone/iPadで動作するアプリとしてビルドするためには、Xcodeが必要です。MacのApp Storeを開き、「Xcode」と検索してインストールします。インストールには時間がかかる場合があるので、先に進めておくと良いでしょう。インストール後、一度Xcodeを起動してライセンス契約に同意し、必要なコンポーネントのインストールを完了させておきます。

② Unityプロジェクトを作成する

開発環境が整ったら、Unity Hubから新しいプロジェクトを作成します。

- Unity Hubの [Projects] タブを開き、[New project] ボタンをクリックします。

- Editor versionで、先ほどインストールしたLTS版のUnity Editorを選択します。

- Templatesの一覧から、「3D (URP)」 または 「3D」 を選択します。「3D (URP)」は、比較的新しく柔軟なレンダリングパイプラインであり、モバイルでも高いパフォーマンスを発揮するためおすすめです。

- Project nameに任意のプロジェクト名(例: “MyFirstARApp”)を入力し、保存場所(Location)を指定します。

- [Create project] をクリックすると、Unity Editorが起動し、新しいプロジェクトが開きます。

③ AR Foundationパッケージを導入する

次に、UnityプロジェクトにAR機能を追加するためのパッケージを導入します。

- Unity Editorのメニューバーから [Window] > [Package Manager] を選択し、Package Managerウィンドウを開きます。

- ウィンドウ左上のドロップダウンメニューが「Packages: In Project」になっている場合は、「Packages: Unity Registry」に変更します。Unityが提供する全ての公式パッケージが表示されます。

- 検索バーに「AR Foundation」と入力して検索し、表示された「AR Foundation」パッケージを選択して、右下の [Install] ボタンをクリックします。

- 同様に、iOS向けのARKit機能を利用するために、「ARKit XR Plugin」を検索してインストールします。

(もしAndroidにも対応させたい場合は、「ARCore XR Plugin」もインストールします。)

これにより、プロジェクトでARKitの機能を利用する準備が整いました。

④ ARセッションを設定する

最後に、シーンにAR機能を追加するための基本的な設定を行います。

- Hierarchy(階層)ウィンドウで、デフォルトで配置されている「Main Camera」を右クリックして削除します。ARでは専用のカメラを使用するためです。

- Hierarchyウィンドウの何もないところを右クリックし、[XR] > [AR Session Origin] を選択してシーンに追加します。これは、AR空間における原点となり、デバイスの動きに追従するカメラを含んでいます。

- 同様に、Hierarchyウィンドウで右クリックし、[XR] > [AR Session] を選択してシーンに追加します。これは、ARセッション全体のライフサイクル(開始、停止、リセットなど)を管理する重要なコンポーネントです。

これで、ARアプリとして動作する最低限の骨格ができました。さらに、平面検出を視覚化してみましょう。

- Hierarchyウィンドウで、先ほど追加した「AR Session Origin」を選択します。

- Inspector(インスペクター)ウィンドウで [Add Component] ボタンをクリックし、「AR Plane Manager」を検索して追加します。

- AR Plane Managerコンポーネントの「Plane Prefab」という項目に、検出した平面をどのように表示するかのテンプレート(プレハブ)を指定します。簡単なプレハブを自作することもできますが、AR Foundationにはデフォルトのプレハブが用意されています。Hierarchyウィンドウで右クリックし、[XR] > [AR Default Plane] を作成し、それをAssetsフォルダ内にドラッグ&ドロップしてプレハブ化します。そして、そのプレハブをAR Plane Managerの「Plane Prefab」に設定します。

これで、アプリを実行すると、カメラが床や壁などの平面を認識し、その場所に半透明のメッシュが表示されるようになります。この上に3Dオブジェクトを配置すれば、最初のARアプリの完成です。この後のビルド設定([File] > [Build Settings])でプラットフォームをiOSに切り替え、Xcodeプロジェクトを生成し、Xcodeから実機にアプリを転送して動作を確認します。

ARKitの最新動向と将来性

ARKitは静的な技術ではなく、Appleのエコシステムと共に進化し続けるダイナミックなプラットフォームです。毎年開催されるWWDCでは新機能が発表され、その可能性は広がり続けています。ここでは、ARKitの最新動向と、Appleの次世代デバイスとの関連性から見える将来性について考察します。

最新版「ARKit 6」の新機能

WWDC 2022で発表された「ARKit 6」では、既存機能の強化に加え、いくつかの注目すべき新機能が導入されました。これらは、ARKitがよりプロフェッショナルな用途や、高品質なコンテンツ制作へと応用範囲を広げていることを示しています。

(参照:Apple Developer Documentation, WWDC 2022 Sessions)

RoomPlan

RoomPlanは、ARKit 6の中でも特にインパクトの大きい新機能です。これは、LiDARスキャナを搭載したiPhoneやiPadを使って、部屋全体をスキャンし、壁、床、天井、窓、ドア、さらには主要な家具(ソファ、テーブルなど)を含む、部屋のパラメトリックな3Dモデルを迅速に作成できるSwift APIです。

「パラメトリック」とは、単なる形状データだけでなく、「この壁の高さは2.4m、幅は3m」「これは窓で、床からの高さは0.9m」といった寸法や種類などの意味情報(セマンティクス)を持っていることを意味します。出力されるデータは、建築業界で標準的に使われるUSDやUSDZ形式でエクスポートできるため、CADソフトウェアや3Dモデリングツールで直接利用できます。

- 考えられる活用例:

- 不動産業: 内見前に顧客が自分の部屋の正確な間取り図を作成し、バーチャルで家具を配置する。

- 建築・リフォーム業: 現場で素早く寸法を測定し、3Dモデルを元にリフォーム計画を立てる。

- インテリアデザイン: 顧客の部屋のモデルを使って、最適な家具のレイアウトを提案する。

RoomPlanは、これまで専門的な機材と時間が必要だった空間のデジタル化を、誰でも手軽に行えるようにする、非常に強力なツールです。

4Kビデオ対応

ARKit 6では、ARセッションを実行しながら、背面のカメラで最大4K解像度の高品質なビデオを撮影できるようになりました。従来、ARセッション中のビデオキャプチャは解像度が制限されていましたが、このアップデートにより、AR体験そのものを鮮明な映像として記録・共有できます。ARエフェクトを使った映像作品の制作や、高品質なARコンテンツのプロモーションビデオ作成などに活用できます。

モーションキャプチャの精度向上

人の動きを追跡するモーションキャプチャ機能も、ARKit 6でさらに進化しました。特に、LiDARスキャナから得られる深度情報を活用することで、人の動きのトラッキング精度が向上しています。また、機械学習モデルの改善により、より多様なポーズや速い動きにも追従できるようになりました。これにより、フィットネスアプリでのフォームチェックや、ARキャラクターとのインタラクションが、さらに自然で正確になります。

Apple Vision Proとの関連性

ARKitの将来性を語る上で、Appleが「空間コンピュータ」と位置づけるヘッドセット型デバイス「Apple Vision Pro」の存在は無視できません。Vision Proは、ユーザーの視界に直接デジタルコンテンツを融合させる、より没入感の高いAR/MR(複合現実)体験を提供します。

ARKitとVision Pro(およびそのOSであるvisionOS)は、一見すると別々のプラットフォームに見えますが、その根底には共通の技術と哲学が流れています。

- 技術的な基盤の共有: ARKitが長年にわたりiPhone/iPadで培ってきた空間認識技術(ワールドトラッキング、平面検出、シーン理解など)は、Vision Proが現実世界を理解するための基礎となっています。ARKitで培われたノウハウやアルゴリズムは、visionOSの根幹を支える技術として昇華されています。

- 開発者エコシステムの連続性: Appleは、ARKit開発者たちがそのスキルと資産をVision Pro向けの開発に活かせるよう、エコシステムの連続性を重視しています。ARKitで使用されるレンダリングフレームワークRealityKitや、UIフレームワークSwiftUIは、visionOSにおけるアプリ開発の中心的な役割を担います。つまり、今ARKitでの開発を学ぶことは、将来的にVision Pro向けの空間コンピューティングアプリを開発するための直接的な準備となります。

- AR体験の連続性: iPhoneのARKitアプリで作成した3DコンテンツやARシーンを、Vision Proでより没入感のある形で体験するといった、デバイスを横断したシームレスな体験が期待されます。ARKitは「手軽なARの入り口」として、Vision Proは「究極の没入体験」として、相互に補完し合う関係になるでしょう。

このように、ARKitは単なるスマートフォン向けARのフレームワークに留まりません。Appleが描く「空間コンピューティング」という壮大なビジョンに向けた重要な布石であり、その開発者コミュニティと技術的資産は、未来のコンピューティング環境を形作る上で中核的な役割を果たしていくと考えられます。ARKitを学ぶことは、この大きな変化の波に乗るための第一歩と言えるでしょう。

まとめ

本記事では、Appleが提供するAR開発フレームワーク「ARKit」について、その基本概念から具体的な機能、開発の始め方、そして将来性までを包括的に解説しました。

ARKitは、iPhoneやiPadという身近なデバイスを使って、高品質で安定したAR体験を実現するための強力なツールです。その核心には、VIOによる高精度な自己位置推定、詳細なシーン解析、そしてリアルなレンダリングといった洗練された技術があります。

この記事で紹介したように、ARKitは多彩な機能を備えています。

- 床や壁を認識する平面検出

- ユーザーの表情を読み取るフェイストラッキング

- 人の全身の動きを捉えるモーションキャプチャ

- 仮想オブジェクトをリアルに見せる環境光推定やピープルオクルージョン

- LiDARスキャナを活用した高速・高精度な空間認識

- 複数人で同じAR空間を共有する機能

これらの機能を組み合わせることで、エンターテインメント、教育、ショッピング、ビジネスなど、あらゆる分野で革新的なアプリケーションを生み出す潜在能力を秘めています。

開発を始めるには、Macと対応するiPhone/iPadが必要ですが、UnityとAR Foundationを利用すれば、クロスプラットフォーム開発も可能となり、比較的低いハードルで第一歩を踏み出せます。豊富な公式ドキュメントや活発なコミュニティも、学習を進める上での大きな助けとなるでしょう。

そして、ARKitの技術と知見は、Appleの空間コンピュータ「Apple Vision Pro」へと繋がっています。今、ARKitを学ぶことは、単に現在のモバイルARアプリを開発するだけでなく、次世代のコンピューティングパラダイムである空間コンピューティングの世界への扉を開くことにも繋がります。

ARKitは、開発者にとってはアイデアを形にするための無限の可能性を秘めたキャンバスであり、ユーザーにとっては日常をより豊かで便利なものに変える魔法の杖です。この記事が、ARKitという魅力的な技術への理解を深め、新たな挑戦を始めるきっかけとなれば幸いです。