現代のビジネス環境において、「データ」は石油に匹敵するほどの価値を持つ資源と言われています。日々生成される膨大なデータをいかに活用し、ビジネス上の意思決定に役立てるかが、企業の競争力を左右する重要な要素となっています。その中核を担う技術こそが「データマイニング」です。

この記事では、データマイニングの基本的な概念から、注目される背景、具体的な手法、ビジネスでの活用事例、導入のメリット・デメリット、さらには実践的な進め方や役立つツールまで、網羅的に解説します。データ活用の第一歩を踏み出したい方から、より深くデータマイニングを理解したい方まで、幅広く役立つ情報を提供します。

目次

データマイニングとは

まず、データマイニングがどのような技術であるかを正確に理解することから始めましょう。ここでは、その基本的な定義と、混同されがちなAI(人工知能)や機械学習、統計学との関係性を明らかにしていきます。

大量のデータから価値ある知見を見つけ出す技術

データマイニング(Data Mining)とは、直訳すると「データの採掘」を意味し、統計学やAI、機械学習などの技術を駆使して、膨大なデータ(ビッグデータ)の中から、これまで知られていなかった有益なパターン、ルール、相関関係といった「価値ある知見」を発見するための技術やプロセス全体を指します。

イメージとしては、巨大な鉱山(データ)から、人手では見つけ出すことが困難な金脈(価値ある知見)を、高性能な採掘機(分析技術)を使って掘り当てる作業に似ています。企業が日々蓄積している購買履歴、ウェブサイトのアクセスログ、顧客情報、センサーデータといった多種多様なデータは、そのままでは単なる数字や文字列の羅列に過ぎません。しかし、データマイニングを適用することで、これらのデータに隠された「意味」を読み解き、ビジネス上の具体的なアクションに繋がる洞察を得ることが可能になります。

例えば、あるスーパーマーケットの購買データを分析した結果、「金曜の夕方にビールを購入する顧客は、同時におむつも購入する傾向が強い」という、一見すると無関係に思える商品の組み合わせが発見されたとします。この知見に基づき、ビールとおむつの売り場を近づける、あるいはセット割引のキャンペーンを実施するといった施策を打つことで、売上の向上が期待できます。

このように、データマイニングは、人間の勘や経験だけでは気づけないような、データに裏打ちされた客観的な事実を発見し、より精度の高い意思決定を支援することを目的としています。それは、単にデータを集計してグラフ化する「見える化」の一歩先を行く、データから未来を予測したり、隠れた法則性を見つけ出したりするための、より高度な分析アプローチなのです。

AI・機械学習・統計学との違い

データマイニングは、AI、機械学習、統計学といった関連分野と密接な関係にありますが、それぞれの概念には明確な違いがあります。これらの違いを理解することは、データマイニングの役割と位置づけを正しく把握する上で非常に重要です。

| 用語 | 概要 | 目的・役割 | 具体例 |

|---|---|---|---|

| AI(人工知能) | 人間の知的振る舞いをコンピュータで模倣する技術や概念の総称。 | 人間のような思考や判断を実現する。 | 自動運転、画像認識、自然言語処理 |

| 機械学習 | AIを実現するための主要なアプローチの一つ。データからパターンを自動で学習し、予測や分類を行う。 | データに基づいた予測モデルや識別器を構築する。 | スパムメールフィルタ、株価予測、レコメンドエンジン |

| データマイニング | 機械学習や統計学の手法を用いて、データから有益な知見を発見するプロセス。 | 未知のパターンや法則性を発見し、意思決定を支援する。 | 顧客セグメンテーション、不正利用検知、カゴ落ち分析 |

| 統計学 | データの収集、分析、解釈、表示に関する学問。 | データの性質を記述し、仮説の妥当性を検証する。 | アンケート結果の分析、製品の品質管理、選挙の出口調査 |

AIとの違い

AI(Artificial Intelligence:人工知能)は、人間が行うような学習、推論、判断といった知的活動をコンピュータシステムによって実現しようとする、非常に広範な技術分野や概念の総称です。AIという大きな枠組みの中に、機械学習やディープラーニング、そしてデータマイニングで用いられる技術が含まれる関係にあります。

AIの目的が「人間のような知能の実現」という壮大なゴールを目指すのに対し、データマイニングの目的はより具体的で、「データの中からビジネスに役立つ知見を発見すること」に特化しています。つまり、データマイニングは、AIという大きな目標を達成するための、あるいはAIシステムを構築するための重要な要素技術の一つと位置づけることができます。例えば、AIチャットボットがユーザーの質問意図を正確に理解するためには、過去の膨大な対話データをデータマイニングの手法で分析し、質問パターンと適切な回答の関係性を学習させる必要があります。

機械学習との違い

機械学習(Machine Learning)は、AIを実現するための中核的な技術であり、コンピュータがデータから自動的に「学習」し、そこに潜むパターンやルールを見つけ出すためのアルゴリズムやその研究分野を指します。機械学習の主な目的は、学習した結果を用いて、未知のデータに対する予測や分類を行う「モデル」を構築することです。

データマイニングと機械学習は、利用する技術(アルゴリズム)が重なる部分が多く、しばしば同義で使われることもありますが、その主眼とする点に違いがあります。

- 機械学習: 「予測・分類の精度」に主眼を置きます。未知のデータに対して、どれだけ正確に予測できるかというモデルの性能が最も重視されます。スパムメールの判定や、株価の予測などが典型的な応用例です。

- データマイニング: 「人間による知見の発見」に主眼を置きます。モデルの予測精度そのものよりも、そのモデルがどのようなルールに基づいて判断しているのか、そこから人間がどのような新しい洞察を得られるか、という点が重視されます。例えば、「なぜこの顧客は商品を解約する可能性が高いと予測されたのか?」その理由(パターン)を理解することが、ビジネス改善のアクションに繋がります。

簡潔に言えば、機械学習は「機械が学ぶ」プロセスそのものやその精度を重視し、データマイニングは「人間が発見する」という結果やその解釈を重視するというニュアンスの違いがあります。データマイニングは、機械学習の技術を使って、人間の意思決定を支援するプロセス全体を指す、より広範な言葉と言えるでしょう。

統計学との違い

統計学は、データの収集方法から分析、解釈に至るまでの一連の方法論を扱う学問です。限られた標本(サンプル)データから母集団全体の性質を推測したり、設定した仮説が統計的に正しいかどうかを検定したりすることに主眼を置きます。

データマイニングは、この統計学を理論的な基盤としています。回帰分析やクラスター分析など、データマイニングで用いられる手法の多くは、もともと統計学の分野で発展してきたものです。しかし、両者には目的とアプローチに違いがあります。

- 統計学: 「仮説検証」が中心的なアプローチです。分析者はまず「広告費を増やすと売上が伸びるはずだ」といった仮説を立て、その仮説が正しいかどうかをデータを使って検証します。つまり、答えのあたりを付けてから分析を始めるトップダウン的なアプローチと言えます。

- データマイニング: 「知識発見」が中心的なアプローチです。特定の仮説を持たずに、まず膨大なデータをコンピュータに分析させ、その中からこれまで知られていなかった興味深いパターンや関係性を探索的に見つけ出します。こちらは、データ主導で知見を探すボトムアップ的なアプローチです。

また、統計学が比較的クリーンで小規模なデータを対象とすることが多いのに対し、データマイニングは、ノイズや欠損値を含む、非常に大規模で雑多なデータ(ビッグデータ)を扱うことを前提としています。そのため、データマイニングでは、統計学の理論に加え、効率的に大規模データを処理するための計算機科学の技術が不可欠となります。

データマイニングが注目される理由

近年、多くの企業がデータマイニングに注目し、その導入を積極的に進めています。なぜ今、これほどまでにデータマイニングの重要性が叫ばれているのでしょうか。その背景には、主に「ビッグデータ活用の重要性の高まり」と「AI技術の急速な進化」という二つの大きな潮流があります。

ビッグデータ活用の重要性の高まり

一つ目の理由は、分析対象となる「ビッグデータ」の爆発的な増加と、その活用がビジネスの成否を分ける時代になったことです。

ビッグデータとは、単に量が多いだけでなく、多様性(Variety)、生成速度(Velocity)、量(Volume)という3つのVで特徴づけられるデータを指します。

- 量(Volume): スマートフォンやIoTデバイスの普及、SNSの利用拡大、企業のデジタル化推進により、日々生成・蓄積されるデータの量はテラバイト、ペタバイト単位へと指数関数的に増大しています。

- 多様性(Variety): 扱われるデータの種類も、従来の構造化データ(顧客データベースの数値やカテゴリなど)だけでなく、SNSの投稿テキスト、画像、動画、音声、ウェブサイトのクリックストリーム、センサーログといった非構造化・半構造化データまで、多岐にわたっています。

- 生成速度(Velocity): データが生成され、更新されるスピードも非常に速くなっています。株価の変動、SNSでのトレンドの発生、工場のセンサーデータなどは、リアルタイムで流れ込み続けます。

これらのビッグデータは、文字通り「情報の宝の山」です。顧客の購買行動、市場のトレンド、製品の利用状況、サプライチェーンの動きなど、ビジネスに関わるあらゆる事象がデータとして記録されています。しかし、その膨大さと複雑さゆえに、従来の手作業による集計や分析、あるいは人間の勘や経験だけでは、その全体像を把握し、価値を引き出すことは極めて困難です。

そこでデータマイニングが不可欠となります。データマイニングは、この巨大で雑多なデータの海の中から、人間では見つけられない微かなパターンや相関関係を自動的に発見し、ビジネス価値へと変換する強力な羅針盤の役割を果たします。

例えば、ECサイトの膨大なアクセスログを分析すれば、顧客がどのような経路で商品ページにたどり着き、どの情報を見て購入を決め、あるいは購入をやめてしまうのか(カゴ落ち)といった詳細な行動パターンが明らかになります。この知見は、サイトのデザイン改善や、離脱しそうな顧客へのクーポン提示といった具体的な施策に繋がり、直接的に売上向上に貢献します。

このように、データに基づいた客観的な意思決定(データドリブン経営)へのシフトは、もはや一部の先進的な企業だけのものではありません。あらゆる業界において、競争優位性を確立し、生き残るための必須要件となりつつあります。この流れの中で、ビッグデータを価値に変えるための核心技術であるデータマイニングに注目が集まるのは、必然と言えるでしょう。

AI技術の急速な進化

二つ目の理由は、データマイニングを支えるAI、特に機械学習技術の目覚ましい進化です。

過去にもデータマイニングの概念自体は存在していましたが、その能力はコンピュータの処理性能やアルゴリズムの限界によって制約されていました。しかし、21世紀に入り、以下の三つの要素が劇的に進化したことで、データマイニングは実用的な技術として一気に開花しました。

- 計算能力の飛躍的向上: ムーアの法則に示されるように、CPUの性能は向上し続けています。さらに、もともと画像処理のために開発されたGPU(Graphics Processing Unit)が、その高い並列計算能力からAIの計算に転用されるようになり、ディープラーニングのような複雑なモデルの学習時間を劇的に短縮しました。クラウドコンピューティングの普及も、企業が必要な時に必要なだけ高性能な計算リソースを低コストで利用できる環境を整えました。

- アルゴリズムの洗練: ディープラーニング(深層学習)をはじめとする、より高度で精度の高い機械学習アルゴリズムが次々と開発・実用化されています。これにより、従来の手法では困難だった画像認識、自然言語処理、音声認識といった非構造化データの高度な分析が可能になりました。例えば、SNSの投稿テキストから顧客の感情(ポジティブ/ネガティブ)を分析したり、監視カメラの映像から異常行動を検知したりといった応用が現実のものとなっています。

- オープンソースソフトウェアの普及: PythonやRといったプログラミング言語や、scikit-learn、TensorFlow、PyTorchといった機械学習ライブラリがオープンソースとして無償で公開されています。これにより、世界中の研究者や開発者が最新のアルゴリズムにアクセスし、改良を加え、知識を共有するエコシステムが形成されました。企業はこれらの強力なツールを比較的低コストで利用でき、データマイニング導入のハードルが大きく下がりました。

これらの技術的背景が組み合わさることで、以前は専門の研究者や一部の大企業しか扱えなかった高度なデータ分析が、より多くの企業にとって身近なものとなりました。AI技術の進化は、データマイニングの「できること」の範囲を大きく広げ、その精度と実用性を格段に高めたのです。ビッグデータという「燃料」と、進化したAIという「エンジン」が揃ったことで、データマイニングという「車」は、ビジネスを加速させるための強力な駆動力として、今、大きな注目を集めているのです。

データマイニングで実現できること

データマイニングは、具体的にどのようなことを可能にするのでしょうか。その機能は多岐にわたりますが、ビジネスにおける主な目的は大きく「予測」「分類(グループ分け)」「関連性の発見」の3つに大別できます。これらの能力を組み合わせることで、企業はより賢明な意思決定を下せるようになります。

将来の出来事を予測する

データマイニングの最も強力な能力の一つが、過去のデータパターンに基づき、未来に起こる出来事を高い確度で予測することです。これは、ビジネスの様々な場面で不確実性を減らし、先を見越した戦略的なアクションを可能にします。

例えば、以下のような予測が可能です。

- 需要予測: 小売業や製造業において、過去の販売実績、天候、季節、イベント情報などを分析し、特定の商品が将来どれだけ売れるかを予測します。正確な需要予測は、過剰在庫による廃棄ロスの削減や、品切れによる販売機会の損失を防ぎ、在庫の最適化を実現します。これにより、キャッシュフローの改善や収益性の向上に直結します。

- 顧客の解約予測(チャーン予測): サブスクリプションサービスや携帯電話キャリアなどでは、顧客の利用状況、問い合わせ履歴、ウェブサイト上の行動などを分析し、どの顧客が近いうちにサービスを解約しそうかを予測します。解約の兆候が見られる顧客を早期に特定できれば、個別にクーポンを提供したり、サポート担当者から連絡を入れたりするなど、解約を引き留めるためのプロアクティブな働きかけが可能になります。

- 設備の故障予測(予知保全): 製造業の工場では、機械に設置されたセンサーから収集される稼働データ(温度、振動、圧力など)を分析し、どの部品がいつ頃故障しそうかを予測します。これにより、故障が発生して生産ラインが停止してしまう前に、計画的にメンテナンスを実施できます。予期せぬダウンタイムを最小限に抑え、生産性を最大化することに貢献します。

- 売上予測: 過去の売上データや市場トレンド、広告宣伝費などの要因を分析し、将来の売上高を予測します。これは、経営計画の策定、予算配分、リソースの投入計画などを立てる上で、極めて重要な情報となります。

これらの予測は、もはや単なる「勘」や「経験則」ではありません。データという客観的な根拠に基づいた、統計的に確かな未来の見通しです。データマイニングによる予測は、企業がリアクティブ(事後対応型)な経営から、プロアクティブ(事前対応型)な経営へと転換するための鍵となります。

データをグループ分けして特徴を把握する

データマイニングは、膨大で雑多なデータの中から、似たような性質を持つものを集めて、意味のあるグループに分ける(クラスタリングまたはセグメンテーション)ことも得意です。これにより、複雑なデータの全体像を構造的に理解し、それぞれのグループが持つ独自の特徴を把握できます。

主な活用例は以下の通りです。

- 顧客セグメンテーション: 顧客の属性(年齢、性別、居住地など)や購買履歴、ウェブ行動履歴といったデータを分析し、顧客をいくつかのグループ(セグメント)に分類します。例えば、「高価格帯の商品を頻繁に購入するロイヤル顧客」「セール品を中心に購入する価格重視顧客」「最近利用が減っている休眠予備軍」といった具体的な顧客像が浮かび上がります。各セグメントの特徴を深く理解することで、それぞれのニーズに合わせた、より効果的なマーケティング施策を展開できます。ロイヤル顧客には新商品の先行案内を、価格重視顧客にはセール情報を、といった具合に、パーソナライズされたアプローチが可能になり、顧客満足度とエンゲージメントの向上に繋がります。

- 異常検知: 大量の正常なデータパターンを学習させ、そこから大きく逸脱するデータ(異常値)を検出します。金融業界におけるクレジットカードの不正利用検知が典型例です。普段の利用パターン(利用場所、金額、時間帯など)と著しく異なる決済が行われた際に、システムが自動で異常を検知し、取引を一時停止したり、本人確認を求めたりします。これにより、金銭的な被害を未然に防ぐことができます。製造業の品質管理や、サイバーセキュリティにおける不正アクセス検知などにも応用されています。

- テキストマイニングによる文書分類: ニュース記事、顧客からの問い合わせメール、SNSの投稿といった大量のテキストデータを、その内容に基づいて自動的にカテゴリー分けします。例えば、問い合わせメールを「製品に関する質問」「料金に関するクレーム」「技術的なサポート依頼」などに分類できれば、適切な担当部署へ迅速に振り分けることができ、対応の効率化と迅速化が図れます。

データを意味のあるグループに分けることは、複雑な問題を単純化し、どこから手をつけるべきか、どのターゲットに注力すべきか、といった戦略的な優先順位付けを容易にします。

データ同士の隠れた関連性を見つける

データマイニングは、一見すると無関係に見えるデータ項目間の、意外な関連性やルールを発見することもできます。これは「アソシエーション分析」と呼ばれる手法で、特に小売業やマーケティング分野で強力な武器となります。

最も有名な例が、冒頭でも触れた「ビールとおむつ」の逸話です。あるスーパーの購買データを分析したところ、「金曜の夜に、おむつを購入する男性客は、ビールも一緒に購入する傾向が非常に強い」というルールが発見されました。これは、週末に備えて妻からおむつを買ってくるように頼まれた父親が、ついでに自分のためのビールも買っていく、という生活パターンを反映していると推測できます。

このような、人間の直感ではなかなか思いつかないような隠れた関連性(アソシエーション・ルール)を発見できれば、以下のような具体的なアクションに繋げられます。

- クロスセル・アップセルの促進: 関連性の高い商品を近くに陳列する(売り場レイアウトの最適化)、ECサイトで「この商品を買った人はこんな商品も見ています」とレコメンドする、セット割引を提供するなど、合わせ買いを促進する施策を打つことができます。

- キャンペーンの最適化: 特定の商品Aを購入した顧客は、次に商品Bを購入する可能性が高い、というルールが分かっていれば、商品Aの購入者に後日商品Bの割引クーポンを送付する、といった効果的なダイレクトマーケティングが可能になります。

- 商品開発のヒント: 意外な商品の組み合わせから、新たな顧客ニーズや利用シーンを読み取り、新商品の開発やサービスの改善に繋げるヒントを得ることもできます。

データマイニングによる関連性の発見は、既存の顧客や商品からさらなる価値を引き出し、売上を最大化するための強力な洞察を提供してくれます。それは、データの中に眠る「暗黙知」を「形式知」へと変換するプロセスとも言えるでしょう。

データマイニングの代表的な4つの手法

データマイニングで価値ある知見を発見するためには、解決したい課題やデータの種類に応じて、適切な分析手法を選択する必要があります。ここでは、ビジネスの現場で頻繁に用いられる代表的な4つの手法、「クラス分類分析」「クラスタリング分析」「アソシエーション分析」「回帰分析」について、その特徴と仕組みを詳しく解説します。

| 手法名 | 目的 | 特徴 | 主なアルゴリズム | ビジネスでの活用例 |

|---|---|---|---|---|

| クラス分類分析 | データを既知のカテゴリに分類する | 正解データ(教師データ)を用いて学習する「教師あり学習」 | 決定木、ロジスティック回帰、サポートベクターマシン | 顧客の購入予測、スパムメール判定、DM反応予測 |

| クラスタリング分析 | データを未知のグループに分割する | 正解データを用いずに学習する「教師なし学習」 | k-means法、階層的クラスタリング | 顧客セグメンテーション、異常検知、文書分類 |

| アソシエーション分析 | データ間の隠れた関連性・ルールを発見する | 「If-Then」形式のルールを見つけ出す「教師なし学習」 | Apriori、Eclat | 商品の同時購入分析(バスケット分析)、レコメンデーション |

| 回帰分析 | 数値データを予測する | 連続する数値を予測する「教師あり学習」 | 線形回帰、非線形回帰、リッジ回帰 | 売上予測、株価予測、不動産価格の査定 |

クラス分類分析

クラス分類分析は、過去のデータから学習したルールに基づき、新しいデータがどのカテゴリ(クラス)に属するかを予測・分類する手法です。「教師あり学習」と呼ばれる機械学習アプローチの一つであり、分析を始める前に、各データがどのカテゴリに属するかという「正解ラベル」が付与されたデータセット(教師データ)を準備する必要があります。

【仕組みのイメージ】

例えば、ダイレクトメール(DM)を送付した顧客が商品を購入したかどうかのデータを考えます。この場合、教師データは「年齢」「年収」「居住地」「過去の購入回数」といった顧客の情報と、「購入した/購入しなかった」という正解ラベルのセットになります。クラス分類分析では、この教師データをアルゴリズムに学習させ、「どのような特徴を持つ顧客が購入しやすいか」というパターン(モデル)を構築します。

そして、この構築されたモデルに、まだDMを送っていない新しい顧客の情報を入力すると、その顧客が「購入する可能性が高い」か「購入する可能性が低い」かを予測できます。

【代表的なアルゴリズム】

- 決定木(Decision Tree): データを「はい/いいえ」で答えられる質問を繰り返すことで、木のような構造で分類していく手法です。結果が視覚的に分かりやすく、なぜそのように分類されたのかという理由を解釈しやすいのが大きな特徴です。「年収は500万円以上か?」「過去1年以内に購入履歴はあるか?」といった分岐をたどっていくイメージです。

- ロジスティック回帰: ある事象が発生する確率を予測するための統計的手法です。結果が0から1までの確率値として出力されるため、「この顧客が購入する確率は75%」といった具体的な予測が可能です。

- サポートベクターマシン(SVM): データを分類する際に、各クラス間の距離(マージン)が最も大きくなるような境界線を見つけ出す手法です。複雑なデータの分類において、高い精度を発揮することが知られています。

【ビジネスでの活用例】

- マーケティング: 顧客が特定のキャンペーンに反応するかどうかの予測、サービスの解約予測(チャーン分析)。

- 金融: 融資の申し込み者が債務不履行に陥るリスクの判定(与信スコアリング)。

- 医療: 検査データから特定の疾患の有無を診断する支援。

クラス分類分析は、「AかBか」「YesかNoか」といった明確な答えを予測したい場合に非常に有効な手法です。

クラスタリング分析

クラスタリング分析は、クラス分類分析とは対照的に、正解ラベルがないデータセットの中から、似た者同士を自動的に集めてグループ(クラスタ)を形成する手法です。「教師なし学習」の代表的なアプローチであり、データに潜む自然な構造やセグメントを発見することを目的とします。分析者も事前にどのようなグループが存在するのか分かっていない状態で、データそのものの類似性に基づいて分類を行います。

【仕組みのイメージ】

あるECサイトの全顧客のデータ(年齢、性別、購入金額、訪問頻度、閲覧商品カテゴリなど)があるとします。クラスタリング分析を適用すると、これらのデータを分析し、「高価なファッションアイテムを頻繁に購入する20代女性」「ガジェット類をたまにまとめ買いする30代男性」「日用品を定期的に購入する40代主婦」といった、特徴の異なる複数の顧客クラスタを自動的に見つけ出すことができます。

【代表的なアルゴリズム】

- k-means法(k平均法): 最も広く使われるクラスタリング手法の一つです。事前にいくつのクラスタに分けるか(kの数)を決め、各データ点が最も近いクラスタの中心に属するように、クラスタの割り当てと中心の更新を繰り返して、最適なグループ分けを見つけます。計算が高速で、大規模なデータにも適用しやすいのが特徴です。

- 階層的クラスタリング: 個々のデータを一つのクラスタとみなし、最も似ているクラスタ同士を順番に併合していくことで、最終的に一つの大きなクラスタになるまでの樹形図(デンドログラム)を作成します。分析者はこの樹形図を見て、適切な階層で分割することで、任意の数のクラスタを得ることができます。

【ビジネスでの活用例】

- 顧客セグメンテーション: 上記の例のように、顧客を特徴の似たグループに分け、それぞれのセグメントに合ったマーケティング戦略を立案する。

- 異常検知: どのクラスタにも属さない孤立したデータ点を「異常」として検出する。例えば、製造ラインのセンサーデータで、通常とは異なる挙動を示すものを発見する。

- 画像セグメンテーション: 画像の中から、似た色の領域をグループ化し、物体を認識する前処理などに利用される。

クラスタリング分析は、未知のデータ構造を探索し、顧客や製品、市場などを理解するための新たな切り口を発見したい場合に強力なツールとなります。

アソシエーション分析

アソシエーション分析は、大量のデータの中から「もしAが起これば、Bも起こりやすい」といった、項目間の興味深い関連性やルール(アソシエーション・ルール)を発見する手法です。「教師なし学習」に分類され、特に小売業の購買データ分析(バスケット分析)で広く知られています。

【仕組みのイメージ】

スーパーマーケットの全トランザクションデータ(1回の買い物で購入された商品のリスト)を分析します。アソシエーション分析は、このデータの中から、「商品Aと商品Bが一緒に購入されることが多い」という組み合わせを網羅的に探し出します。有名な「ビールとおむつ」の例は、この分析によって発見されたものです。

この分析では、発見されたルールの有用性を評価するために、いくつかの指標が用いられます。

- 支持度(Support): 全てのトランザクションの中で、そのルール(例:ビールとおむつの両方)が含まれる割合。ルールの全体的な重要性を示す。

- 信頼度(Confidence): 商品Aが含まれるトランザクションの中で、商品Bも含まれている割合。「もしビールが買われたら、おむつも買われる確率」を示す。

- リフト値(Lift): 「商品Aと商品Bが一緒に買われる確率」が「それぞれが独立して買われる確率の積」の何倍かを示す。1より大きいほど、偶然以上の強い関連があることを意味する。

【ビジネスでの活用例】

- クロスセル戦略: レジ横にガムや電池を置く、ECサイトで「よく一緒に購入される商品」としてレコメンドするなど、関連性の高い商品を組み合わせて売上向上を図る。

- 売り場レイアウトの最適化: 関連性の高い商品を近くに陳列し、顧客が回遊しやすく、ついで買いをしやすい店舗設計を行う。

- Webサイトの導線改善: あるページを見たユーザーが次に関心を持ちやすいページへのリンクを設置し、サイト内での滞在時間を延ばす。

アソシエーション分析は、顧客の行動パターンを深く理解し、売上機会を最大化するための具体的なヒントを提供してくれます。

回帰分析

回帰分析は、ある目的となる数値(目的変数)が、他の複数の要因(説明変数)によってどの程度影響を受けるかを分析し、その関係性を数式(回帰モデル)で表す手法です。「教師あり学習」の一種で、クラス分類がカテゴリを予測するのに対し、回帰分析は売上高や気温、株価といった連続する数値を予測するのに用いられます。

【仕組みのイメージ】

あるマンションの価格を予測したいとします。この場合、目的変数は「価格」です。説明変数として「駅からの距離」「部屋の広さ」「築年数」「周辺の商業施設の数」といった要因を考えます。回帰分析では、過去の多数の物件データ(説明変数と、実際の成約価格である目的変数のセット)を学習し、「価格 = a × 駅からの距離 + b × 部屋の広さ + c × 築年数 + d」といった形の予測式を導き出します。この式が完成すれば、新しい物件の情報を入力するだけで、その妥当な価格を予測できます。

【代表的なアルゴリズム】

- 線形回帰(単回帰・重回帰): 説明変数と目的変数の関係が直線的であると仮定して予測式を求める、最も基本的な回帰手法です。説明変数が一つの場合を「単回帰」、複数の場合を「重回帰」と呼びます。

- 非線形回帰: 関係が直線的でない複雑なデータに対して、曲線的な関係をモデル化する手法です。多項式回帰などが含まれます。

【ビジネスでの活用例】

- 売上予測: 広告費、セール期間、季節要因などから、将来の店舗や商品の売上高を予測する。

- 需要予測: 気温や曜日から、コンビニのアイスクリームや電力の需要量を予測する。

- 金融: 経済指標や金利の動向から、将来の株価や為替レートを予測する。

回帰分析は、ビジネスにおける様々なKPI(重要業績評価指標)を予測し、計画立案やリスク管理に役立てるための不可欠な手法と言えます。

データマイニングのビジネスにおける活用方法

データマイニングは、理論上の概念にとどまらず、既に様々な業界のビジネス現場で実践的に活用され、具体的な成果を生み出しています。ここでは、特にデータ活用が進んでいる「小売・EC」「金融」「製造」「マーケティング」の4つの分野に焦点を当て、具体的な活用方法を掘り下げていきます。

小売・EC業界での活用

顧客との接点が多く、大量の購買データが蓄積されやすい小売・EC業界は、データマイニング活用の最前線と言えます。勘や経験に頼った従来の店舗運営やマーケティングから脱却し、データに基づいた科学的なアプローチで顧客体験の向上と収益の最大化を目指しています。

- バスケット分析によるクロスセル促進: データマイニングの代表的な手法であるアソシエーション分析を活用し、顧客がどのような商品を一緒に購入しているか(バスケットの中身)を分析します。前述の「ビールとおむつ」のように、意外な商品の組み合わせを発見できれば、店舗のレイアウト変更や、ECサイトでのレコメンド機能の精度向上に繋がります。「この商品を買った人はこんな商品も買っています」という表示は、まさにバスケット分析の結果を応用したものです。これにより、顧客一人当たりの購入単価(客単価)の向上が期待できます。

- 顧客セグメンテーションとパーソナライズ: 購買履歴、閲覧履歴、デモグラフィック情報(年齢・性別など)をクラスタリング分析にかけることで、顧客を複数のセグメントに分類します。例えば、「流行に敏感な若年層」「価格重視のファミリー層」「高品質を求めるシニア層」など、具体的な顧客像を定義します。各セグメントの特性を深く理解することで、それぞれに響くメッセージや商品を盛り込んだメールマガジンを配信したり、個別のクーポンを提供したりといった、きめ細やかなパーソナライズド・マーケティングが可能になります。画一的なアプローチから脱却し、顧客一人ひとりとの関係性を深めることができます。

- 需要予測による在庫最適化: 過去の販売データに加えて、天候、曜日、季節、イベント、周辺地域の行事などの外部要因も取り込み、回帰分析などを用いて将来の商品需要を予測します。これにより、品切れによる販売機会の損失と、過剰在庫による廃棄ロスや管理コストを同時に削減できます。特に、生鮮食品や季節商品など、賞味期限が短く需要の変動が大きい商品を扱うスーパーマーケットやコンビニエンスストアにとって、在庫の最適化は収益性に直結する重要な課題です。

- LTV(顧客生涯価値)の予測: 顧客が将来にわたって自社にもたらしてくれる利益の総額(LTV: Life Time Value)を予測します。過去の購買頻度、購入金額、利用期間などから、どの顧客が将来の優良顧客になりそうかを予測し、LTVの高い顧客セグメントに対して重点的にリソースを投下する、といった戦略的な判断が可能になります。

金融業界での活用

金融業界は、古くから統計的なリスク管理手法を取り入れており、データマイニングとの親和性が非常に高い分野です。不正の防止、リスクの最小化、そして顧客への最適な金融商品の提案など、その活用範囲は多岐にわたります。

- 不正利用検知(Fraud Detection): クレジットカードの利用履歴データをリアルタイムで監視し、過去の膨大な不正パターンと照合します。クラス分類分析や異常検知の手法を用い、個人の通常の利用パターン(利用場所、金額、時間帯、購入商品カテゴリなど)から大きく逸脱した取引を瞬時に検知します。例えば、東京在住の人が、突然海外のサイトで高額な決済を行った場合、システムが「不正利用の可能性が高い」と判断し、取引を保留して本人に確認を促す、といった仕組みです。これにより、利用者の金銭的被害とカード会社のリスクを最小限に抑えます。

- 与信審査(クレジットスコアリング): 融資やカード発行の申し込みがあった際に、申込者の属性情報(年収、勤務先、勤続年数、居住形態など)や過去の信用情報(他社からの借入状況や返済履歴など)を基に、その個人の信用力をスコア化します。回帰分析やクラス分類分析が用いられ、貸し倒れのリスクを定量的に評価します。これにより、審査プロセスを迅速化・自動化すると同時に、客観的な基準に基づいた公平な審査を実現します。

- 金融商品のレコメンデーション: 顧客の資産状況、取引履歴、年齢、ライフステージなどを分析し、その顧客に最も適した投資信託、保険、ローン商品などを提案します。例えば、20代の独身顧客には少額から始められる積立投資を、子供が生まれた30代の顧客には学資保険を提案するなど、顧客の潜在的なニーズを先回りして捉え、適切なタイミングでアプローチすることで、成約率の向上と顧客満足度の向上を目指します。

製造業での活用

スマートファクトリー化が進む製造業においても、データマイニングは生産性の向上と品質管理の高度化に不可欠な技術となっています。工場のあらゆる機器に設置されたIoTセンサーから収集される膨大なデータを活用します。

- 予知保全(Predictive Maintenance): 設備や機械の稼働データ(温度、振動、圧力、音など)を時系列で分析し、故障の兆候を事前に検知します。回帰分析や時系列分析を用いて、部品の寿命や異常値の発生を予測します。これにより、「壊れてから直す(事後保全)」のではなく、「壊れる前に直す(予知保全)」ことが可能になり、突然のライン停止による生産ロスを防ぎ、メンテナンスコストの最適化を図ることができます。

- 品質管理と不良品原因の特定: 製品の製造プロセスにおける様々なパラメータ(温度、湿度、圧力、速度など)と、完成品の品質検査結果のデータを紐づけて分析します。クラス分類分析や決定木などを用いて、どのような条件下で不良品が発生しやすいか、という根本原因を特定します。原因が分かれば、製造プロセスの条件を最適化することで、不良品の発生率そのものを低減させ、製品の品質向上と安定化に繋げることができます。

- 需要予測に基づく生産計画: 小売業と同様に、市場の需要を予測し、それに基づいて生産計画を立案します。これにより、見込み生産における過剰在庫や欠品のリスクを低減し、サプライチェーン全体の効率化に貢献します。

マーケティング分野での活用

業界を問わず、あらゆる企業のマーケティング活動において、データマイニングは顧客理解を深め、施策の効果を最大化するための強力な武器となります。

- キャンペーン効果の最大化: 過去のキャンペーン実績データを分析し、どのような属性の顧客が、どのような内容のオファー(割引、ポイント還元など)に、どのチャネル(メール、SNS、アプリ通知など)でアプローチした際に最も反応が良かったかを分析します。これにより、次回のキャンペーンを設計する際に、最も費用対効果の高いターゲットとアプローチ方法を選択できます。無駄な広告費を削減し、ROI(投資対効果)を最大化します。

- 解約(チャーン)予測とリテンション施策: 顧客のサービス利用頻度の低下、サポートへの問い合わせ内容の変化、ウェブサイト上の行動パターンなどから、解約の兆候を早期に検知します。解約の可能性が高いと予測された顧客に対して、特別な割引オファーを提示したり、利用方法をサポートする連絡を入れたりするなど、個別のリテンション(顧客維持)施策を講じることで、顧客離れを未然に防ぎます。新規顧客の獲得コストは既存顧客の維持コストの数倍かかると言われており、チャーンの抑制は収益安定化に極めて重要です。

- Webサイトの最適化: Webサイトのアクセスログを分析し、ユーザーの回遊パターン、離脱率の高いページ、コンバージョンに至るまでの経路などを詳細に把握します。アソシエーション分析を用いて、どのページを見たユーザーが次にどのページに関心を持つかを予測し、適切な内部リンクを設置することで、サイト内での滞在時間を延ばし、コンバージョン率の向上を目指します。

これらの活用方法はほんの一例であり、データマイニングの応用範囲は、アイデア次第で無限に広がります。重要なのは、自社のビジネス課題が何であり、それを解決するためにどのようなデータが利用でき、どの分析手法が適しているかを考えることです。

データマイニングを導入するメリット

データマイニングを導入し、データドリブンな意思決定を推進することは、企業に多くの競争優位性をもたらします。そのメリットは、単なるコスト削減や売上向上にとどまらず、組織文化の変革にまで及びます。ここでは、代表的な3つのメリットについて詳しく解説します。

業務効率化と生産性の向上

データマイニングは、これまで人間の勘や経験、あるいは手作業に頼っていた多くの業務を、データに基づいた客観的な判断へと置き換え、自動化・効率化します。

例えば、製造業における予知保全が典型例です。従来は、ベテラン作業員が機械の異音や微細な振動といった「勘」を頼りに故障の兆候を察知したり、定期的な部品交換(時間基準保全)を行ったりしていました。しかし、データマイニングを導入すれば、センサーデータから故障の予兆を科学的に検知し、最適なタイミングでメンテナンスを計画できます。これにより、不要なメンテナンス作業を削減し、熟練作業員の貴重な時間をより付加価値の高い業務に振り分けることができます。また、予期せぬダウンタイムがなくなることで、工場全体の生産性も大きく向上します。

小売業における需要予測も同様です。経験豊富なバイヤーが立てる発注計画は貴重ですが、データマイニングは天候やイベントといった複雑な要因を考慮した、より客観的で精度の高い予測を可能にします。これにより、発注業務にかかる時間を短縮し、担当者はより戦略的な仕入れ計画や販促企画の立案に集中できます。在庫管理が最適化されることで、在庫確認や棚卸しにかかる労力、廃棄処理のコストも削減されます。

このように、データマイニングは「予測」や「分類」といったタスクを自動化することで、従業員を定型的な判断業務から解放し、より創造的・戦略的な仕事に取り組む時間と余裕を生み出します。これが組織全体の業務効率化と生産性の向上に直結するのです。

顧客満足度の向上につながる

データマイニングは、顧客一人ひとりをより深く理解するための強力なレンズです。顧客データを分析することで、これまで見えなかった顧客の潜在的なニーズや不満を捉え、それに応えることで顧客満足度を飛躍的に高めることができます。

最大の鍵は「パーソナライゼーション」です。クラスタリング分析によって顧客をセグメンテーションし、それぞれのグループの嗜好や行動パターンを把握すれば、画一的なアプローチから脱却できます。ECサイトで、ユーザーの閲覧履歴や購買履歴に基づいて「あなたへのおすすめ」商品を表示するのは、データマイニングによるパーソナライゼーションの身近な例です。自分にぴったりの商品が提案されれば、顧客は「自分のことをよく分かってくれている」と感じ、企業への信頼感や愛着(エンゲージメント)が高まります。

また、顧客の不満を先回りして解消することも可能です。サブスクリプションサービスにおいて、解約の兆候が見られる顧客を予測し、問題が深刻化する前にサポートを提供したり、より最適なプランを提案したりすることで、顧客の離反を防ぎ、むしろロイヤルティを高めるきっかけにさえなり得ます。

金融機関が顧客のライフステージの変化を捉え、住宅ローンや教育ローンを適切なタイミングで提案することも、顧客満足度向上に繋がる好例です。顧客自身がニーズを自覚する前に、企業側から的確なソリューションを提示できれば、それは単なる営業活動を超えた、価値あるコンサルティングとして受け止められるでしょう。

データマイニングを通じて顧客一人ひとりに寄り添った体験を提供することは、価格競争から脱却し、顧客との長期的な信頼関係を築くための強力な差別化要因となります。

新たなビジネスチャンスの発見

データマイニングは、既存のビジネスを効率化したり、改善したりするだけでなく、全く新しいビジネスチャンスや収益源を発見するきっかけをもたらします。

アソシエーション分析で発見される「意外な商品の組み合わせ」は、その典型です。これまで想定していなかった顧客層や利用シーンが存在することを示唆しており、新たな商品開発や異業種とのコラボレーションのヒントになる可能性があります。例えば、ある食品メーカーが自社製品の購買データを分析したところ、特定の健康食品が、介護施設で働く職員に多く購入されていることが判明したとします。これは、当初想定していなかった「介護現場での栄養補助」という新たな市場が存在することを示しており、介護食市場への本格参入という新たな事業展開に繋がるかもしれません。

また、自社が保有するデータを分析・加工し、それ自体を新たな商品・サービスとして提供する「データビジネス」への道も開かれます。例えば、交通系ICカードの会社が、匿名化された乗降履歴データを分析し、特定の駅周辺の人流データや時間帯別の混雑度レポートとして、店舗開発を目指す小売業者や地方自治体に販売する、といったビジネスモデルが考えられます。

さらに、データ分析を通じて自社の強みや弱みを客観的に把握することは、M&A(企業の合併・買収)や事業提携といった、より大きな経営戦略の意思決定にも役立ちます。

データマイニングは、企業が自社の足元に眠る「データ」という資産の価値を再発見し、未来の成長に向けた新たな羅針盤を手に入れるためのプロセスなのです。それは、日々の改善活動にとどまらない、非連続的な成長、すなわちイノベーションを創出する原動力となり得ます。

データマイニング導入のデメリットと注意点

データマイニングは企業に多大なメリットをもたらす一方で、その導入と運用には専門的な知識やコスト、そして慎重な配慮が求められます。成功のためには、そのデメリットや注意点を事前に正しく理解し、適切な対策を講じることが不可欠です。

導入のデメリット

データマイニングの導入を検討する際に、多くの企業が直面するであろう二つの大きな壁が「人材」と「コスト」です。

専門知識を持つ人材の確保が必要

データマイニングを効果的に実行するためには、高度な専門知識を持つ人材、すなわち「データサイエンティスト」や「データアナリスト」の存在が不可欠です。

これらの専門家は、単にツールを操作できるだけでは不十分です。

- ビジネス理解力: 企業のビジネス課題が何であるかを深く理解し、それを解決するためにどのようなデータ分析が必要かを定義する能力。

- データサイエンススキル: 統計学、機械学習、プログラミング(PythonやRなど)といった専門知識を駆使して、実際にデータを分析し、モデルを構築する能力。

- コミュニケーション能力: 分析結果から得られた難解な知見を、専門家でない経営層や現場の担当者にも分かりやすく説明し、具体的なアクションに繋げる能力。

これら三つのスキルを高いレベルで兼ね備えた人材は非常に希少であり、採用市場での競争は激化しています。優秀なデータサイエンティストの確保は難しく、また人件費も高騰しがちです。社内で育成するにしても、体系的な教育プログラムの構築や、実務経験を積ませる環境の整備など、時間とコストがかかります。人材を確保できないままプロジェクトを進めても、期待した成果が得られず、投資が無駄になってしまうリスクがあります。

導入・運用にコストがかかる

データマイニングには、様々な側面でコストが発生します。

- ツール・ソフトウェア費用: データマイニングを実行するための専用ソフトウェアやプラットフォームの導入には、ライセンス費用がかかります。特に高機能な商用ツールは、年間数百万円から数千万円に及ぶこともあります。オープンソースのツールを利用する場合でも、その環境構築やメンテナンスには専門知識を持つエンジニアの工数が必要です。

- インフラ費用: ビッグデータを保管・処理するための高性能なサーバーやストレージ、あるいはクラウドサービスの利用料が必要です。特に、リアルタイム分析やディープラーニングなど、高い計算能力を要求する処理を行う場合は、インフラコストも相応に大きくなります。

- 人件費: 前述の通り、専門人材の採用や育成には高いコストがかかります。外部のコンサルティング会社やベンダーに委託する場合も、相応の費用が発生します。

- データ準備コスト: 分析に使える質の高いデータを用意するための「データ前処理」にも、見えないコストがかかっています。異なるシステムに散在するデータを収集・統合したり、欠損値や表記の揺れを修正(クレンジング)したりする作業は、データ分析プロジェクト全体の工数の5〜8割を占めるとも言われており、多大な労力と時間が必要です。

これらの初期投資(イニシャルコスト)と継続的な運用費用(ランニングコスト)を賄えるだけの体力と、それに見合うリターン(ROI)が見込めるかどうかの慎重な判断が求められます。

導入時の注意点

コストや人材の問題をクリアできたとしても、プロジェクトを成功に導くためには、さらにいくつかの重要な点に注意を払う必要があります。

分析の目的をはっきりとさせる

データマイニングを導入する上で最も重要なことは、「何のために分析を行うのか」という目的を明確に設定することです。目的が曖昧なまま「とりあえずデータを分析してみよう」と始めると、分析すること自体が目的化してしまい(手段の目的化)、膨大な時間とコストを費やしたにもかかわらず、ビジネスに何の役にも立たない興味深いだけの知見しか得られない、という結果に陥りがちです。

プロジェクトを開始する前に、必ず以下の点を具体的に定義しましょう。

- 解決したいビジネス課題は何か?: (例:「若年層の顧客離れが進んでいる」「新商品の売上が伸び悩んでいる」)

- 分析によってどのような状態を実現したいか?: (例:「若年層の解約率を半年で10%削減する」「来月の売上を5%向上させるための具体的な施策を見つける」)

- 分析結果を誰がどのように活用するのか?: (例:「マーケティング部門が、分析結果に基づいたターゲットリストを作成し、キャンペーンを実施する」)

明確なゴールを設定することで、初めてどのようなデータが必要で、どの分析手法が適切か、という具体的な計画を立てることができます。

品質の高いデータを用意する

データマイニングの世界には「Garbage In, Garbage Out(ゴミを入れれば、ゴミしか出てこない)」という有名な格言があります。これは、どれほど高度な分析手法や高価なツールを使っても、元となるデータの品質が低ければ、得られる分析結果も全く信頼できない、という意味です。

質の高いデータとは、以下のような条件を満たすものです。

- 正確性: データの内容が事実と合っていること。

- 完全性: 必要なデータ項目が欠けていないこと(欠損値が少ないこと)。

- 一貫性: データの形式や単位、名称などが統一されていること。(例:「株式会社〇〇」と「(株)〇〇」のような表記揺れがない)

- 適時性: データが最新の状態に保たれていること。

実際のビジネス現場のデータは、これらの条件を満たしていないことがほとんどです。そのため、分析に着手する前の「データ準備(データプレパレーション)」の工程が極めて重要になります。異なるデータベースからのデータ統合、欠損値の補完、表記揺れの統一(名寄せ)、外れ値の処理といった地道な作業(データクレンジング)に、多大な労力を割く必要があります。この工程を疎かにすると、分析結果が誤った意思決定を導く原因となりかねません。

プライバシーとセキュリティに配慮する

データマイニングでは、顧客の個人情報を含む機密性の高いデータを扱うことが多くあります。そのため、プライバシー保護と情報セキュリティには最大限の注意を払わなければなりません。

- 法令遵守: 個人情報保護法などの関連法規を正しく理解し、遵守することが大前提です。個人情報を本人の同意なく目的外に利用したり、第三者に提供したりすることは固く禁じられています。

- 匿名化・仮名化: 分析を行う際には、可能な限り個人を特定できないようにデータを加工する「匿名化」や「仮名化」の措置を講じるべきです。氏名や住所、電話番号といった直接的な個人情報だけでなく、複数の情報を組み合わせることで個人が特定できてしまう可能性(プロファイリング)にも配慮が必要です。

- セキュリティ対策: データが保管されているサーバーやシステムへの不正アクセス、データの持ち出し、情報漏洩などを防ぐための厳格なセキュリティ対策(アクセス制御、暗号化、監視など)を徹底する必要があります。

万が一、情報漏洩やプライバシー侵害の事案が発生した場合、企業は法的な罰則を受けるだけでなく、社会的な信用を失い、事業の存続に関わるほどの深刻なダメージを被る可能性があります。データ活用という「攻め」の側面だけでなく、プライバシーとセキュリティという「守り」の側面にも万全を期すことが、持続可能なデータ活用の絶対条件です。

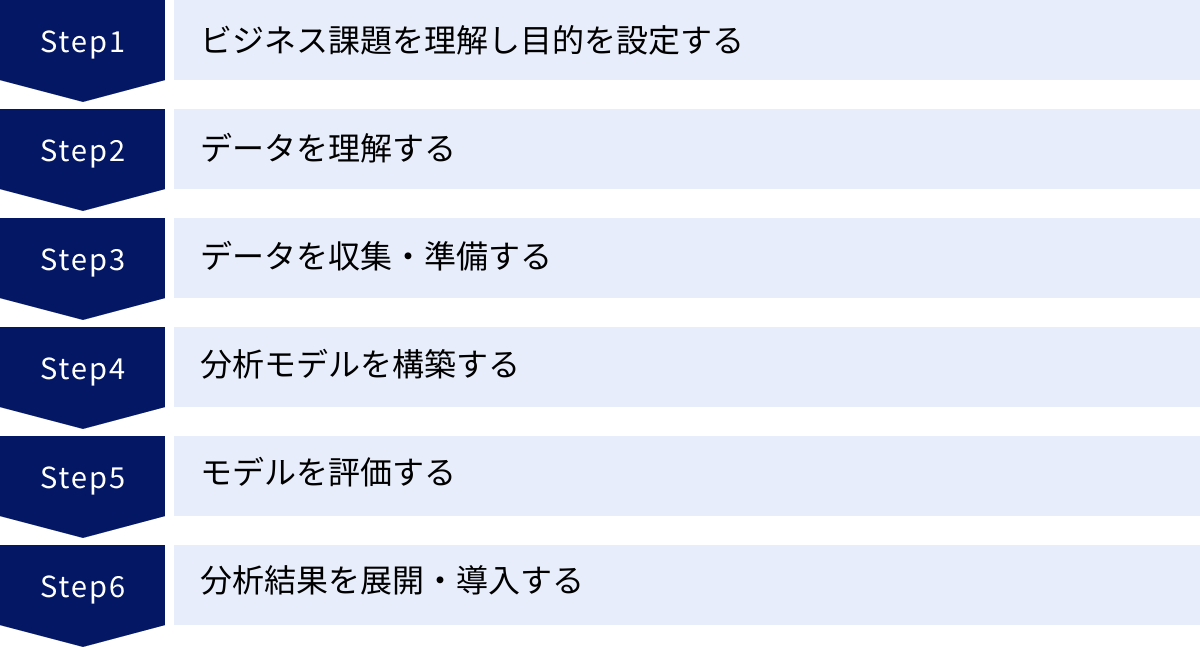

データマイニングの進め方6ステップ

データマイニングを成功させるためには、場当たり的に分析を行うのではなく、体系化されたプロセスに沿ってプロジェクトを進めることが重要です。ここでは、業界標準のプロセスモデルとして広く知られている「CRISP-DM(Cross-Industry Standard Process for Data Mining)」を参考に、データマイニングの一般的な進め方を6つのステップに分けて解説します。

ビジネス課題を理解し目的を設定する

すべての出発点は、ビジネスの文脈を深く理解することです。この最初のステップでは、技術的な側面から離れ、純粋にビジネス上の課題と向き合います。

- 課題の特定: まず、プロジェクトで解決したいビジネス上の課題は何かを明確にします。例えば、「顧客の解約率が高い」「特定の商品の在庫ロスが多い」「マーケティングキャンペーンの費用対効果が低い」といった具体的な問題点を挙げます。

- 目的の設定: 次に、その課題を解決するために、データマイニングによって何を達成したいのか、という具体的な目標(ゴール)を設定します。「来期末までに解約率を5%低下させるための解約予備軍リストを作成する」「需要予測の精度を20%向上させ、在庫ロスを半減させる」など、測定可能で達成可能な目標(SMARTゴール)を立てることが重要です。

- 成功基準の定義: プロジェクトが成功したかどうかを判断するための基準を定義します。これは、分析モデルの技術的な評価指標(例:予測精度90%以上)だけでなく、ビジネス上の成果(例:売上10%向上、コスト5%削減)も含まれます。

このステップには、データサイエンティストだけでなく、経営層や現場の業務担当者も積極的に関わる必要があります。ビジネス側と分析側が共通の理解と目標を持つことが、プロジェクトが迷走するのを防ぎ、最終的な成果をビジネス価値に結びつけるための鍵となります。

データを理解する

目的が明確になったら、次は分析の材料となる「データ」そのものに焦点を移します。このステップでは、本格的なデータ収集や加工の前に、どのようなデータが利用可能で、そのデータがどのような特性を持っているかを把握します。

- 初期データ収集: 関連する可能性のあるデータソースをリストアップし、少量のサンプルデータを収集します。社内のデータベース、CRMシステム、Webアクセスログ、外部から購入するデータなどが対象となります。

- データの記述: 収集したデータの基本的な特性を調べます。各データ項目(カラム)の意味、データの形式(数値、テキスト、日付など)、データ量(レコード数)、データの範囲などを文書化します。

- データの探索: グラフ化(可視化)や基本的な統計量の算出(平均、中央値、標準偏差など)を行い、データの分布や項目間の相関関係、外れ値や欠損値の存在などを視覚的・統計的に確認します。この探索的データ分析(EDA: Exploratory Data Analysis)を通じて、データに対する直感的な理解を深め、後の分析方針のヒントを得ます。

- データ品質の評価: データの正確性、完全性、一貫性などを評価し、品質に関する問題点を洗い出します。表記の揺れや異常な値、大量の欠損などがあれば、次の「データ準備」ステップで対処すべき課題として記録します。

データを収集・準備する

このステップは、データ分析プロジェクト全体の中で最も時間と労力がかかると言われる、極めて重要な工程です。質の低いデータからは質の低い結果しか生まれないため、丁寧な作業が求められます。一般に「データ前処理」や「データプレパレーション」と呼ばれます。

- データ選択: 分析目的に基づき、実際に分析に使用するデータセットを正式に選択します。

- データクレンジング: データの品質を向上させるための作業です。欠損値を適切な値で補完したり、異常な値(外れ値)を修正または除去したり、矛盾したデータを修正したりします。

- データ統合: 複数の異なるデータソース(例:顧客データベースと購買履歴データベース)を、顧客IDなどをキーにして一つに結合します。

- データ加工(特徴量エンジニアリング): 分析モデルが学習しやすいように、既存のデータから新しい特徴量(説明変数)を作成します。例えば、「生年月日」データから「年齢」を計算したり、複数の購買履歴から「月間平均購入額」を算出したりする作業が含まれます。この特徴量エンジニアリングの巧拙が、最終的なモデルの精度を大きく左右します。

- データフォーマット: 使用する分析ツールが要求する形式にデータを変換します。

分析モデルを構築する(モデリング)

質の高いデータが準備できたら、いよいよ分析の中核であるモデル構築のフェーズに入ります。

- 分析手法の選択: プロジェクトの目的(予測、分類、クラスタリングなど)とデータの特性に応じて、適切な分析手法(アルゴリズム)を選択します。例えば、顧客の解約を予測するならクラス分類分析(決定木、ロジスティック回帰など)、売上高を予測するなら回帰分析(線形回帰など)が候補となります。多くの場合、複数の手法を試して比較検討します。

- モデルの学習: 準備したデータを学習用データとテスト用データに分割します。学習用データを用いて、選択したアルゴリズムにデータのパターンを学習させ、予測モデルを構築します。この際、アルゴリズムの挙動を調整する「ハイパーパラメータ」を最適化する作業も行います。

- モデルの生成: 学習プロセスを経て、具体的な予測式や分類ルールを持つ分析モデルが生成されます。

モデルを評価する

構築したモデルが、ビジネスの目的を達成する上で本当に有用かどうかを客観的に評価します。

- 技術的評価: モデルの性能を技術的な指標で評価します。学習時に使用しなかったテスト用データを使って、モデルの予測がどの程度正しいかを確認します。

- クラス分類モデルの場合: 正解率、適合率、再現率、F値など

- 回帰モデルの場合: 平均二乗誤差(RMSE)、決定係数(R^2)など

- ビジネス的評価: モデルの評価結果が、ステップ1で設定したビジネス上の成功基準を満たしているかを確認します。例えば、「解約予測モデルの精度は95%」という技術的評価だけでなく、「このモデルを使えば、解約者を特定するためのコストを年間1,000万円削減できる」といったビジネスインパクトの観点からも評価します。

- レビュー: 評価結果をビジネス担当者と共有し、モデルがビジネスロジックに照らして妥当か、解釈可能かなどをレビューします。もし評価が不十分であれば、前のステップ(ビジネス理解、データ準備、モデリング)に戻って、アプローチを再検討します。このサイクルを繰り返すことで、モデルの品質を高めていきます。

分析結果を展開・導入する

モデルの評価が完了し、その有用性が確認されたら、分析結果を実際の業務に組み込み、活用する最終ステップに入ります。

- 展開計画の策定: モデルをどのように実業務のシステムやプロセスに統合するかの計画を立てます。リアルタイムで予測結果を返すAPIとして提供するのか、定期的にバッチ処理で予測リストを作成するのかなどを決定します。

- 導入(デプロイ): 計画に基づき、モデルを本番環境に実装します。

- モニタリングとメンテナンス: モデルを導入して終わりではありません。市場環境や顧客の行動は常に変化するため、モデルの予測精度は時間とともに劣化していく可能性があります。そのため、本番環境でのモデルの性能を継続的に監視(モニタリング)し、精度が低下してきたら、新しいデータを使ってモデルを再学習させたり、モデル自体を更新したりするメンテナンス作業が不可欠です。

- 最終レポートとレビュー: プロジェクト全体のプロセス、得られた知見、成果、今後の課題などをまとめた最終レポートを作成し、関係者で共有してプロジェクトを締めくくります。

この6つのステップは、一度きりの直線的なプロセスではなく、必要に応じて前のステップに戻りながら進める反復的なサイクルであることが、CRISP-DMの重要な特徴です。

データマイニングに役立つおすすめツール5選

データマイニングを実践するには、強力なツールが欠かせません。プログラミング不要で直感的に操作できるGUIベースのツールから、高い自由度と拡張性を誇るプログラミング言語まで、様々な選択肢があります。ここでは、世界中で広く利用されている代表的なツールを5つ紹介します。

RapidMiner

RapidMinerは、プログラミングの知識がなくても、GUI(グラフィカル・ユーザー・インターフェース)上で直感的な操作ができるデータマイニングプラットフォームです。

データの前処理から機械学習モデルの構築、評価、運用まで、データサイエンスのライフサイクル全体をエンドツーエンドでサポートします。「オペレーター」と呼ばれる機能ブロック(データの読み込み、加工、モデリングなど)をドラッグ&ドロップで繋ぎ合わせていくだけで、分析のフローを構築できます。

豊富なアルゴリズムを標準で搭載しており、複雑な分析もコーディングなしで実行可能です。AutoML(自動機械学習)機能も充実しており、最適なモデルを自動で探索・構築してくれます。

無料版や教育機関向けライセンスも提供されており、初心者や学生がデータマイニングを学ぶためのツールとしても人気が高いです。(参照:RapidMiner 公式サイト)

IBM SPSS Modeler

IBM SPSS Modelerは、統計解析ソフトウェアとして長い歴史と実績を持つSPSSシリーズのデータマイニングツールです。

RapidMinerと同様に、分析のプロセスをアイコンで視覚的に表現する「ストリーム」というインターフェースが特徴で、プログラミングスキルがなくても高度な分析が可能です。特に、統計学に基づいた多様なアルゴリズムが強みで、金融、マーケティング、医療など、幅広い業種で導入されています。

テキストマイニング機能も強力で、アンケートの自由回答やSNSの投稿といったテキストデータから有益な知見を抽出する分析も得意としています。長年の実績に裏打ちされた信頼性と、手厚いサポート体制も大企業にとっては魅力的なポイントです。(参照:日本アイ・ビー・エム株式会社 公式サイト)

KNIME Analytics Platform

KNIME(ナイム) Analytics Platformは、オープンソースで無償利用できるデータマイニングツールです。

こちらもGUIベースのツールで、「ノード」と呼ばれる機能コンポーネントを線で結んでワークフローを構築します。オープンソースであるため、世界中のコミュニティによって開発された数千もの拡張機能(ノード)を追加でき、非常に高いカスタマイズ性と拡張性を誇ります。

PythonやR、Javaなど他のプログラミング言語との連携も容易で、既存のコード資産を活かしながら、GUIの利便性も享受できます。無償でありながら商用ツールに匹敵するほどの高機能を備えており、コストを抑えてデータ分析を始めたい企業や、個人、学術研究者などに広く利用されています。(参照:KNIME AG 公式サイト)

| ツール名 | 特徴 | メリット | デメリット | こんな人・企業におすすめ |

|---|---|---|---|---|

| RapidMiner | GUIベースの統合プラットフォーム | プログラミング不要、AutoML機能が強力 | 商用版は高価な場合がある | データ分析専門家がいない企業、迅速にPoCを進めたいチーム |

| IBM SPSS Modeler | 統計解析の老舗ツール | 信頼性と実績、手厚いサポート | ライセンス費用が高額 | 大企業、金融・研究機関、既存のSPSSユーザー |

| KNIME | オープンソースのGUIツール | 無料で高機能、拡張性が非常に高い | 日本語の情報が比較的少ない、サポートはコミュニティベース | コストを抑えたい企業・個人、カスタマイズ性を重視する開発者 |

Python

Pythonは、現在、データサイエンスと機械学習の分野で最も広く使われている汎用プログラミング言語です。

その最大の強みは、Pandas(データ操作)、NumPy(数値計算)、Matplotlib/Seaborn(可視化)、scikit-learn(機械学習)、TensorFlow/PyTorch(ディープラーニング)といった、データ分析のための強力で豊富なライブラリ(エコシステム)が存在することです。

これらのライブラリを組み合わせることで、単純なデータ集計から最先端のディープラーニングモデルの実装まで、あらゆるデータマイニングタスクを極めて柔軟に実行できます。GUIツールと比べて学習コストは高いですが、処理の自動化やWebアプリケーションへの組み込みなど、分析後の展開まで見据えた場合に圧倒的な自由度を誇ります。オープンソースであり、世界中に膨大な情報やコミュニティが存在するため、学習リソースにも事欠きません。

本格的にデータサイエンスをキャリアにしたい個人や、内製で高度な分析システムを構築したい企業にとって、Pythonは事実上の標準(デファクトスタンダード)と言えるでしょう。

R

Rは、統計解析とデータ可視化に特化したオープンソースのプログラミング言語および実行環境です。

もともと学術研究の世界で開発された経緯から、統計モデリングに関する機能が非常に充実しており、最新の統計分析手法がいち早くパッケージ(ライブラリ)として実装される傾向があります。ggplot2というライブラリを使えば、美しく洗練されたグラフを柔軟に作成できる点も大きな魅力です。

Pythonが汎用的な言語であるのに対し、Rはデータ分析という特定の目的に特化しています。そのため、統計家やデータアナリストにとっては、Pythonよりも簡潔なコードで分析を実行できる場面も多くあります。

アカデミックな分野では依然として根強い人気を誇っており、統計的な厳密さを重視する研究者や、高度な統計モデルを駆使した分析を行いたい専門家には、Rが有力な選択肢となります。

まとめ

本記事では、データマイニングの基本概念から、AIや機械学習との違い、注目される背景、具体的な手法、ビジネスでの活用方法、導入のメリット・デメリット、そして実践的な進め方とツールに至るまで、包括的に解説してきました。

データマイニングとは、単なるツールの操作や技術論ではありません。それは、企業が保有する膨大な「データ」という資産の中から、これまで気づかなかった「価値ある知見」を掘り起こし、それを日々の意思決定や戦略立案に活かしていくための一連のプロセスであり、文化です。

勘や経験だけに頼る時代は終わりを告げ、データに基づいた客観的な意思決定、すなわちデータドリブンな経営が、あらゆる業界で競争優位性を築くための鍵となっています。データマイニングを導入することで、企業は以下のような大きな変革を実現できます。

- 業務の効率化と生産性の向上

- パーソナライゼーションによる顧客満足度の向上

- 未知の市場やニーズの発見による新たなビジネスチャンスの創出

しかし、その導入は決して簡単な道のりではありません。専門知識を持つ人材の確保、導入・運用にかかるコスト、そして分析の目的設定の重要性や、データ品質の確保、プライバシーへの配慮といった課題にも真摯に向き合う必要があります。

成功への近道は、「ビジネス課題の理解」という原点から始め、明確な目的意識を持ってスモールスタートすることです。CRISP-DMのような体系化されたプロセスに沿って、まずは特定の課題に絞ってデータマイニングを適用し、小さな成功体験(クイックウィン)を積み重ねていくことが、全社的なデータ活用文化を根付かせるための最も確実な一歩となるでしょう。

この記事が、皆様の組織におけるデータ活用の旅を始める、あるいはさらに加速させるための一助となれば幸いです。データという羅針盤を手に、新たな価値創造の航海へと乗り出してみてはいかがでしょうか。