現代のITシステム開発において、「コンテナ技術」という言葉を耳にする機会が急速に増えています。DockerやKubernetesといったツール名と共に語られるこの技術は、アプリケーションの開発、デプロイ、運用のあり方を根本から変える力を持っており、多くの企業で採用が進んでいます。

しかし、「コンテナとは具体的に何なのか?」「よく聞く仮想マシンとは何が違うのか?」「導入するとどんな良いことがあるのか?」といった疑問をお持ちの方も少なくないでしょう。特に、これまで伝統的な開発手法に慣れ親しんできた方にとっては、少し敷居が高く感じられるかもしれません。

この記事では、コンテナ技術の基本から、その仕組み、仮想マシンとの違い、導入のメリット・デメリット、そして具体的な活用シーンまで、専門的な内容を初心者にも分かりやすく、網羅的に解説します。コンテナ技術は、アプリケーション開発の効率化、インフラコストの削減、そして迅速なサービス提供を実現するための重要な基盤技術です。

本記事を最後までお読みいただくことで、コンテナ技術の全体像を体系的に理解し、なぜ今これほどまでに注目されているのか、その理由を深く納得できるようになるでしょう。

目次

コンテナ技術とは

コンテナ技術とは、一言で言うと「アプリケーションを、その実行に必要な設定やライブラリなどの依存関係とまとめて一つのパッケージにし、あらゆるコンピューティング環境で迅速かつ確実に実行するための仮想化技術」です。

この技術の核心は「OSレベルの仮想化」という仕組みにあり、アプリケーションをホストとなるOSやインフラストラクチャから隔離された独立した空間(コンテナ)で動かすことを可能にします。

少しイメージがしにくいかもしれませんので、引越しの荷造りに例えてみましょう。

従来のアプリケーション開発では、開発者のPC、テスト用のサーバー、本番環境のサーバーなど、場所ごとに環境が微妙に異なりました。これは、引越しの際に家具(アプリケーション)だけを新居に運び込んでも、部屋のサイズやコンセントの位置(OSのバージョンやライブラリ)が違うため、うまく配置できない状況に似ています。開発者のPCでは動いたのに、本番サーバーでは動かない、という「環境差異」の問題は、多くの開発者を悩ませてきました。

一方、コンテナ技術は、この問題を解決するために、アプリケーションとその実行に必要なものすべて(ライブラリ、設定ファイル、環境変数など)を、一つの「コンテナ」という標準化された箱に詰めてしまいます。この箱さえあれば、引越し先がどんな部屋(物理サーバー、仮想マシン、クラウド環境)であっても、箱を開けるだけで中身を全く同じ状態で再現できるのです。

この「どこでも同じように動く」という特性は、コンテナ技術が持つ多くのメリットの根源となっています。

技術的な側面から見ると、コンテナは従来の仮想マシン(VM)とは異なるアプローチを取ります。仮想マシンが物理的なハードウェアを仮想化し、その上で完全なOS(ゲストOS)を丸ごと動かすのに対し、コンテナはホストOSが持つカーネル(OSの中核部分)を複数のコンテナで共有します。各コンテナはゲストOSを持つ必要がなく、アプリケーションとその依存関係のみを含むため、非常に軽量で高速に起動・動作します。

実は、コンテナという考え方自体は新しいものではなく、古くはLinuxのchrootやFreeBSDのJails、SolarisのContainersといった技術が存在しました。しかし、これらの技術は専門的な知識が必要で、広く使われるには至りませんでした。

この状況を一変させたのが、2013年に登場した「Docker」です。Dockerは、これらの複雑な技術を使いやすく抽象化し、Dockerfileという設定ファイルやDocker Hubというイメージ共有の仕組みを提供することで、コンテナの作成、共有、実行を劇的に簡単にしました。Dockerの登場により、コンテナ技術は爆発的に普及し、現在ではアプリケーション開発のデファクトスタンダード(事実上の標準)となりつつあります。

まとめると、コンテナ技術は、アプリケーションを環境から切り離してパッケージ化することで、「一度作れば、どこでも動く(Build once, run anywhere)」という理想を実現する、軽量かつ高速な仮想化技術であると言えます。この技術が、現代の迅速なソフトウェア開発と安定した運用を支える重要な役割を担っているのです。

コンテナ技術の仕組みと必要とされる背景

コンテナ技術がなぜこれほどまでに広く受け入れられるようになったのでしょうか。その理由を理解するためには、まずコンテナが登場する以前の、従来の開発・運用が抱えていた課題を知る必要があります。そして、コンテナがその課題をどのような仕組みで解決するのかを詳しく見ていきましょう。

従来の開発・運用における課題

コンテナ技術が普及する前、アプリケーションの開発と運用現場では、主に以下のような根深い課題が存在していました。

1. 「私の環境では動くのに」問題(環境差異)

これは、開発・運用における最も古典的かつ深刻な問題の一つです。開発者は自身のPC(ローカル環境)でアプリケーションを開発し、動作確認を行います。しかし、そのアプリケーションをテスト環境やステージング環境、そして最終的な本番環境へ移行させると、なぜかうまく動かないという事態が頻発しました。

原因は、それぞれの環境におけるOSのバージョン、インストールされているライブラリやミドルウェアのバージョンの微妙な違い、あるいは設定ファイルの差異など、多岐にわたります。この環境差異に起因する問題の調査と修正には多くの時間が費やされ、開発サイクルの遅延やデプロイ作業の大きなリスクとなっていました。

2. 複雑で時間のかかる環境構築

新しいメンバーがプロジェクトに参加するたびに、その人のPCに開発環境を構築する作業は非常に煩雑でした。OSのセットアップから始まり、特定のバージョンのプログラミング言語、データベース、各種ライブラリなどを手順書に従ってインストールしていく必要があります。

しかし、手順書が古くなっていたり、個人のPC環境に依存する予期せぬエラーが発生したりと、環境が整うまでに数日を要することも珍しくありませんでした。この非生産的な時間は、プロジェクト全体の生産性を著しく低下させる要因となっていました。

3. サーバーリソースの非効率な利用

1台の物理サーバー上で複数のアプリケーションを動かす場合、アプリケーション同士が依存するライブラリのバージョンが競合する(例:アプリAはライブラリXのバージョン1.0を、アプリBはバージョン2.0を必要とする)といった問題を防ぐため、アプリケーションごとに物理サーバーを分ける構成が取られることがありました。

その後、仮想化技術の登場により、1台の物理サーバー上に複数の仮想マシン(VM)を立て、VMごとにアプリケーションを分離する方法が主流となりました。これによりサーバーの集約率は向上しましたが、各VMは完全なOSを内包しているため、OS自体が消費するCPUやメモリ、ディスク容量のオーバーヘッドが大きく、依然としてリソースの無駄が生じていました。

これらの課題は、アプリケーションを迅速に開発し、安定的にユーザーへ届けたいというビジネスの要求に対する大きな足かせとなっていました。コンテナ技術は、まさにこれらの課題を解決するために登場したのです。

コンテナはどのようにアプリケーションを実行するのか

コンテナ技術は、前述の課題を「OSレベルの仮想化」という巧みな仕組みで解決します。これは、仮想マシンがハードウェア全体をエミュレートする「ハードウェア仮想化」とは根本的に異なります。

コンテナ技術の中核を担うのは、ホストOS、特にLinuxカーネルが持つ以下の2つの機能です。

1. Namespace(名前空間)

Namespaceは、システムリソースを論理的に分割し、各コンテナにあたかも独立したOS環境が与えられているかのように見せかける技術です。具体的には、以下のようなリソースがコンテナごとに分離されます。

- PID Namespace: プロセスIDを分離します。コンテナ内で実行される最初のプロセスはPID 1となり、そのコンテナは自分自身のプロセスツリーしか認識できません。ホストOSや他のコンテナのプロセスを見ることはできません。

- Network Namespace: ネットワークインターフェース、IPアドレス、ルーティングテーブルなどを分離します。これにより、各コンテナは独自のIPアドレスを持つことができ、ポート番号の衝突を気にすることなくアプリケーションを起動できます。

- Mount Namespace: ファイルシステムのマウントポイントを分離します。コンテナは自分専用のルートファイルシステムを持ち、他のコンテナやホストOSのファイルシステムから隔離されます。

- UTS Namespace: ホスト名やドメイン名を分離します。

- IPC Namespace: プロセス間通信(IPC)リソースを分離します。

- User Namespace: ユーザーIDとグループIDを分離し、コンテナ内のrootユーザーがホストOSのrootユーザーと同じ権限を持たないようにすることができます。

これらのNamespace機能によって、同じホストOS上で動作していながら、各コンテナは互いに干渉することなく、完全に隔離された実行環境として振る舞うことができます。

2. Cgroups(Control Groups)

Cgroupsは、コンテナが使用できるコンピュータリソース(CPU、メモリ、ディスクI/O、ネットワーク帯域など)を制限・管理するための機能です。

例えば、「このコンテナはCPUコアの50%まで、メモリは1GBまでしか使用できない」といった制限をかけることができます。これにより、特定のコンテナがリソースを使い果たしてしまい、他のコンテナやホストOS全体のパフォーマンスに悪影響を及ぼす「ノイジーネイバー(騒々しい隣人)問題」を防ぎます。リソースを適切に分配することで、1台のサーバー上で多数のコンテナを安定して稼働させることが可能になります。

コンテナエンジンの役割

Dockerに代表される「コンテナエンジン」は、これらLinuxカーネルの複雑な機能をユーザーが意識することなく、簡単なコマンドで利用できるようにするためのソフトウェアです。ユーザーがdocker runといったコマンドを実行すると、コンテナエンジンがバックグラウンドでNamespaceやCgroupsを駆使してコンテナ環境を構築し、指定されたアプリケーションをその中で起動します。

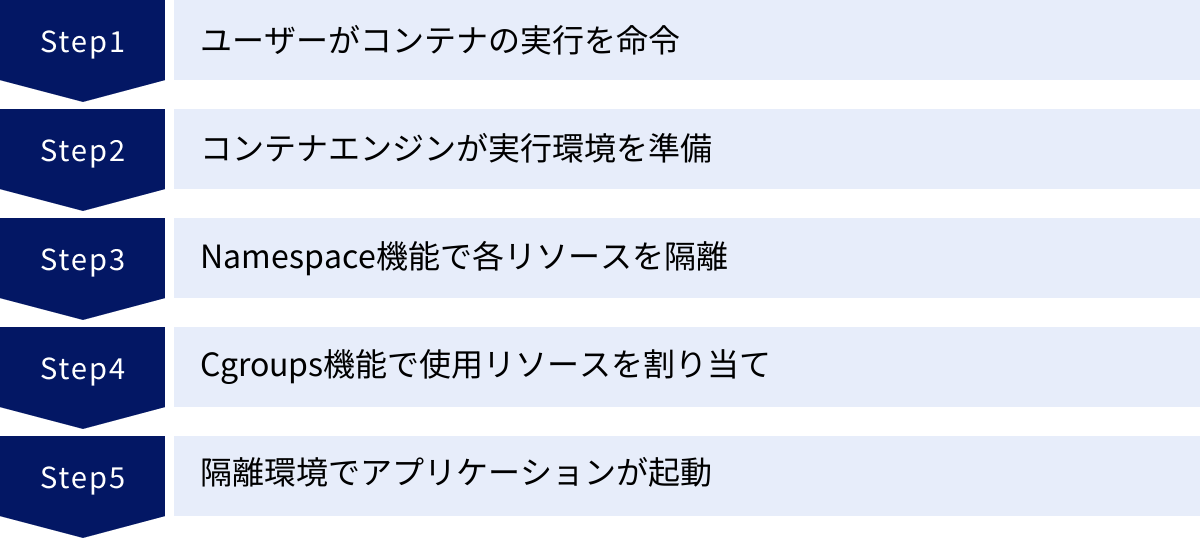

【コンテナの実行フロー】

- ユーザーがコンテナイメージ(後述)を指定して、コンテナの実行を命令します。

- コンテナエンジンは、指定されたイメージを元にコンテナの実行環境を準備します。

- Namespace機能を利用して、プロセス、ネットワーク、ファイルシステムなどをホストOSや他のコンテナから隔離します。

- Cgroups機能を利用して、そのコンテナが使用できるCPUやメモリなどのリソースを割り当てます。

- 隔離され、リソースが割り当てられた環境の中で、目的のアプリケーションがプロセスとして起動します。

このように、コンテナはホストOSのカーネルを共有することでオーバーヘッドを最小限に抑えつつ、NamespaceとCgroupsによってアプリケーションの実行環境を確実に分離するという、軽量さと分離性を両立した非常に効率的な仕組みで動作しているのです。

コンテナと仮想マシンの違い

コンテナ技術を学ぶ上で、必ずと言っていいほど比較対象となるのが「仮想マシン(Virtual Machine, VM)」です。どちらも1台の物理サーバー上で複数の独立した環境を動かすための仮想化技術ですが、その仕組みと特性は大きく異なります。両者の違いを正確に理解することは、コンテナ技術の本質を捉える上で非常に重要です。

構造の違い

コンテナと仮想マシンの最も根本的な違いは、仮想化を行うレイヤー(階層)にあります。

仮想マシン(VM)の構造

仮想マシンは「ハードウェア仮想化」というアプローチを取ります。物理サーバーの上には「ハイパーバイザー」と呼ばれるソフトウェア(例: VMware vSphere/ESXi, Microsoft Hyper-V, KVM)が動作します。ハイパーバイザーは、CPU、メモリ、ストレージといった物理的なハードウェアリソースを仮想化し、複数の仮想マシンに分割して提供します。

それぞれの仮想マシンは、仮想化されたハードウェアの上で、カーネルを含む完全なオペレーティングシステム(ゲストOS)を動作させます。つまり、1台の物理サーバー上に、Windows Serverや複数の異なるバージョンのLinuxディストリビューションなど、完全に独立したOS環境を複数同時に稼働させることができます。

- 階層構造: 物理サーバー → ホストOS(またはハイパーバイザー) → ハイパーバイザー → ゲストOS → ライブラリ/ミドルウェア → アプリケーション

コンテナの構造

一方、コンテナは「OSレベルの仮想化」というアプローチです。物理サーバー(または仮想マシン)の上にホストOSが動作し、その上に「コンテナエンジン」(例: Docker)がインストールされます。

コンテナはハイパーバイザーやゲストOSを持ちません。代わりに、すべてのコンテナがホストOSのカーネルを共有します。コンテナエンジンは、前述のNamespaceやCgroupsといったホストOSの機能を利用して、アプリケーションの実行環境をプロセスレベルで分離します。コンテナに含まれるのは、アプリケーション本体と、その実行に必要なライブラリや設定ファイルのみです。

- 階層構造: 物理サーバー → ホストOS → コンテナエンジン → ライブラリ/ミドルウェア → アプリケーション

この「ゲストOSの有無」が、両者の特性を決定づける最も大きな違いと言えます。

リソース効率とパフォーマンスの違い

構造の違いは、リソースの消費量や処理性能に直接的な影響を与えます。

リソース効率(サイズと集約率)

- 仮想マシン: 各VMがゲストOSを丸ごと内包しているため、OSだけで数GB以上のディスク容量と、数百MBから数GBのメモリを消費します。このオーバーヘッドが大きいため、1台の物理サーバー上で稼働させられるVMの数には限りがあります。

- コンテナ: ゲストOSを持たず、アプリケーションと必要最低限の依存ファイルのみを含むため、イメージサイズは数MBから数百MB程度と非常に軽量です。OS分のオーバーヘッドがないため、同じスペックのサーバーであれば、仮想マシンよりもはるかに多くのコンテナを高密度に集約して実行できます。これにより、サーバーリソースを無駄なく活用でき、インフラコストの削減に繋がります。

パフォーマンス(起動速度)

- 仮想マシン: VMを起動するには、まず仮想ハードウェアの初期化が行われ、次にゲストOSがゼロからブートプロセスを実行する必要があります。これには通常、数分単位の時間がかかります。

- コンテナ: コンテナの起動は、ホストOS上で新しいプロセスを開始するのとほぼ同じです。OSのブートプロセスが不要なため、起動にかかる時間はわずか数秒、場合によっては1秒未満です。この驚異的な起動速度は、開発のテストサイクルを短縮したり、アクセス急増時に迅速にスケールアウト(サーバー数を増やすこと)したりする上で大きな利点となります。

この構造、リソース効率、パフォーマンスの違いから、コンテナと仮想マシンはそれぞれ得意な領域が異なります。強力な分離性が必要な場合や、ホストOSとは異なる種類のOSを動かしたい場合は仮想マシンが適しています。一方、アプリケーションを軽量かつ高速に、環境に依存せず動かしたい場合にはコンテナが最適です。両者は競合するだけでなく、仮想マシン上でコンテナを動かすなど、組み合わせて利用されることも多くあります。

比較一覧表

コンテナと仮想マシンの違いを以下の表にまとめます。

| 項目 | コンテナ | 仮想マシン(VM) |

|---|---|---|

| 仮想化レベル | OSレベル仮想化 | ハードウェア仮想化 |

| 分離の単位 | アプリケーションとプロセス | オペレーティングシステム(OS) |

| ゲストOS | 不要(ホストOSのカーネルを共有) | 必要(各VMが独自のOSを持つ) |

| サイズ | 軽量(数MB〜数百MB) | 重量(数GB〜数十GB) |

| 起動速度 | 高速(数秒) | 低速(数分) |

| オーバーヘッド | 小さい | 大きい |

| リソース効率 | 高い | 低い |

| 分離性 | プロセスレベルで分離 | OSレベルで強力に分離 |

| 可搬性 | 非常に高い(コンテナエンジンがあればどこでも動く) | 比較的低い(ハイパーバイザーに依存する場合がある) |

| 主な用途 | アプリケーションのパッケージ化、マイクロサービス | 異なるOS環境の提供、レガシーシステムの移行 |

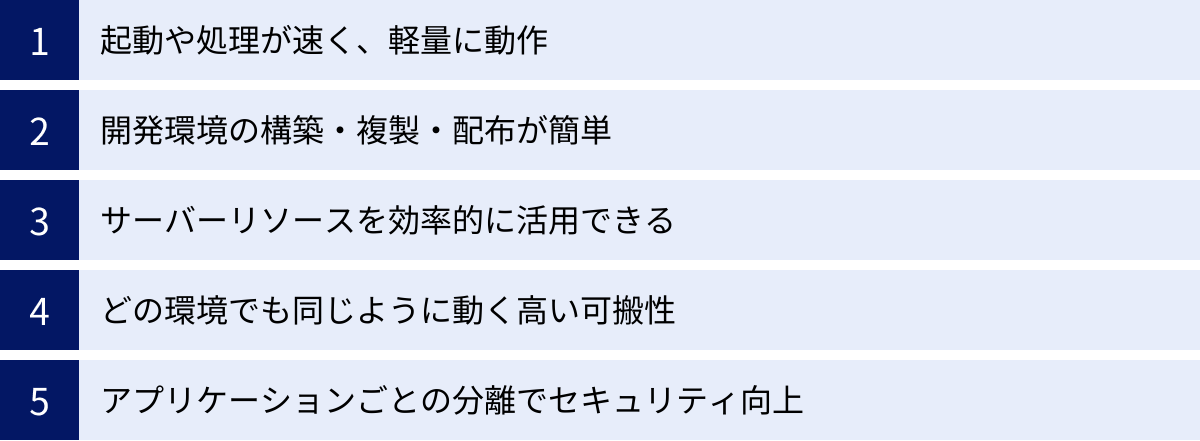

コンテナ技術を導入する5つのメリット

コンテナ技術がなぜこれほどまでに注目され、多くの開発現場で採用されているのでしょうか。その理由は、開発から運用までのソフトウェアライフサイクル全体にわたって、数多くの強力なメリットをもたらすからです。ここでは、特に重要な5つのメリットについて詳しく解説します。

① 起動や処理が速く、軽量に動作する

コンテナ技術の最も直接的で体感しやすいメリットは、その圧倒的なパフォーマンスです。前述の通り、コンテナはゲストOSを持たず、ホストOS上で単なるプロセスとして起動するため、仮想マシンとは比較にならないほどの高速性と軽量性を実現します。

高速な起動・停止

コンテナの起動は、OSのブートプロセスを伴わないため、数秒、あるいはミリ秒単位で完了します。この速度は、さまざまな場面で効果を発揮します。

- 開発効率の向上: プログラマーがコードを修正した後、すぐにアプリケーションを起動して動作確認ができます。待機時間がほとんどなくなるため、思考を中断することなく、スムーズに開発を進められます。

- 迅速なスケーリング: Webサイトへのアクセスが急増した際、コンテナを瞬時に追加して処理能力を高める「スケールアウト」が可能です。これにより、ユーザーを待たせることなく、快適なサービスを提供し続けられます。

- CI/CDの高速化: アプリケーションのビルドやテストのたびに、使い捨てのテスト環境をコンテナで一瞬で構築・破棄できます。これにより、開発パイプライン全体の所要時間を大幅に短縮できます。

軽量性と高集約性

コンテナイメージは、アプリケーションと必要最低限のライブラリのみを含むため、サイズが非常に小さいという特徴があります。これにより、以下のようなメリットが生まれます。

- リソース効率の最大化: OSのオーバーヘッドがないため、1台のサーバーにより多くのコンテナを配置(高密度に集約)できます。これは、物理サーバーの台数を削減し、ハードウェアコスト、データセンターの設置費用、電力消費量といったインフラコストの直接的な削減に繋がります。

- イメージ転送の高速化: 開発者のPCからテスト環境へ、あるいはコンテナレジストリ(イメージの保管庫)から本番サーバーへとイメージを転送する際の時間が短縮されます。デプロイ作業が迅速になり、サービスリリースのリードタイム短縮に貢献します。

この軽量・高速という基本特性が、コンテナ技術がもたらす他の多くのメリットの土台となっています。

② 開発環境の構築・複製・配布が簡単

従来の開発現場を悩ませてきた「私の環境では動くのに」という環境差異の問題は、コンテナ技術によって劇的に改善されます。コンテナは、アプリケーションの実行環境そのものをパッケージ化して持ち運ぶという発想に基づいているためです。

環境のコード化(Infrastructure as Code)

Dockerなどのツールでは、「Dockerfile」というテキストファイルに、ベースとなるOSイメージ、必要なソフトウェアのインストール、設定ファイルのコピー、アプリケーションの起動コマンドといった、環境構築の手順をコードとして記述します。

このDockerfileさえあれば、誰が実行しても、いつ実行しても、全く同じコンテナイメージ(実行環境)を再現できます。これにより、環境構築が属人化することなく、手順の間違いや漏れによるトラブルを防ぐことができます。

環境の複製と配布の容易さ

作成されたコンテナイメージは、チームメンバーや他の部署、協力会社などと簡単に共有できます。

- 新メンバーの迅速な立ち上がり: 新しくプロジェクトに参加した開発者は、GitリポジトリからソースコードとDockerfileを取得し、簡単なコマンドを実行するだけで、数分後には開発に必要なすべてのコンポーネント(Webサーバー、アプリケーション、データベースなど)が揃った環境を手に入れることができます。環境構築に数日を費やす必要はもうありません。

- チーム内での環境統一: 開発チーム全員が同じコンテナイメージをベースに開発を行うことで、「開発者AのPCでは動くが、開発者BのPCでは動かない」といった環境差異に起因する不毛なバグ調査から解放されます。

- 本番環境との一貫性: 開発環境、テスト環境、本番環境で同じコンテナイメージを使用することで、環境間の差異を最小限に抑えられます。これにより、「テストでは問題なかったのに、本番にデプロイしたら動かない」という最悪の事態を未然に防ぎ、デプロイの成功率と信頼性を大幅に向上させることができます。

このように、コンテナは開発環境のポータビリティ(可搬性)と再現性を飛躍的に高め、開発プロセス全体の生産性を向上させます。

③ サーバーリソースを効率的に活用できる

コンテナの軽量性は、サーバーリソースの利用効率を最大化し、インフラコストの最適化に大きく貢献します。

前述の通り、コンテナはゲストOSのオーバーヘッドがないため、仮想マシンに比べてCPUやメモリの消費量が格段に少なくて済みます。これにより、1台の物理サーバーやクラウドのインスタンス上で、より多くのアプリケーションを同時に、そして安定して稼働させることが可能になります。

例えば、これまで10台の仮想マシンで運用していた10個のアプリケーションを、より少ない台数(例えば2〜3台)のサーバー上でコンテナとして集約できる可能性があります。これにより、以下のようなコスト削減効果が期待できます。

- ハードウェアコストの削減: 購入・維持する物理サーバーの台数が減ります。

- データセンターコストの削減: サーバーラックのスペース、電力、冷却にかかる費用が削減されます。

- クラウド利用料の削減: クラウド環境では、よりスペックの低い(安価な)インスタンスを選択したり、インスタンスの総数を減らしたりすることで、月々の利用料を抑えることができます。

- ソフトウェアライセンス料の削減: OSやミドルウェアのライセンス費用を削減できる場合があります。

さらに、Cgroupsの機能を使えば、コンテナごとに使用するリソース量(CPU、メモリ)の上限を細かく設定できます。これにより、重要度の高いアプリケーションには多くのリソースを割り当て、そうでないアプリケーションはリソースを制限するなど、ビジネスの優先度に応じた柔軟なリソース管理が実現します。リソースを無駄なく計画的に利用することで、投資対効果(ROI)を最大化できるのです。

④ どの環境でも同じように動く高い可搬性

コンテナの最も革命的なメリットの一つが、「一度ビルドすれば、どこでも実行できる(Build once, run anywhere)」という卓越した可搬性(ポータビリティ)です。

コンテナは、アプリケーションとその依存関係をすべて内包し、ホスト環境から隔離されているため、コンテナエンジンが動作する環境であれば、基本的にはどこでも全く同じように動作します。

- 開発者のノートPC(Windows, macOS, Linux)

- 社内のオンプレミスサーバー

- 主要なパブリッククラウド(Amazon Web Services (AWS), Microsoft Azure, Google Cloud Platform (GCP)など)

この高い可搬性は、企業に以下のような戦略的な柔軟性をもたらします。

- ハイブリッドクラウド/マルチクラウド戦略の推進: オンプレミスのデータセンターとパブリッククラウドを連携させるハイブリッドクラウドや、複数の異なるクラウドサービスを併用するマルチクラウド環境の構築が容易になります。アプリケーションをコンテナ化しておくことで、ビジネス要件の変化に応じて、ある環境から別の環境へスムーズに移行・展開できます。

- クラウドロックインの回避: 特定のクラウドベンダーが提供する独自のサービスにアプリケーションが強く依存してしまう「ベンダーロックイン」は、多くの企業にとって懸念事項です。コンテナという標準化されたプラットフォーム上でアプリケーションを構築することで、特定のベンダーへの依存度を下げ、将来的に他のクラウドへ移行する際の選択肢と交渉力を確保できます。

コンテナは、インフラという土台からアプリケーションを切り離し、ビジネスロジックそのものを自由に持ち運ぶことを可能にする技術なのです。

⑤ アプリケーションごとの分離によるセキュリティ向上

コンテナは、Namespace機能によって各コンテナが隔離された環境で実行されるため、セキュリティの向上にも寄与します。

影響範囲の限定(コンテインメント)

コンテナは、それぞれが独立したプロセス空間、ファイルシステム、ネットワーク空間を持っています。これにより、万が一あるコンテナ上で動作するアプリケーションに脆弱性があり、攻撃者によって侵害されたとしても、その影響をそのコンテナ内に封じ込める(Contain)ことができます。攻撃者がコンテナから脱出してホストOSや他のコンテナに侵入することは非常に困難であり、被害の拡大を防ぐ防壁として機能します。

イミュータブル・インフラストラクチャの実践

コンテナ運用では、「イミュータブル(不変)なインフラ」という考え方が推奨されます。これは、一度デプロイした稼働中のコンテナには変更を加えず、セキュリティパッチの適用や設定変更が必要になった場合は、修正済みの新しいコンテナイメージをビルドし、古いコンテナと丸ごと入れ替えるという運用方法です。

このアプローチには、以下のようなセキュリティ上の利点があります。

- 設定ドリフトの防止: 稼働中のサーバーに手動で変更を加えることによる、意図しない設定変更(設定ドリフト)や構成の不整合を防ぎ、常にクリーンで定義通りの状態を維持できます。

- 迅速な脆弱性対応: 脆弱性が発見された場合、パッチを適用したベースイメージを使って再ビルドし、デプロイするだけで、システム全体を安全な状態に更新できます。

攻撃対象領域の最小化

コンテナイメージを作成する際は、アプリケーションの実行に必要最低限のライブラリやツールのみを含めることがベストプラクティスとされています。不要なパッケージやコマンドが含まれていないため、攻撃者に悪用される可能性のある脆弱なコンポーネントを減らし、攻撃対象領域(アタックサーフェス)を最小限に抑えることができます。

もちろん、コンテナ特有のセキュリティリスク(例: 安全でないイメージの使用、コンテナエンジンの脆弱性)も存在するため、適切な対策は必要ですが、正しく利用すれば、コンテナはアプリケーションのセキュリティレベルを一段階引き上げることができます。

コンテナ技術の2つのデメリット・注意点

コンテナ技術は多くのメリットをもたらしますが、万能の解決策というわけではありません。導入を検討する際には、そのデメリットや注意点も正しく理解しておくことが重要です。ここでは、コンテナ技術が抱える主な2つの課題について解説します。

① ホストOSと異なる種類のOSは動かせない

これは、コンテナ技術の仕組みに起因する最も根本的な制約です。コンテナは、仮想マシンのように独立したゲストOSを持つのではなく、ホストOSのカーネルを共有して動作します。このアーキテクチャは、軽量・高速という大きなメリットを生む一方で、OSの互換性という点で制約をもたらします。

具体的には、LinuxカーネルをベースにしたホストOS(Ubuntu, CentOS, Amazon Linuxなど)上では、Linuxベースのコンテナしか実行できません。同様に、Windows ServerをホストOSとする環境では、Windowsベースのコンテナしか実行できません。つまり、Linuxサーバー上でWindowsアプリケーションをコンテナとして動かしたり、その逆を行ったりすることは、原則として不可能です。

【よくある誤解と補足】

「自分のWindows PCやMacでLinuxコンテナを動かしている」という方も多いでしょう。これは、Docker Desktopのような開発者向けツールが、内部的に軽量なLinux仮想マシンを自動で起動し、その上でコンテナを動作させているためです。つまり、実際には仮想マシンを介しており、ホストOS上で直接実行しているわけではありません。この方法は開発用途では非常に便利ですが、本番環境のサーバーでは、パフォーマンスや安定性の観点から、ホストOSとコンテナのOS種別を一致させることが一般的です。

仮想マシンとの使い分けが重要

この制約は、コンテナが仮想マシンを完全に置き換えるものではないことを示しています。

- コンテナが適しているケース: アプリケーションをOSから分離し、軽量かつポータブルに実行したい場合。マイクロサービスアーキテクチャのように、多数のアプリケーションコンポーネントを効率的に動かしたい場合。

- 仮想マシンが適しているケース: ホストOSとは全く異なる種類のOS環境(例: Linuxサーバー上でWindowsアプリケーションを動かす)が必要な場合。OSレベルでの強力な分離が求められる、セキュリティ要件の非常に厳しいシステムを構築する場合。レガシーなアプリケーションをOS環境ごとそのまま新しいハードウェアに移行したい場合。

このように、コンテナと仮想マシンは競合する技術であると同時に、互いの弱点を補い合う補完的な関係にもあります。それぞれの特性を理解し、目的や要件に応じて適切に使い分けることが、効果的なインフラ設計の鍵となります。

② 複数のコンテナの管理が複雑になりやすい

コンテナの導入が容易であることから、最初は数個のコンテナを手動で管理することから始まるかもしれません。しかし、コンテナの利用が本格化し、本番環境で数十、数百、あるいは数千ものコンテナが稼働するようになると、手動での管理はすぐに限界に達し、新たな複雑性が生じます。これは「コンテナスプロール(Container Sprawl)」とも呼ばれる課題です。

具体的には、以下のような管理上の課題が顕在化します。

- ライフサイクル管理の煩雑さ: 多数のコンテナをどのサーバーに配置(スケジューリング)し、どのように起動・停止・監視・更新するか。コンテナが予期せず停止した場合、それを検知して自動で再起動させる仕組みも必要です。

- ネットワーク設定の複雑化: コンテナ間の通信をどう実現するか。外部からのリクエストを複数のコンテナにどうやって振り分けるか(負荷分散)。コンテナは起動・停止のたびにIPアドレスが変わる可能性があるため、固定的なIPアドレスに依存しない通信の仕組み(サービスディスカバリ)も必要になります。

- ストレージ管理: コンテナは基本的にステートレス(状態を持たない)であり、コンテナを削除すると内部のデータも消えてしまいます。データベースのようにデータを永続化する必要があるアプリケーションでは、コンテナの外にデータを保存するための永続ストレージをどのように接続・管理するかが課題となります。

- 監視(モニタリング)とロギング: 大量のコンテナのCPUやメモリ使用率、稼働状況をどのように効率的に監視するか。また、各コンテナが出力するログを一元的に収集し、分析するための仕組みも不可欠です。

コンテナオーケストレーションツールの必要性

これらの複雑な課題を解決するために登場したのが、「コンテナオーケストレーションツール」です。その代表格がKubernetes(クバネティス)です。

Kubernetesは、多数のコンテナをクラスタとして統合管理し、デプロイ、スケーリング、障害時の自動復旧(自己修復)、ネットワーク設定などを自動化するためのプラットフォームです。コンテナを本格的に本番環境で運用する上では、今やKubernetesのようなオーケストレーションツールの導入が必須となっています。

学習コストの高さ

しかし、これは同時に新たな課題も生み出します。コンテナ技術そのものに加え、Docker、Kubernetes、そしてそれらを取り巻くネットワーキング、ストレージ、セキュリティ、監視といった広範なエコシステムに関する知識を習得する必要があり、学習コストが非常に高いという点が導入の障壁となることがあります。単純にアプリケーションをコンテナ化するだけでなく、それを安定的に運用するためのプラットフォーム全体を設計・構築・維持管理できるスキルを持ったエンジニアの確保や育成が不可欠です。

代表的なコンテナ関連ツール

コンテナ技術を語る上で欠かせないのが、そのエコシステムを形成する中心的なツールである「Docker」と「Kubernetes」です。これらはコンテナ技術の普及と発展に決定的な役割を果たしてきました。それぞれのツールの概要と役割について解説します。

Dockerとは

Dockerは、コンテナ技術を誰でも手軽に利用できるようにした、オープンソースのプラットフォームです。2013年の登場以来、コンテナ技術の代名詞的な存在となり、事実上の業界標準(デファクトスタンダード)としての地位を確立しました。Dockerは、コンテナの作成(ビルド)、共有(シップ)、実行(ラン)という一連のプロセスを劇的に簡素化します。

Dockerプラットフォームは、いくつかの主要なコンポーネントで構成されています。

Dockerイメージ

Dockerイメージは、コンテナを作成するための「設計図」あるいは「テンプレート」に相当します。読み取り専用のファイルであり、アプリケーションを実行するために必要なものがすべて含まれています。

- アプリケーションのソースコードまたは実行ファイル

- OSの基本部分(例: Ubuntu, Alpine Linux)

- ライブラリ、ミドルウェア、フレームワークなどの依存関係

- 環境変数や設定ファイル

- コンテナ起動時に実行されるコマンド

イメージは「レイヤー」と呼ばれる階層構造になっているのが特徴です。例えば、Ubuntuのベースイメージの上に、Webサーバー(Nginx)をインストールするレイヤー、次にアプリケーションのコードをコピーするレイヤー、というように、変更が層のように積み重なっていきます。この構造により、イメージの更新時には変更があったレイヤーのみをダウンロードすればよいため、効率的な管理と高速な転送が可能になります。

Dockerコンテナ

Dockerコンテナは、Dockerイメージを実行した状態の実体(インスタンス)です。イメージという設計図を元に、実際にメモリ上で動作しているプロセスがコンテナです。

イメージは読み取り専用ですが、コンテナが起動すると、その上に書き込み可能なレイヤーが追加されます。コンテナ内でのファイルの作成や変更は、すべてこの書き込み可能レイヤーに対して行われます。ただし、コンテナを削除すると、このレイヤーも一緒に破棄されるため、データは失われます。データを永続化したい場合は、「ボリューム」という仕組みを使って、ホストマシンのファイルシステムや専用のストレージ領域をコンテナにマウントする必要があります。

Dockerfile

Dockerfileは、Dockerイメージをどのように作成するかという手順を記述したテキストファイルです。FROM(ベースイメージの指定)、RUN(コマンドの実行)、COPY(ファイルのコピー)、CMD(コンテナ起動時のデフォルトコマンド)といった簡単な命令を上から順に記述するだけで、誰でも同じイメージを再現性高くビルドできます。

Dockerfileによって、インフラ環境の構成がコードとして管理(Infrastructure as Code)できるようになり、バージョン管理システム(Gitなど)で変更履歴を追跡することも可能です。これは、環境構築の自動化と標準化に大きく貢献します。

Docker Hub

Docker Hubは、Docker社が公式に提供している世界最大のコンテナイメージレジストリ(保管・共有サービス)です。GitHubのDockerイメージ版と考えると分かりやすいでしょう。

世界中の開発者が作成したイメージが公開されており、UbuntuやCentOSといったOS、NginxやMySQLといったミドルウェアの公式イメージも多数提供されています。これらの公開イメージをベースに、自分のアプリケーションを追加するだけで、簡単に独自のイメージを作成できます。また、非公開のプライベートリポジトリを作成し、組織内でのみイメージを安全に共有することも可能です。

Kubernetesとは

Kubernetes(よくK8sと略されます)は、Googleが社内で使用していたコンテナ管理システム(Borg)を元に開発された、オープンソースのコンテナオーケストレーションシステムです。現在はCloud Native Computing Foundation (CNCF)という非営利団体によってホストされ、コミュニティ主導で開発が進められています。

前述のデメリットで挙げた「多数のコンテナ管理の複雑さ」という課題を解決するために生まれました。手動でのコンテナ管理が困難になるような、大規模で複雑な本番環境において、その真価を発揮します。

複数のコンテナ管理を自動化する(コンテナオーケストレーション)

Kubernetesの役割は、複数のサーバー(物理または仮想)からなるクラスタ全体を一つの大きなリソースプールとみなし、そこに多数のコンテナを効率的に配置し、その運用を自動化することです。Kubernetesが提供する主な機能は以下の通りです。

- 宣言的な設定とデプロイの自動化: ユーザーは「このアプリケーションのコンテナを3つ常に稼働させておきたい」といった「あるべき状態」をYAML形式の設定ファイルで宣言します。Kubernetesは、現在の状態と宣言された状態を常に比較し、差があれば自動的にコンテナを起動・停止して、あるべき状態を維持しようとします。

- 自己修復(セルフヒーリング): コンテナがクラッシュしたり、コンテナが稼働しているサーバー(ノード)自体が故障したりした場合、Kubernetesがそれを自動的に検知します。そして、別の正常なノード上で新しいコンテナを起動し、サービスを継続させます。

- オートスケーリング: CPU使用率などのメトリクスを監視し、負荷が高くなれば自動的にコンテナの数を増やし(スケールアウト)、負荷が低くなれば減らす(スケールイン)といった、自動的なスケーリングが可能です。これにより、リソースを効率的に使いながら、サービスの安定性を保つことができます。

- サービスディスカバリと負荷分散: 複数のコンテナで構成されるサービスに対して、単一の安定したアクセスポイント(IPアドレスとDNS名)を提供します。外部からのリクエストは、このアクセスポイントを通じて、稼働中の正常なコンテナに自動的に振り分けられます(ロードバランシング)。

- ローリングアップデートとロールバック: アプリケーションを新しいバージョンにアップデートする際、古いコンテナを一度にすべて停止させるのではなく、新しいコンテナを少しずつ起動しながら古いものを順次停止していく「ローリングアップデート」を自動で行います。これにより、サービスを停止することなく(無停止で)デプロイが可能です。また、新しいバージョンに問題があった場合には、コマンド一つで簡単に以前のバージョンに切り戻す(ロールバック)こともできます。

Dockerが個々のコンテナを扱うための基本的なツールであるのに対し、Kubernetesは、それら無数のコンテナの集合体を、一つのシステムとして協調動作させるための高度な管理・制御システムと言えるでしょう。

コンテナ技術の主な活用シーン

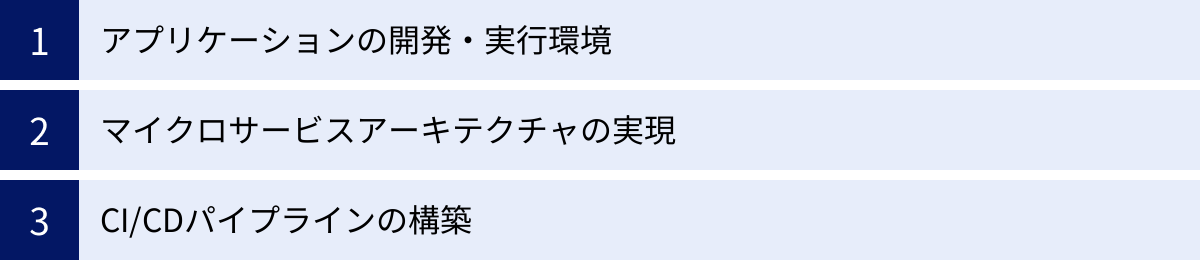

コンテナ技術は、その柔軟性と効率性から、現代のソフトウェア開発におけるさまざまな場面で活用されています。ここでは、その代表的な3つの活用シーンを紹介します。

アプリケーションの開発・実行環境

コンテナ技術の最も基本的かつ普遍的な活用シーンは、日々のアプリケーション開発と、その実行環境としての利用です。

開発者は、自身のローカルPC上で本番環境とほぼ同一の環境をコンテナとして簡単に再現できます。特に「Docker Compose」のようなツールを使うと、Webサーバー、アプリケーションサーバー、データベース、キャッシュサーバーといった、アプリケーションを構成する複数のサービス(コンテナ)を一つの設定ファイル(docker-compose.yml)で定義し、docker-compose upというコマンド一発で、それらすべてを起動・連携させることができます。

これにより、以下のようなメリットがもたらされます。

- 環境構築時間の劇的な短縮: 従来数日かかっていた複雑な開発環境のセットアップが、数分で完了します。

- 開発効率の向上: 開発者はインフラのセットアップに煩わされることなく、本来の業務であるアプリケーションのコーディングに集中できます。

- チーム開発の円滑化: チームメンバー全員が全く同じ開発環境を共有できるため、「私の環境では動くのに」という不毛なトラブルがなくなります。

そして、開発で使われたコンテナイメージは、そのままテスト環境、ステージング環境、本番環境へと持ち込むことができます。開発から本番まで一貫した環境が保証されるため、デプロイの信頼性が大幅に向上します。このシンプルかつ強力な活用法が、コンテナ技術が広く普及した最大の理由の一つです。

マイクロサービスアーキテクチャの実現

コンテナ技術は、マイクロサービスアーキテクチャというモダンなアプリケーション設計手法を実現するための理想的な基盤技術です。

マイクロサービスアーキテクチャとは、従来の一枚岩の巨大なアプリケーション(モノリシックアーキテクチャ)を、ビジネスの機能単位で分割された、多数の小さく独立したサービス群として構築するアプローチです。例えば、ECサイトであれば、「ユーザー管理」「商品カタログ」「注文処理」「決済」といった機能が、それぞれ独立したサービスとして開発・運用されます。

このアーキテクチャとコンテナは、以下のような点で非常に高い親和性を持ちます。

- 独立したデプロイとスケーリング: 各マイクロサービスを個別のコンテナとしてパッケージ化することで、他のサービスに影響を与えることなく、独立してデプロイやアップデートができます。また、特定のサービス(例: セール期間中の注文処理サービス)に負荷が集中した場合、そのサービスのコンテナだけをスケールアウト(数を増やす)させることが可能です。

- 技術スタックの多様性(ポリグロット): 各サービスは独立しているため、その機能に最も適したプログラミング言語、フレームワーク、データベースを自由に選択できます。例えば、ユーザー管理サービスはJavaで、商品検索サービスは高速な検索が得意なGoで開発し、それぞれをコンテナとして動かす、といったことが可能です。

- 回復力の向上: ある一つのサービスに障害が発生しても、システム全体が停止するのを防ぐことができます。影響をそのサービスだけに限定し、他のサービスは正常に稼働し続けることが可能です。

コンテナは、マイクロサービスという独立したコンポーネントを、軽量かつポータブルにカプセル化するための最適な「入れ物」として機能します。そして、Kubernetesのようなオーケストレーションツールが、これら多数のコンテナ化されたサービス間の複雑な連携やライフサイクル管理を担うことで、大規模なマイクロサービスシステムの安定運用が実現可能になります。

CI/CDパイプラインの構築

CI/CD(Continuous Integration / Continuous Delivery/Deployment – 継続的インテグレーション / 継続的デリバリー・デプロイメント)は、ソフトウェアの変更を迅速かつ確実にユーザーに届けるための自動化された仕組みです。コンテナ技術は、このCI/CDパイプラインの各段階を劇的に効率化・高速化します。

CI/CDパイプラインにおけるコンテナの役割は以下の通りです。

- CI (継続的インテグレーション) フェーズ:

- 開発者がソースコードを変更し、Gitなどのバージョン管理システムにプッシュします。

- JenkinsやGitLab CIといったCIツールがその変更を検知し、ビルドプロセスを開始します。

- このとき、ビルドや単体テスト、結合テストといった処理を、毎回新しく起動したクリーンなコンテナ内で行います。これにより、実行環境の差異によるテストの失敗を防ぎ、信頼性の高い一貫したテスト結果を得ることができます。

- 成果物としてのコンテナイメージ:

- すべてのテストに合格すると、CIプロセスの最終的な成果物として、アプリケーションを含むテスト済みのDockerイメージがビルドされます。このイメージは、特定のバージョンタグを付けて、Docker HubやAWS ECRなどのコンテナレジストリにプッシュ(保存)されます。

- CD (継続的デリバリー/デプロイメント) フェーズ:

- 新しいイメージがレジストリにプッシュされると、Argo CDやSpinnakerといったCDツールがそれをトリガーとして、本番環境へのデプロイプロセスを自動的に開始します。

- Kubernetesのような環境では、ローリングアップデート機能を使って、古いバージョンのコンテナを新しいイメージのコンテナへと、サービスを停止することなく安全に入れ替えます。

このように、コンテナはCI/CDパイプライン全体を通じて、「一貫性のある実行環境」と「ポータブルなビルド成果物」という二つの重要な役割を果たします。これにより、開発からテスト、デプロイまでのリードタイムが大幅に短縮され、ビジネスの要求に迅速に対応できるアジャイルな開発体制の構築が可能になるのです。

まとめ

本記事では、現代のITインフラを支える中核技術である「コンテナ技術」について、その基本的な概念から仕組み、メリット・デメリット、そして具体的な活用シーンに至るまで、網羅的に解説してきました。

改めて、この記事の重要なポイントを振り返ります。

- コンテナ技術は、アプリケーションをその依存関係と共に「コンテナ」という一つのパッケージにまとめ、どんな環境でも一貫して、軽量かつ高速に実行するためのOSレベルの仮想化技術です。

- 従来の仮想マシン(VM)がゲストOSを必要とするのに対し、コンテナはホストOSのカーネルを共有するため、起動が速く、リソース消費が少ないという大きな利点があります。

- 導入のメリットとして、①高速・軽量な動作、②開発環境構築の容易さ、③サーバーリソースの効率化、④高い可搬性、⑤セキュリティの向上などが挙げられ、開発から運用までの生産性を飛躍的に向上させます。

- 一方で、①ホストOSと異なる種類のOSは動かせないという制約や、②多数のコンテナ管理が複雑化し、Kubernetesのようなオーケストレーションツールの習得が必要になるといった注意点も存在します。

- エコシステムの中心には、コンテナの作成・実行を容易にするDockerと、多数のコンテナの運用を自動化するKubernetesがあり、これらを組み合わせることで、マイクロサービスアーキテクチャやCI/CDパイプラインといったモダンな開発・運用スタイルが実現可能になります。

コンテナ技術は、単なる一過性のトレンドではなく、クラウドネイティブ時代におけるアプリケーション開発と運用のスタンダードとなりつつあります。この技術を理解し活用することは、変化の激しいビジネス環境において競争力を維持し、より良いサービスを迅速にユーザーへ届け続けるための不可欠な要素と言えるでしょう。

もちろん、学習すべき領域は広く、導入には計画的なアプローチが必要ですが、その投資に見合うだけの大きな価値をもたらしてくれます。もしあなたがこれからコンテナ技術の世界に足を踏み入れるのであれば、まずはご自身のPCにDockerをインストールし、簡単なWebアプリケーションをコンテナで動かしてみることから始めてみてはいかがでしょうか。小さな一歩が、新しい開発スタイルの扉を開くきっかけになるはずです。